Guten Morgen!

Wer die Entwicklungen der Woche nebeneinanderlegt, erkennt eine leise, aber tiefgreifende Verschiebung. Technologie erscheint nicht mehr als neutrale Fortschrittsmaschine, sondern als bewusst gestaltetes Machtinstrument. Staaten, Konzerne und Kapital bündeln Ressourcen, umgehen Grenzen und organisieren Innovation zunehmend strategisch und das jenseits klassischer Marktlogiken.

Auffällig ist dabei die neue Nüchternheit des Fortschritts. Nicht das Spektakuläre steht im Vordergrund, sondern das Beherrschbare: effizientere Modelle, kontrollierbare Infrastrukturen, berechenbare Skalierung. Intelligenz wird weniger erfunden als eingehegt – und genau darin liegt ihre wachsende Wirkung.

Wir wünschen Ihnen in diesen Tagen ruhige Feiertage, Zeit zum Durchatmen und einen klaren Blick auf das, was technologisch vor uns liegt. Frohe Weihnachten! 🎄

Damit das KI-Briefing für Sie maximal nützlich bleibt, freuen wir uns über Ihr Feedback. Teilen Sie uns gerne mit, welche Impulse für Sie am wertvollsten sind – und helfen Sie dabei, unser Briefing in Ihrem Netzwerk bekannt zu machen. Gemeinsam können wir eine Community aufbauen, die voneinander lernt und sich gegenseitig stärkt. Falls Sie diesen Newsletter weitergeleitet bekommen haben, können Sie sich ganz einfach hier anmelden.

Was Sie in diesem Briefing erwartet

News: China baut geheime EUV Maschinen gegen ASMLs Dominanz, KI-Agenten verändern die Zahlungslogik des Internets, NOAA beschleunigt Wettervorhersagen mit KI Modellen, OpenAI strebt Finanzierung mit Rekordbewertung an, Google skaliert Gemini 3 Flash als neues KI Arbeitstier, Nvidia prüft Ausbau der H200 Produktion für China & Yann LeCun startet AMI für nächste KI Generation

Deep Dive: Warum Europas Startup-Hubs mit Vielfalt und Kooperation eine neue Innovationskraft entfalten

In aller Kürze: NVIDIA Nemotron 3 als offene und effiziente Modellfamilie für agentische KI Systeme, Google und Meta treiben mit TorchTPU die PyTorch Unterstützung für Googles KI Chips voran, FrontierScience etabliert einen neuen Benchmark für wissenschaftliches KI Denken, Bloom ermöglicht skalierbare und reproduzierbare Verhaltensanalysen von KI Modellen & OpenAI öffnet ChatGPT für veröffentlichbare Apps mit neuen Entwicklungs und Monetarisierungsoptionen

Videos & Artikel: KI Agenten setzen einfache SaaS Produkte unter Druck und verschieben den Build versus Buy Entscheid, Inference Ökonomie teilt sich in reservierten Compute und skalierbare Inference APIs auf, Mega Deals im KI Sektor werfen Fragen nach Nachhaltigkeit und systemischen Risiken auf, Scale AI erweitert Reinforcement Learning mit Rubrics as Rewards auf komplexe Domänen & KI schafft neue Berufsbilder und erhöht den Wert menschlicher Fähigkeiten

Impuls: Warum echte Denker selten sind

Umfrage: Was bremst aus Ihrer Sicht derzeit strategische Automatisierungsentscheidungen am stärksten?

Monitoring Europe: Ignite Next treibt Europas Deep-Tech Scaleups in die industrielle Realität

Praxisbeispiel: Warum du mit Workflows statt mit KI-Agenten starten solltest

YouTube: Wie eine KI modular Rechnen lernte und dabei fast menschlich wirkte

Transformation

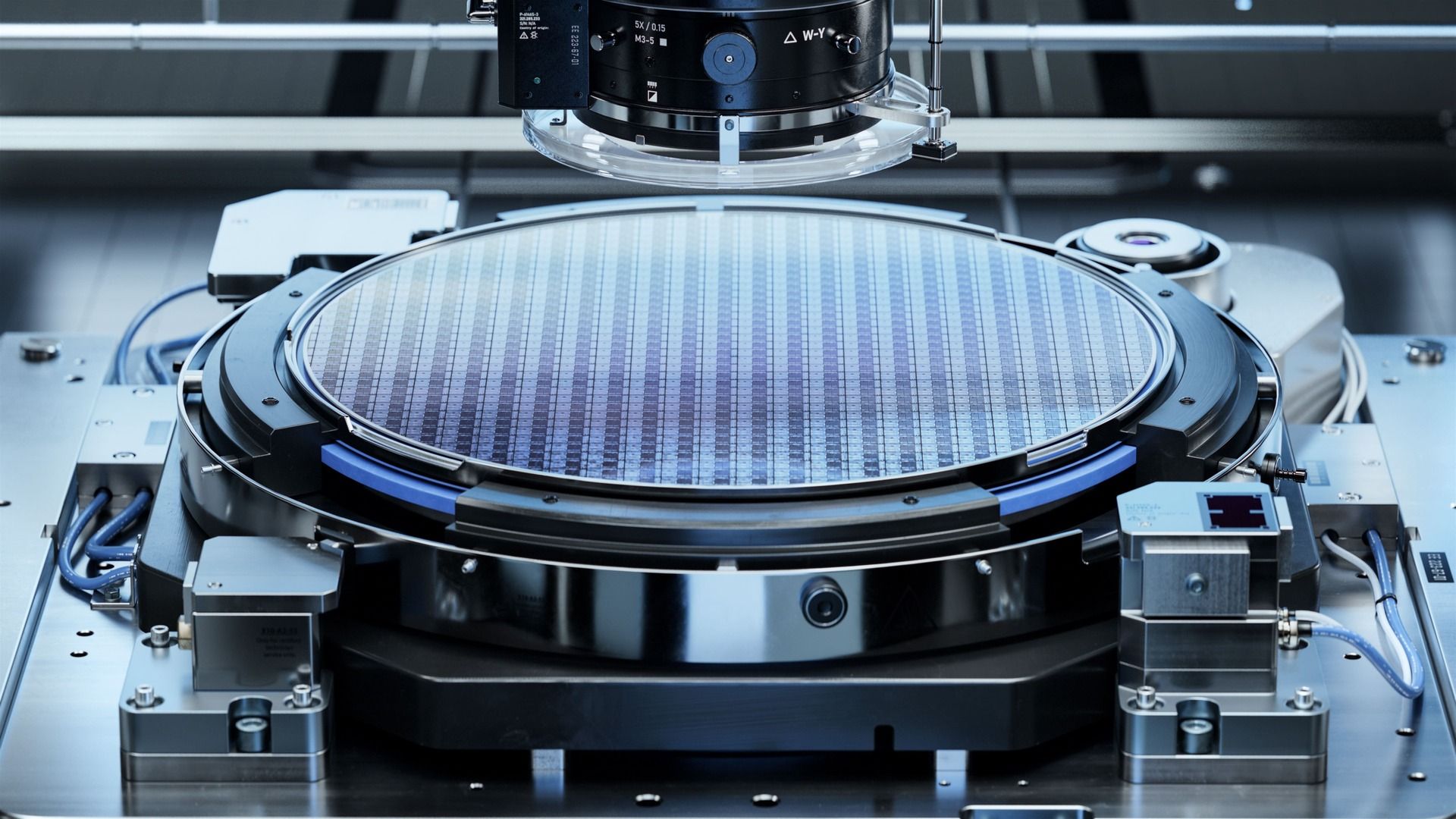

China baut geheime EUV Maschinen gegen ASMLs Dominanz

Quelle: Shutterstock

Zusammenfassung: China hat in einem streng abgeschotteten Hochsicherheitslabor in Shenzhen einen funktionsfähigen Prototypen einer EUV-Lithografiemaschine gebaut – jener Schlüsseltechnologie, die bisher ausschließlich vom niederländischen Konzern ASML beherrscht wird. Der Prototyp wurde Anfang 2025 fertiggestellt, erzeugt bereits extrem ultraviolettes Licht, hat jedoch noch keine marktfähigen Chips produziert. Das Projekt ist Teil einer seit Jahren laufenden staatlichen Initiative zur technologischen Selbstversorgung und wird intern als Chinas „Manhattan-Projekt“ bezeichnet. Trotz massiver Exportkontrollen und technischer Hürden könnte China damit deutlich schneller zur strategischen Halbleiterunabhängigkeit gelangen als bislang angenommen.

Technologischer Durchbruch bei EUV Lichtquellen: Der chinesische Prototyp ist erstmals in der Lage, stabile EUV-Strahlung zu erzeugen, ein zentraler Engpass der modernen Chipfertigung. Auch wenn bislang keine funktionsfähigen Chips entstanden sind, markiert die operative Lichtquelle einen entscheidenden Schritt in Richtung eigenständiger Hochleistungs-Halbleiterproduktion.

Systematische Rekrutierung westlicher Schlüsselkräfte: Ehemalige ASML-Ingenieure spielen eine zentrale Rolle beim Nachbau der Maschinen. China setzt gezielt auf hohe Prämien, verdeckte Identitäten und abgeschottete Arbeitsumgebungen, um kritisches Know-how zu sichern und Exportrestriktionen technologisch zu umgehen.

Staatlich koordinierte Industrialisierung unter Führung von Huawei: Tausende Ingenieure aus Forschungseinrichtungen und Unternehmen arbeiten arbeitsteilig an Komponenten, Optiken und Reverse Engineering. Huawei fungiert als Integrator entlang der gesamten Wertschöpfungsketten – von Maschinen über Chips bis zu Endprodukten – mit direkter Anbindung an die politische Führung.

Warum das wichtig ist: Der Aufbau eigener EUV-Fähigkeiten zeigt, dass technologische Blockaden selbst bei extrem komplexen Schlüsseltechnologien langfristig überwunden werden können, wenn staatliche Priorisierung, Kapital und Talent konsequent gebündelt werden. Für globale Technologiemärkte bedeutet das: Monopole in kritischer Infrastruktur sind weniger stabil als gedacht. Der Fall unterstreicht, dass strategische Abhängigkeiten nicht nur durch Marktmechanismen, sondern vor allem durch geopolitische Entschlossenheit neu geordnet werden. Innovationsführerschaft wird damit zunehmend zur Frage nationaler Organisation, nicht nur technologischer Exzellenz.

Zahlungsinfrastruktur

KI-Agenten verändern die Zahlungslogik des Internets

Quelle: Shutterstock

Zusammenfassung: Mit dem Aufkommen autonomer KI-Agenten formiert sich eine neue Internetökonomie, in der Software nicht nur Daten austauscht, sondern auch selbstständig bezahlt. Zentrale Bausteine sind neue Zahlungsprotokolle wie x402, das Zahlungen direkt in HTTP-Anfragen integriert, sowie spezialisierte Abwicklungssysteme wie Tempo, eine von Stripe und Paradigm unterstützte Blockchain für maschinelle Zahlungen. Statt werbefinanzierter Inhalte rücken transaktionsbasierte API-Zugriffe und Micropayments in den Mittelpunkt. Hochwertige Daten werden damit zur unmittelbar monetarisierbaren Ressource für KI-Systeme.

HTTP 402 wird zur Basis für Agentenökonomie: Mit x402 können API-Aufrufe automatisch bepreist und bezahlt werden, ohne menschliche Interaktion. Seit dem Start 2025 wurden bereits über 100 Millionen solcher Zahlungen abgewickelt, insbesondere für KI-Agenten, Inferenz-Workloads und datenintensive Anwendungen.

Daten ersetzen Aufmerksamkeit als monetäre Einheit: In einer agentischen Welt konsumieren Maschinen keine Werbung, sondern strukturierte Informationen. Der wirtschaftliche Wert verschiebt sich von Reichweite zu Datenqualität, wobei jede Abfrage direkt vergütet wird und hochwertige, verlässliche Datensätze Premiumpreise erzielen.

Neue Infrastruktur für maschinelle Wertschöpfung: Systeme wie Tempo und datenbanknahe Ansätze wie OnChainDB verlagern Erlöse von Plattformbetreibern zu Datenproduzenten. Jede Lese- oder Schreiboperation kann bepreist werden, inklusive automatischer Erlösaufteilung zwischen mehreren Datenquellen.

Warum das wichtig ist: Die Entstehung von Machine-to-Machine-Payments zeigt einen strukturellen Bruch mit der bisherigen Internetökonomie. Werbe- und Abomodell skalieren nicht in einer Welt autonomer Agenten, deren Aktionen Kosten verursachen und unmittelbaren Nutzen generieren. Unternehmen, die früh auf transaktionale Datenmodelle, API-basierte Erlösströme und eingebettete Zahlungssysteme setzen, sichern sich strategische Kontrolle über künftige Wertschöpfungsketten. Die Frage ist nicht mehr, ob Maschinen zahlen – sondern wer an diesen Zahlungen partizipiert.

Hochleistungsrechnen

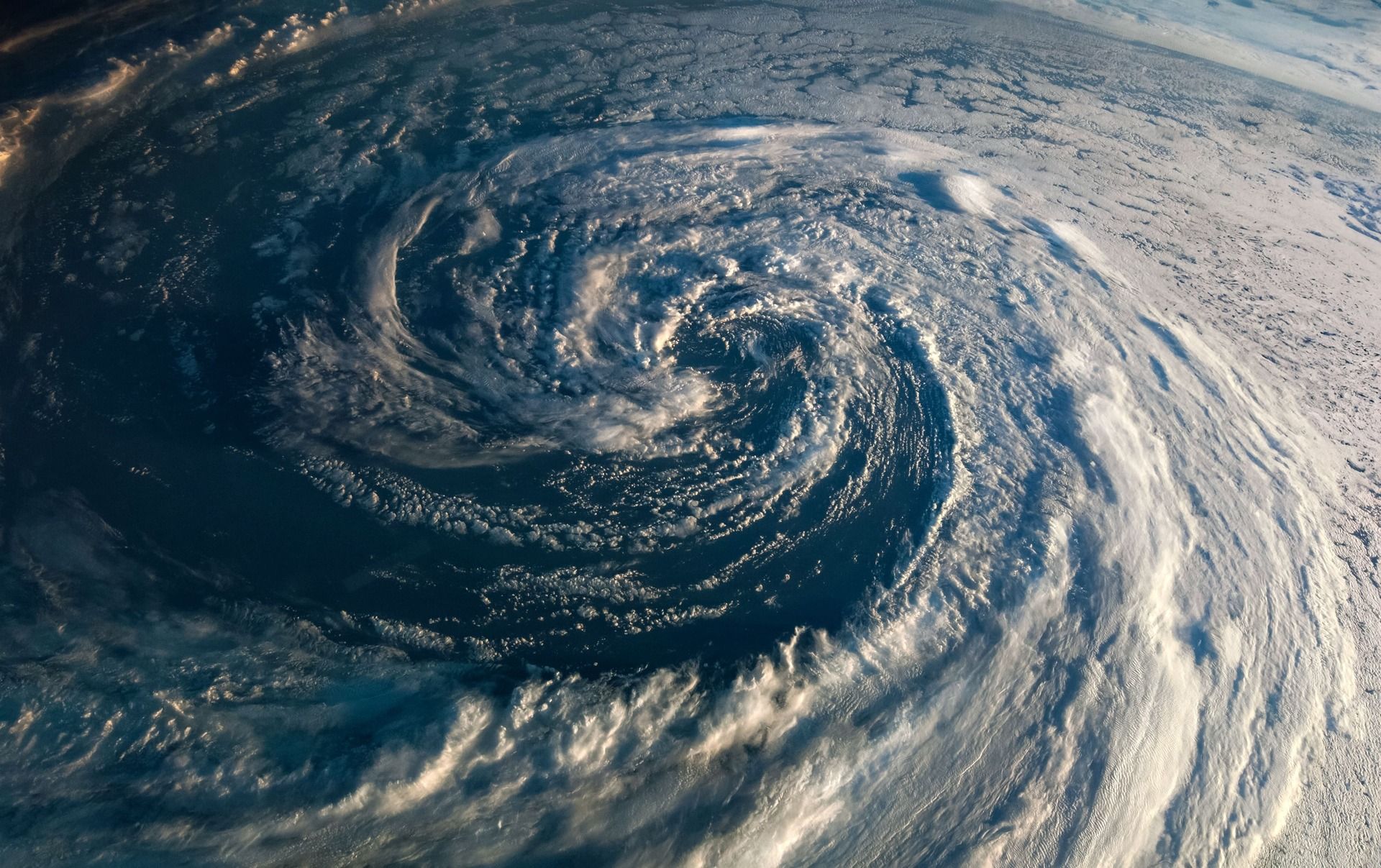

NOAA beschleunigt Wettervorhersagen mit KI Modellen

Quelle: Shutterstock

Zusammenfassung: Die US-Wetterbehörde NOAA hat eine neue Generation operativer, KI-gestützter globaler Wettermodelle in Betrieb genommen und damit einen grundlegenden Technologiesprung in der Wettervorhersage vollzogen. Die neuen Modelle liefern Prognosen deutlich schneller, präziser und mit massiv reduziertem Rechenaufwand im Vergleich zu klassischen physikbasierten Systemen. Kern des Ansatzes ist eine Kombination aus reinen KI-Modellen und hybriden Ensembles, die künstliche Intelligenz mit etablierten physikalischen Verfahren verbinden. Erste Ergebnisse zeigen längere Vorhersagezeiträume, geringere Fehler bei Großwetterlagen und substanzielle Effizienzgewinne für operative Wetterdienste.

Radikale Effizienzsteigerung durch KI Forecast Systeme: Das neue AIGFS-Modell benötigt für eine 16-Tage-Prognose nur rund 0,3 Prozent der bisherigen Rechenressourcen und liefert Ergebnisse innerhalb von etwa 40 Minuten. Damit sinken Kosten, Energiebedarf und Zeitverzug erheblich, während die Prognosegüte bei großskaligen Wettermustern steigt.

Ensemble Modelle verlängern verlässliche Vorhersagefenster: Das KI-basierte AIGEFS verbessert die Ensemble-Vorhersage und verlängert die nutzbare Prognosegenauigkeit um bis zu 24 Stunden. Entscheidern steht damit früher ein belastbares Wahrscheinlichkeitsbild für extreme Wetterlagen zur Verfügung.

Hybrid Ansatz setzt neuen Industriestandard: Mit dem HGEFS kombiniert NOAA erstmals physikbasierte und KI-basierte Ensemblemodelle in einem operativen System. Dieser hybride Ansatz übertrifft beide Einzelmodelle konsistent und bildet Unsicherheiten robuster ab als bisherige Verfahren.

Warum das wichtig ist: Die Einführung operativer KI-Wettermodelle verändert den Umgang mit kritischen Infrastrukturen weltweit grundlegend. Wettervorhersage wird von einer rechenintensiven Hochleistungsdisziplin zu einer skalierbaren, datengetriebenen Kerntechnologie. Das senkt Eintrittsbarrieren, beschleunigt Entscheidungsprozesse in Energie, Logistik und Katastrophenschutz und verschiebt die strategische Bedeutung von Supercomputing hin zu Datenqualität und Modellintegration. Wer diese Fähigkeiten beherrscht, gewinnt einen strukturellen Vorteil bei Resilienz, Planungssicherheit und wirtschaftlicher Steuerung unter Klimarisiken.

Kapitalmarkt

OpenAI strebt Finanzierung mit Rekordbewertung an

Quelle: Shutterstock

Zusammenfassung: OpenAI verhandelt über eine neue Finanzierungsrunde von bis zu 100 Milliarden US-Dollar, die das Unternehmen mit bis zu 830 Milliarden US-Dollar bewerten könnte. Damit würde der ChatGPT-Entwickler in eine neue Größenordnung globaler Technologiekonzerne vorstoßen. Die Runde soll noch im ersten Quartal abgeschlossen werden und könnte gezielt staatliche Investoren einbeziehen. Hintergrund sind massiv steigende Investitionen in Recheninfrastruktur, Modelltraining und Inferenz sowie der wachsende Wettbewerbsdruck im globalen KI-Markt. Parallel verdichten sich Hinweise auf langfristige IPO-Pläne.

Kapitalbedarf explodiert durch Rechen und Inferenzkosten: OpenAI benötigt frisches Kapital vor allem für den Betrieb und die Skalierung von KI-Systemen, deren laufende Inferenzkosten zunehmend nicht mehr durch Cloud-Gutschriften gedeckt werden. Das signalisiert einen strukturellen Übergang von Forschungsfinanzierung zu kapitalintensiver industrieller KI-Produktion.

Souveräne Investoren und strategische Partner im Fokus: Berichten zufolge spricht OpenAI gezielt Staatsfonds an, ergänzt durch mögliche Großinvestments aus dem Tech-Sektor. Damit verschiebt sich die Finanzierungslogik von klassischem Venture Capital hin zu geopolitisch und industriepolitisch motiviertem Langfristkapital.

Bewertung reflektiert Plattform Anspruch im KI Ökosystem: Eine Bewertung jenseits von 800 Milliarden US-Dollar basiert weniger auf aktuellen Umsätzen als auf der Erwartung, dass OpenAI zur zentralen Infrastruktur für generative KI, Entwicklerplattformen und agentenbasierte Systeme wird – trotz wachsender Konkurrenz von Google und Anthropic.

Warum das wichtig ist: Die geplante Finanzierungsrunde zeigt, dass sich KI von einer innovationsgetriebenen Softwareindustrie zu einer kapital- und infrastrukturlastigen Machtkonzentration entwickelt, in der Zugang zu Rechenleistung, Chips und langfristigem Kapital über strategische Handlungsfähigkeit entscheidet. Für Europa entsteht daraus ein Souveränitätsrisiko, da zentrale KI-Funktionen zunehmend von außereuropäischen Plattformen kontrolliert werden und Abhängigkeiten ähnlich wie im Energie- oder Cloud-Sektor drohen. Eine tragfähige Antwort liegt weniger im Versuch, einzelne Champions zu kopieren, sondern im Aufbau offener Modelle, interoperabler Standards und europäischer Rechen- und Energieallianzen, die strategische Autonomie sichern, Wettbewerb ermöglichen und politische wie wirtschaftliche Resilienz stärken.

Skalierung

Google skaliert Gemini 3 Flash als neues KI Arbeitstier

Quelle: Google

Zusammenfassung: Google hat mit Gemini 3 Flash ein neues KI-Modell vorgestellt, das leistungsstarke Reasoning-Fähigkeiten mit extrem niedriger Latenz und deutlich geringeren Kosten kombiniert. Das Modell erweitert die Gemini-3-Familie und ist darauf ausgelegt, frontier-nahe Intelligenz breit skalierbar zu machen – für Entwickler, Unternehmen und Endnutzer. Gemini 3 Flash erreicht auf anspruchsvollen Benchmarks ein Niveau vergleichbar mit deutlich größeren Modellen, benötigt dabei aber wesentlich weniger Rechenressourcen. Der Rollout erfolgt global über Google-Produkte, APIs und Enterprise-Plattformen.

Frontier Leistung bei drastisch geringeren Kosten: Gemini 3 Flash erzielt starke Ergebnisse bei komplexem Reasoning, multimodalen Aufgaben und Coding, nutzt dabei aber rund 30 Prozent weniger Tokens als frühere Modelle und ist bis zu dreimal schneller. Damit verschiebt Google die Kosten-Leistungs-Grenze für produktive KI signifikant.

Agentische Workflows und Entwicklerfokus: Das Modell ist für iterative, hochfrequente Workflows optimiert und übertrifft frühere Gemini-Versionen sogar bei Coding-Agenten-Benchmarks. Besonders für produktionsnahe Systeme, Echtzeitanwendungen und multimodale Analysen entsteht damit ein neuer Standard.

Breite Integration als strategischer Hebel: Gemini 3 Flash wird zum Default-Modell in der Gemini App, in der KI-Suche sowie in Vertex AI und Gemini Enterprise. Damit verankert Google fortgeschrittene KI-Fähigkeiten direkt in Alltagsprodukte und Unternehmensprozesse weltweit.

Warum das wichtig ist: Gemini 3 Flash zeigt, dass sich die nächste Phase der KI nicht primär über größere Modelle, sondern über Effizienz, Geschwindigkeit und Integration entscheidet. Wer leistungsfähige Intelligenz zu niedrigen Grenzkosten anbieten kann, gewinnt strategische Kontrolle über Entwicklerökosysteme und Nutzeroberflächen. Damit verschiebt sich der Wettbewerb von reiner Modellqualität hin zu Skalierung, Distribution und operativer Exzellenz – ein entscheidender Vorteil für Plattformanbieter mit globaler Reichweite.

Exportkontrollen

Nvidia prüft Ausbau der H200 Produktion für China

Quelle: Shutterstock

Zusammenfassung: Nvidia erwägt laut Berichten eine deutliche Ausweitung der Produktion seiner H200-GPUs, nachdem die US-Regierung den Verkauf der leistungsstarken KI-Chips nach China genehmigt hat. Die Entscheidung folgt auf eine sprunghaft gestiegene Nachfrage chinesischer Technologiekonzerne, die große Bestellungen vorbereiten. Die Genehmigung ist an Auflagen geknüpft, darunter eine Beteiligung der US-Regierung an den Umsätzen. Während chinesische Behörden noch über die Importfreigabe entscheiden, signalisiert der Nachfrageschub, wie angespannt der globale Markt für Hochleistungs-KI-Hardware weiterhin ist.

Regulatorische Kehrtwende öffnet Markt: Nach jahrelangen Exportbeschränkungen darf Nvidia seine H200-GPUs wieder nach China liefern. Im Gegenzug akzeptiert der Konzern eine Reduktion seiner Erlöse, was zeigt, wie stark geopolitische Auflagen inzwischen direkt in die Margen von Halbleiterherstellern eingreifen.

Starker Nachfragesog chinesischer KI Anbieter: Unternehmen wie Alibaba und ByteDance bereiten umfangreiche Bestellungen vor, da der H200 deutlich leistungsfähiger ist als die zuvor für China angepassten Modelle. Die Chips werden insbesondere für das Training großer Sprachmodelle benötigt.

Produktionsausbau trotz Lieferkettenrisiken: Nvidia prüft zusätzliche Kapazitäten, betont jedoch, dass Lieferungen nach China keine Auswirkungen auf die Versorgung westlicher Kunden haben sollen. Die Entscheidung fällt in einer Phase global begrenzter Fertigungskapazitäten für Hochleistungs-GPUs.

Warum das wichtig ist: Der mögliche Produktionsausbau unterstreicht, dass selbst strikte Exportkontrollen die strukturelle Nachfrage nach KI-Rechenleistung nicht brechen. Hardware bleibt der zentrale Engpass im globalen KI-Wettlauf, und politische Kompromisse ersetzen zunehmend klare Marktregeln. Für die Branche bedeutet das höhere Unsicherheit, aber auch neue Erlöspotenziale in regulierten Märkten. Wer Zugang zu leistungsfähigen Chips kontrolliert, beeinflusst nicht nur technologische Entwicklung, sondern auch geopolitische Machtverhältnisse.

Startups

Yann LeCun startet AMI für nächste KI Generation

Zusammenfassung: Der renommierte französische KI-Forscher Yann LeCun hat offiziell die Gründung seines neuen Startups Advanced Machine Intelligence (AMI) bestätigt. LeCun übernimmt die Rolle des Executive Chairman, während Alex LeBrun, bisher CEO des KI-Unternehmens Nabla, die operative Führung übernimmt. AMI fokussiert sich auf sogenannte World Models – einen alternativen KI-Ansatz zu Large Language Models, der auf kausalem Weltverständnis statt rein statistischer Textgenerierung basiert. Noch vor dem Produktstart strebt das Unternehmen Berichten zufolge eine Finanzierung von rund 500 Millionen Euro bei einer Bewertung von etwa 3,5 Milliarden US-Dollar an.

World Models als strategische Alternative zu LLMs: AMI entwickelt KI-Systeme, die Ursache-Wirkungs-Zusammenhänge simulieren und Szenarien vorhersagen können. Ziel ist es, strukturelle Schwächen klassischer Sprachmodelle wie Halluzinationen zu überwinden und belastbarere Entscheidungsgrundlagen für komplexe Umgebungen zu schaffen.

Top Gründerprofil treibt frühe Milliardenbewertung: Als Turing-Award-Träger und ehemaliger Chief AI Scientist von Meta zählt LeCun zu den einflussreichsten Köpfen der KI-Forschung. Die angestrebte Bewertung reflektiert weniger Produktreife als die Erwartung, dass World Models die nächste grundlegende KI-Architektur darstellen könnten.

Erfahrener CEO mit Industrie- und Plattformerfahrung: Mit Alex LeBrun übernimmt ein Manager die Führung, der bereits multimodale KI-Systeme skaliert und mehrere Unternehmen aufgebaut hat. Parallel bleibt Nabla strategisch angebunden und plant, AMIs Modelle frühzeitig in eigene Produkte zu integrieren.

Warum das wichtig ist: Die Gründung von AMI signalisiert eine mögliche strategische Neuorientierung der KI-Entwicklung jenseits von immer größeren Sprachmodellen. Sollte sich der World-Model-Ansatz durchsetzen, würde sich der Fokus von reiner Textgenerierung hin zu simulationsfähigen Entscheidungsmaschinen verschieben. Das hätte weitreichende Folgen für Industrie, Robotik, autonome Systeme und sicherheitskritische Anwendungen. Gleichzeitig zeigt die frühe Milliardenbewertung, dass Kapitalmärkte beginnen, auf einen Paradigmenwechsel in der KI-Architektur zu wetten – lange bevor dieser technisch bewiesen ist.

EU Startups

Warum Europas Startup-Hubs mit Vielfalt und Kooperation eine neue Innovationskraft entfalten

Quelle: Death To Stock

Kann ein kleiner Staat mit nur 1,3 Millionen Einwohnern mehr Milliardenunternehmen hervorbringen als viele große Volkswirtschaften? Estland zeigt: Ja, das ist möglich – wenn die Bedingungen stimmen. Von der digitalen Verwaltung bis zum internationalen Talentmagneten haben einige europäische Regionen gezeigt, wie Innovationskraft unabhängig von Größe oder geografischer Lage entstehen kann. Gleichzeitig verschiebt sich das europäische Innovationszentrum – von einigen wenigen Metropolen hin zu einem vielschichtigen Netzwerk dynamischer Startup-Cluster.

Europa als aufstrebender Technologie-Hotspot mit globalem Anspruch

In den letzten zehn Jahren hat sich Europas Startup-Landschaft fundamental gewandelt. Das Ökosystem ist heute fünfmal größer als 2015, mit über 40.000 Startups und mehr als 400 Unicorns. Mit einer Wertschöpfungswachstumsrate von sieben Prozent jährlich und einem Beitrag von 15 Prozent zur europäischen Wirtschaftsleistung hat sich der Kontinent als ernstzunehmender globaler Tech-Standort etabliert. Besonders auffällig ist das Beschäftigungswachstum, das inzwischen das der USA übertrifft. Doch trotz dieser Fortschritte hemmen strukturelle Schwächen wie die regulatorische Fragmentierung und ein Mangel an Spätphasen-Kapital das volle Potenzial. Über ein Drittel erfahrener Gründer verlagern ihr Unternehmen ins Ausland – ein klares Signal für die Notwendigkeit besser koordinierter Rahmenbedingungen.

Regionale Erfolgsgeschichten und ihre Lehren für ganz Europa

Ein Blick in die Startup-Karten Europas offenbart eine überraschende Vielfalt: Von Lissabon bis Tallinn entstehen leistungsstarke Innovationskorridore. Während Großbritannien weiterhin führend bei Kapitalzuflüssen ist, holen andere Regionen rasant auf. Estland etwa führt pro Kopf bei Tech-Beschäftigten und Unicorns – ein Erfolg, der auf eine hochdigitale Verwaltung und eine konsequent gründerfreundliche Infrastruktur zurückgeht. Portugal verzeichnete mit einem Wachstum des Startup-Werts um das 26-Fache in weniger als einem Jahrzehnt eine spektakuläre Entwicklung. Und Österreich punktet mit gezielter Startup-Förderung, hoher Internationalität und einem wachsenden Anteil weiblicher Gründerinnen. Diese Beispiele zeigen: Innovation gedeiht dort, wo Infrastruktur, Talent und Kapital strategisch zusammengeführt werden.

Kapitalmärkte wachsen doch kritische Lücken bleiben bestehen

Das verfügbare Wagniskapital in Europa nähert sich wieder Rekordhöhen – rund 44 Milliarden Dollar flossen 2025 in Startups, insbesondere in Großbritannien, Deutschland und Frankreich. Auch die Rolle des Staates als Kapitalgeber wächst: Über EU-Programme wie den EIC Accelerator oder nationale Scale-up-Fonds entsteht ein dichtes Netz an Fördermöglichkeiten. Gleichzeitig bleibt eine Herausforderung bestehen: Der Mangel an tiefen Kapitalmärkten für große Finanzierungsrunden. Diese Lücke treibt viele wachstumsstarke Unternehmen in ausländische Märkte, insbesondere in die USA. Die vorhandenen Mittel müssen künftig gezielter mobilisiert werden – vor allem in Regionen, die bisher weniger vom Tech-Boom profitieren.

Europas Universitäten und Talente als unterschätzter Wettbewerbsvorteil

Mit rund 4,6 Millionen Beschäftigten im Tech-Sektor stellt Europa eine starke Talentbasis – besonders im Norden haben sich Länder wie Schweden, Finnland und Estland als globale Talentpools positioniert. Hochschulen wie Oxford, ETH Zürich oder die TU München sind Brutstätten für Ausgründungen in KI, Biotech und Deep-Tech. Doch der Technologietransfer in marktfähige Produkte gelingt noch nicht systematisch genug. Programme wie das EIT haben bereits Hunderttausende in Innovationskompetenzen geschult, dennoch droht bis 2027 ein Mangel von knapp vier Millionen Tech-Fachkräften. Die Aufgabe wird sein, Talente nicht nur auszubilden, sondern auch langfristig in Europa zu halten – etwa durch internationale Netzwerke, Alumni-Erfolge und attraktive Arbeitsbedingungen.

Wissen fließt schneller aber Fragmentierung bleibt ein Risiko

Europa wächst als Innovationsraum zusammen – Konferenzen wie Slush, Web Summit oder VivaTech sowie Programme wie die „Regional Innovation Valleys“ der EU fördern Austausch und Kooperation über Ländergrenzen hinweg. Gründer und Investoren lernen voneinander, teilen Erfolgsrezepte und bauen grenzüberschreitende Netzwerke auf. Digitale Communities und Open-Source-Kultur beschleunigen diesen Transfer zusätzlich. Dennoch bleibt das regulatorische Flickwerk ein Hindernis: Unterschiedliche Steuersysteme, Patentprozesse oder Regeln zur Mitarbeiterbeteiligung erschweren paneuropäische Skalierung. Der politische Druck zur Harmonisierung wächst – mit dem Ziel, Europas Innovationskraft als vereinte Plattform zu stärken.

Konzerne erkennen das Potenzial und docken sich aktiv an Startups an

Immer mehr etablierte Unternehmen in Europa erkennen, dass Startups nicht nur Impulsgeber, sondern strategische Partner sind. Der Anteil von Corporate Venture Capital an Startup-Finanzierungen hat sich in den letzten zehn Jahren mehr als verdoppelt. Konzerne wie Orange oder Raiffeisen investieren gezielt in Startups, um neue Technologien frühzeitig zu erkennen und in ihre Prozesse zu integrieren. Auch kulturell findet eine Annäherung statt: Agile Methoden, nutzerzentriertes Design und ein iteratives Mindset fließen zunehmend in Konzernstrukturen ein. Umgekehrt profitieren Startups von Marktkenntnis, Infrastruktur und Glaubwürdigkeit der Großen. Diese Symbiose schafft ein Ökosystem, in dem Innovation nicht an Unternehmensgrenzen endet, sondern entlang gemeinsamer Herausforderungen wächst.

Ein stark vernetztes Europa schafft Innovationskraft mit globaler Relevanz

Europas Startup-Cluster zeigen eindrucksvoll, dass dezentrale Innovation funktionieren kann – wenn Talent, Kapital und Wissen im Austausch stehen. Regionen entwickeln eigene Stärken, lernen voneinander und wachsen zu einem offenen Innovationsnetzwerk zusammen. Die Herausforderung bleibt, regulatorische Hürden abzubauen und Kapitalströme besser zu koordinieren. Doch die Richtung stimmt: Etablierte Unternehmen, Startups und politische Akteure agieren zunehmend gemeinschaftlich. Für Europa liegt darin eine enorme Chance: Als kontinentale Plattform für digitale und grüne Transformation kann es nicht nur mit den USA oder China mithalten – sondern eigene Modelle von Innovationsdynamik und unternehmerischer Verantwortung etablieren. Der nächste europäische Tech-Champion könnte längst gegründet sein – nun braucht er den Raum, um zu wachsen.

Quelle: NVIDIA

NVIDIA Nemotron 3: NVIDIA stellt mit Nemotron 3 eine neue Familie offener KI-Modelle in den Größen Nano, Super und Ultra vor, die speziell für agentische KI-Systeme optimiert sind. Eine hybride Mixture-of-Experts-Architektur ermöglicht deutlich höhere Effizienz, geringere Inferenzkosten und starke Genauigkeit bei Multi-Agenten-Workflows. Ergänzend veröffentlicht NVIDIA umfangreiche Trainingsdaten, Reinforcement-Learning-Tools und Open-Source-Bibliotheken, um transparente, spezialisierte und skalierbare KI-Agenten für Industrie und Forschung zu ermöglichen.

Google: Der Konzern arbeitet mit Unterstützung von Meta an „TorchTPU“, einer Initiative zur besseren PyTorch-Unterstützung für Googles KI-Chips. Ziel ist es, die Abhängigkeit von Nvidias CUDA-Ökosystem zu reduzieren und TPUs für externe Entwickler attraktiver zu machen. Durch höhere Kompatibilität sollen Wechselkosten sinken und Googles Cloud-Geschäft gestärkt werden. Die Zusammenarbeit mit Meta, dem wichtigsten PyTorch-Unterstützer, unterstreicht den strategischen Anspruch, Nvidias Softwarevorteil im KI-Markt gezielt anzugreifen.

FrontierScience: OpenAI stellt mit FrontierScience einen neuen Benchmark zur Bewertung von KI bei anspruchsvollen wissenschaftlichen Aufgaben in Physik, Chemie und Biologie vor. Der Benchmark kombiniert Olympiad-Fragen mit forschungsnahen Aufgaben, die von internationalen Experten entwickelt und geprüft wurden. Erste Ergebnisse zeigen deutliche Fortschritte bei strukturiertem wissenschaftlichem Denken, während offene Forschungsaufgaben weiterhin große Herausforderungen darstellen. FrontierScience soll Fortschritte messbar machen und die gezielte Weiterentwicklung KI-gestützter wissenschaftlicher Arbeit unterstützen.

Bloom: Mit Bloom wurde ein quelloffenes Werkzeug veröffentlicht, das automatisiert Verhaltensanalysen von KI-Modellen erstellt. Es generiert auf Basis einer Zielverhaltensbeschreibung zahlreiche Szenarien, um Häufigkeit und Ausprägung des Verhaltens messbar zu machen. Die Bewertungen korrelieren stark mit menschlichen Urteilen und erlauben differenzierte Vergleiche zwischen Modellen. Bloom ergänzt das bestehende Tool Petri und ermöglicht mit einer vierstufigen Pipeline skalierbare und reproduzierbare Verhaltensauswertungen – ein wichtiger Fortschritt für die Alignment-Forschung in komplexer werdenden KI-Systemen.

OpenAI: Entwickler können ab sofort Apps zur Veröffentlichung in ChatGPT einreichen. Die Apps erweitern Unterhaltungen um Aktionen und externen Kontext, etwa für Einkäufe, Präsentationen oder Recherchen. Dafür stellt OpenAI ein Apps SDK, Best Practices, Open-Source-Beispiele und eine UI-Bibliothek bereit. Genehmigte Apps erscheinen in einem neuen App-Verzeichnis direkt in ChatGPT und können kontextabhängig vorgeschlagen werden. Monetarisierung ist zunächst über externe Weiterleitungen möglich, weitere Modelle sollen folgen. Sicherheit, Transparenz und Datenschutz sind verpflichtende Voraussetzungen.

AI Agents: KI-Agenten verändern den SaaS-Markt, indem sie es Unternehmen ermöglichen, interne Software schneller, günstiger und exakt auf die eigenen Anforderungen zugeschnitten zu entwickeln. Besonders einfache SaaS-Lösungen wie Dashboards, Backoffice-Tools und CRUD-Anwendungen verlieren an Relevanz, da sie leicht durch agentengestützte Eigenentwicklungen ersetzt werden können. Dadurch geraten Kennzahlen wie Neukundengewinnung und Net Revenue Retention unter Druck. Robust bleiben Anbieter mit hohen SLAs, starken Netzwerkeffekten, regulatorischen Eintrittsbarrieren oder proprietären Daten. Der Build-vs-Buy-Entscheid verschiebt sich strukturell.

Inference Ökonomie: Der Autor analysiert die Ökonomie von KI-Inferenz und zeigt, dass sich der Markt dauerhaft in zwei attraktive Segmente aufteilt: reservierte Compute-Plattformen und Inference-APIs. Während reservierte GPUs Vorhersehbarkeit, Kontrolle und deterministische Leistung für wenige, große Kunden bieten, erzielen Inference-APIs ihren Vorteil durch Aggregation vieler Nutzer und hohe Auslastung. Entscheidend ist nicht maximale Performance, sondern Auslastung, da Performancevorteile schnell diffundieren. Langfristiger Wert entsteht dort, wo Nutzung effizient gebündelt wird.

KI-Blase: Massive Infrastruktur- und Chipdeals zeigen, wie stark sich Investitionen, Lieferverträge und Beteiligungen im KI-Ökosystem gegenseitig verstärken. OpenAI hat über verschiedene Vereinbarungen mit Nvidia, AMD, Broadcom, Microsoft, Oracle und anderen Infrastrukturzusagen von über einer Billion US-Dollar eingegangen, obwohl die aktuellen Umsätze deutlich darunter liegen. Die Finanzierung basiert teils auf zirkulären Strukturen aus Cloud-Credits, Abnahmeverpflichtungen und Beteiligungen. Dies wirft Fragen nach Nachhaltigkeit, Bewertung und systemischen Risiken im KI-Markt auf.

Scale AI: Das Unternehmen stellt mit „Rubrics as Rewards“ (RaR) einen neuen Ansatz für Reinforcement Learning vor, der strukturierte Bewertungsrubriken als Belohnungssignal nutzt. Damit wird RL über klar verifizierbare Aufgaben wie Mathematik hinaus auf komplexe Domänen wie Medizin und Wissenschaft ausgeweitet. Experimente zeigen deutliche Leistungsgewinne gegenüber Likert-basierten Bewertungen, bessere Generalisierung und stabilere Ausrichtung auch bei kleineren Bewertungsmodellen. RaR verbindet interpretierbare Kriterien mit skalierbarem Training und reduziert Abhängigkeiten von aufwendigem menschlichem Feedback.

Arbeitsmarkt: Trotz Sorgen vor massiven Jobverlusten entstehen durch KI neue Berufsbilder, die stark auf menschliche Fähigkeiten setzen. Gefragt sind Fachkräfte für Datenannotation auf Expertenniveau, Forward-Deployed Engineers zur Integration von KI in Organisationen, menschliche Operatoren für Ausnahmesituationen sowie Spezialisten für KI-Governance und Risikokontrolle. Coding verliert an Exklusivität, während Kommunikationsfähigkeit, Domänenwissen und Urteilsvermögen an Wert gewinnen. KI verändert den Arbeitsmarkt, ersetzt ihn aber nicht flächendeckend.

Video

Warum echte Denker selten sind

Impuls der Woche: The Highest Levels of Thinking

Inhalt: Dieses Video analysiert, warum der Großteil der Gesellschaft auf den niedrigsten Stufen des Denkens verharrt – beim bloßen Wiederholen von Meinungen und Fakten. Anhand von Blooms Taxonomie wird aufgezeigt, wie tiefes Denken systematisch unterdrückt wird – durch Biologie, Technologie und kulturelle Anreize und warum echte geistige Eigenständigkeit heute zur Ausnahme geworden ist.

Kontext: Der YouTube-Kanal „Aperture“ widmet sich den großen Fragen unserer Zeit - von Bewusstsein und Sinn bis hin zu technologischem Wandel und gesellschaftlicher Zukunft. Mit philosophischer Tiefe und psychologischem Feingefühl liefert er Perspektiven, die für strategisch denkende Entscheider Denkanstöße weit über den Tagesdiskurs hinaus bieten.

Ihre Meinung interessiert uns

Was bremst aus Ihrer Sicht derzeit strategische Automatisierungsentscheidungen am stärksten?

Ergebnisse der vorherigen Umfrage

Welche Art von KI-Unterstützung ist für Sie aktuell in Ihrem beruflichen Kontext am relevantesten?

🟨🟨🟨⬜️⬜️⬜️ Strategische Entscheidungsunterstützung 🧭

🟩🟩🟩🟩🟩🟩 Operative Effizienz & Automatisierung ⚙️

🟨🟨⬜️⬜️⬜️⬜️ Innovation & neue Geschäftsmodelle 🚀

🟨🟨⬜️⬜️⬜️⬜️ Orientierung & Einordnung auf Führungsebene 🏛️

Deep-Tech

Ignite Next treibt Europas Deep-Tech Scaleups in die industrielle Realität

Quelle: Ignite Next

Was ist das Problem? Europas Deep-Tech-Startups brillieren in Forschung, kommen aber häufig nicht über die frühe Finanzierungs- und Validierungsphase hinaus. Die Lücke zwischen wissenschaftlicher Exzellenz und industrieller Skalierung bremst marktreife Technologien und verschwendet Potenzial.

Wie wird es gelöst? Mit Ignite Next entsteht ein neues, nicht-dilutives Scale-up-Programm, das gezielt den Übergang von Pre-Seed zu Series B unterstützt. Gründern wird neben Kapital direkter Zugang zu Industrieexpertise, kommerzieller Validierung und strategischen Partnernetzwerken geboten.

Warum das wichtig ist: Europa steht im globalen Technologie-Wettbewerb unter Druck, insbesondere in Bereichen wie Halbleitern, Photonik, Robotik oder Quantentechnologien. Ein strukturierter, industriegetriebener Pfad zur Kommerzialisierung kann Blockaden im Innovationsökosystem auflösen und die Region als ernstzunehmenden Standort für tiefgründige Technologieentwicklung positionieren.

Handlungsempfehlung: Entscheider in Unternehmen und Forschungseinrichtungen sollten Deep-Tech-Teams aktiv auf Programme wie Ignite Next ausrichten, um Industrienähe früh im Lebenszyklus zu verankern. Kooperationen sollten standardisiert werden, damit startup-seitige Innovationen schneller in Wertschöpfung münden.

Ansprechpartner: Ignite Next

Impact: Steigerung der Erfolgsraten von Deep-Tech-Scaleups bis 2028

Relevant für:

Geschäftsführung & Strategie: ●●●

Innovations- & Technologieabteilungen: ●●●

Venture Capital & Corporate Finance): ●●○

Forschung & Entwicklung: ●●●

Regulierung & Rahmenbedingungen: ●●○

Produktion & Supply Chain: ●●○

Automation

Warum du mit Workflows statt mit KI-Agenten starten solltest

Problemstellung: Viele Einsteiger im Bereich KI-Automatisierung begehen denselben Fehler: Sie wollen sofort komplexe KI-Agenten bauen, weil diese besonders „smart“ oder spannend wirken. Doch dieser Ansatz führt oft zu Frustration. Denn ohne ein solides Verständnis für grundlegende Automatisierung und Datenflüsse fehlen die Grundlagen, um stabile Systeme zu entwickeln. Die Folge sind fehleranfällige, unverständliche oder schlicht ineffiziente Automationen, die wenig echten Nutzen bringen.

Lösung: Der effektivere Weg führt über eine klare Automatisierungsstrategie in drei Stufen: Zuerst sollten regelbasierte Workflows aufgebaut werden – sie sind stabil, vorhersehbar und liefern schnellen ROI. Danach können KI-Elemente punktuell eingebaut werden, z. B. um Texte zu personalisieren oder Prioritäten automatisch zu vergeben. Erst auf dieser Basis lohnt sich der Aufbau komplexer KI-Agenten, die Entscheidungen treffen, Tools nutzen und sich kontextabhängig verhalten.

Anwendungsbeispiele: Klassische Workflows wie die automatisierte Bearbeitung von E-Mails oder das Übertragen von Formulardaten in ein CRM-System bieten bereits massive Effizienzgewinne – ganz ohne KI. Sobald die Abläufe verstanden sind, können gezielte LLM-Elemente hinzugefügt werden, etwa zur Texterstellung, Klassifikation oder Zusammenfassung. Erst später werden KI-Agenten sinnvoll, die mit Memory arbeiten, auf verschiedene Systeme zugreifen und eigenständig Entscheidungen treffen. Auch hier bleibt ein sauber geplanter Ablauf entscheidend – am besten mit Stift und Papier, bevor überhaupt ein Tool geöffnet wird.

Erklärungsansatz: Gute Automatisierung basiert nicht auf „magischer KI“, sondern auf klaren, nachvollziehbaren Prozessen. Wer JSON, APIs, HTTP-Requests und Fehlerbehandlung versteht, kann stabile und skalierbare Systeme bauen. KI-Modelle wie GPT werden durch gutes Kontext-Engineering erst nützlich – sie brauchen klare Anweisungen, relevante Informationen und eine definierte Aufgabe. Erfolgreiche Automatisierer denken wie Prozessingenieure: Sie analysieren, dokumentieren, testen und optimieren. So entstehen Lösungen, die nicht nur funktionieren, sondern echten geschäftlichen Mehrwert bringen.

Fazit: Wer heute mit Automatisierung beginnt, sollte sich zunächst auf klassische Workflows konzentrieren. Sie bilden das Fundament für alles Weitere – inklusive KI-Agenten. Erst wenn die Grundlagen sitzen, lohnt sich der nächste Schritt. So entsteht nachhaltige Automatisierung mit echtem ROI – skalierbar, wartbar und verständlich.

Grocking

Wie KI wirklich funktioniert und warum sie so erstaunlich ist

Kaum jemand versteht moderne KI vollständig – doch ein verblüffendes Experiment von OpenAI bringt uns der Antwort ein Stück näher. In einem unscheinbaren Versuch zur modularen Addition machte ein Team von Forschern eine zufällige Entdeckung, die tief in das Innenleben neuronaler Netze blicken lässt. Was zunächst wie banales Auswendiglernen aussah, verwandelte sich nach tausenden Trainingsschritten in echtes Verständnis – ein Phänomen, das sie „Grocking“ tauften.

Anhand eines simplen Rechenproblems zeigt das Video, wie ein Transformer-Modell nach und nach Strukturen wie Sinus- und Kosinuswellen erkennt und schließlich mithilfe trigonometrischer Identitäten lernt, Zahlen korrekt zu addieren – und das, obwohl es nur mit Symbolen arbeitet, nicht mit Zahlen. Die dabei entstehenden Aktivierungsmuster erinnern an analoge Uhren, deren kreisförmige Bewegung modularer Arithmetik entspricht.

Besonders faszinierend: Erst tief in der Analyse wird deutlich, wie das Modell auf elegante Weise lernt, diese Muster zu verknüpfen – nicht durch Programmierung, sondern durch pures Training. Diese Einblicke ermöglichen es Forschern, neue Metriken wie den „Excluded Loss“ zu entwickeln, die zeigen, wie ein Modell langsam vom Merken zum Verstehen übergeht.

Dieses Video bietet einen selten klaren Blick in eine Welt voller Black Boxes – und erzählt zugleich eine Geschichte von wissenschaftlichem Zufall, Neugier und echter Erkenntnis. Wer verstehen will, was wirklich in großen KI-Modellen vorgeht, sollte sich dieses Beispiel nicht entgehen lassen.

Werben im KI-Briefing

Möchten Sie Ihr Produkt, Ihre Marke oder Dienstleistung gezielt vor führenden deutschsprachigen Entscheidungsträgern platzieren?

Das KI-Briefing erreicht eine exklusive Leserschaft aus Wirtschaft, Politik und Zivilgesellschaft – von C-Level-Führungskräften über politische Akteure bis hin zu Vordenkern und Experten. Kontaktieren Sie uns, um maßgeschneiderte Kooperationsmöglichkeiten zu besprechen.

Und nächste Woche…

... werfen wir einen Blick auf das Konzept des Strategic Twin für Europa – ein digitaler Zwilling, der hilft, komplexe Systeme besser zu verstehen, Zukunftsszenarien zu entwerfen und Transformation strategisch zu begleiten. Ob für Wirtschaft, Verwaltung oder Forschung: Szenarien als Code ermöglichen neue Formen der Planung, Kollaboration und Entscheidungsfindung auf Basis von Simulation, Daten und gemeinsamen Zielbildern.

Wir freuen uns, dass Sie das KI-Briefing regelmäßig lesen. Falls Sie Vorschläge haben, wie wir es noch wertvoller für Sie machen können, spezifische Themenwünsche haben, zögern Sie nicht, auf diese E-Mail zu antworten. Bis zum nächsten mal mit vielen neuen spannenden Insights.