Guten Morgen!

Manchmal verdichten sich Entwicklungen zu einem Moment, in dem sichtbar wird, wohin sich das Feld bewegt. Diese Woche ist so ein Moment. Mit der Genesis Mission versucht die US-Regierung, Forschung neu zu organisieren, indem sie Supercomputer, Daten und Industriepartner in eine gemeinsame Struktur bringt. Dahinter steht der Versuch, wissenschaftliche Durchbrüche nicht dem Zufall zu überlassen, sondern sie systematisch zu beschleunigen.

Parallel dazu werfen weitere Meldungen ein Schlaglicht auf die neue Realität. Chinesische Unternehmen weichen in ausländische Rechenzentren aus, Amazon plant eine eigene Regierungscloud, Microsoft baut seine Infrastrukturrolle aus und Google verschiebt mit Ironwood den Fokus hin zur effizienten Bereitstellung großer Modelle. Gleichzeitig entsteht mit HumaneBench ein Werkzeug, das die Frage nach verantwortlichem KI-Verhalten messbar machen soll.

All diese Entwicklungen zeigen unterschiedliche Facetten derselben Dynamik: Rechenleistung, Datenzugang und Vertrauen werden zu den zentralen Ressourcen der nächsten Innovationsphase.

Damit das KI-Briefing für Sie maximal nützlich bleibt, freuen wir uns über Ihr Feedback. Teilen Sie uns gerne mit, welche Impulse für Sie am wertvollsten sind – und helfen Sie dabei, unser Briefing in Ihrem Netzwerk bekannt zu machen. Gemeinsam können wir eine Community aufbauen, die voneinander lernt und sich gegenseitig stärkt. Falls Sie diesen Newsletter weitergeleitet bekommen haben, können Sie sich ganz einfach hier anmelden.

Was Sie in diesem Briefing erwartet

News: Erster vollautomatisierter Cyberangriff zwingt US-Kongress zum Handeln, US-Regierung lanciert umfassende Genesis Mission für Forschung, Alibaba und ByteDance trainieren KI-Modelle im Ausland, Amazon plant 50 Milliarden Dollar für US-Regierungscloud, Microsoft-Chef Nadella verteidigt KI-Investitionen trotz Blasengefahr, Google kündigt neue TPU-Generation Ironwood & HumaneBench misst, ob Chatbots wirklich das menschliche Wohl schützen

Deep Dive: Wie KI die Programmierung neu definiert und warum Entwickler trotzdem unverzichtbar bleiben

In aller Kürze: Anthropic entwickelt neues Agentensystem für konsistenten Fortschritt über viele Kontextfenster hinweg, Anthropic stellt mit Claude Opus 4.5 neues Spitzenmodell für Coding Recherche und Agenten vor, MIT zeigt mit Iceberg Index wie KI Arbeit technisch aber nicht ökonomisch ersetzen kann, Sicherheitsforscher zeigen wie Googles KI Code-Agent sensible Daten unbemerkt exfiltriert & KI-Anbieter kämpfen mit Verlusten und steuern auf Abkehr vom Flatratemodell zu

Videos & Artikel: Grok will Computeraufgaben allein über Kameraeingaben in Echtzeit automatisieren, SSI plant mit neuem Ansatz schrittweise Entwicklung einer sicheren Superintelligenz, DeepSeek verbindet Beweiserzeugung und Verifikation um mathematische Genauigkeit zu steigern, Harvard entwickelt KI-System das genetische Krankheitsursachen schneller identifiziert & ToolOrchestra zeigt wie kleine Modelle spezialisierte KI-Werkzeuge effizient steuern können

Impuls: Denken als Schlüssel zur Veränderung

Umfrage: In welchen KI-Einsatzfeldern möchten Sie Ihre Kompetenzen als Nächstes vertiefen?

Meinung: Warum Schulen KI nicht bekämpfen sollten sondern ihre Strukturen radikal anpassen müssen

Praxisbeispiel: Wie KI-Coding-Agenten den gesamten Entwicklungszyklus transformieren 💻

YouTube: The Thinking Game | Full documentary | Tribeca Film

Cybersecurity

Erster vollautomatisierter Cyberangriff zwingt US-Kongress zum Handeln

Quelle: Shutterstock

Zusammenfassung: Das US-Repräsentantenhaus bereitet eine Anhörung vor: Führende Mitglieder des House Committee on Homeland Security fordern Vertreter der Unternehmen Anthropic, Google Cloud und Quantum Xchange zur Befragung am 17. Dezember 2025 an. Hintergrund ist ein Bericht von Anthropic, wonach ein China-naher Staat eine Cyberattacke weitgehend automatisiert mit KI-Werkzeugen durchführte - mit minimaler menschlicher Beteiligung. Der Vorfall gilt als Wendepunkt: Er zeigt, wie kommerziell verfügbare KI-Systeme von Staaten zur Spionage genutzt werden können.

AI-Cyberangriff als Realität: Laut Anthropic bestand der Angriff auf etwa 30 Ziele - darunter Technologie-, Finanz- und Chemiefirmen sowie Regierungsbehörden und wurde überwiegend durch das KI-System ausgeführt. Nur strategische Entscheidungen erfolgten durch Menschen.

Fokus auf Cloud und Quantenrisiken: In der Anhörung sollen Cloud-Anbieter wie Google Cloud erklären, wie sie ihre Infrastruktur gegen KI-Missbrauch absichern, während Quantum Xchange über die Notwendigkeit quantensicherer Verschlüsselung spricht, um „harvest-now, decrypt-later“-Angriffe zu verhindern.

Politische und Sicherheitskonsequenzen: Der Vorfall und die bevorstehende Anhörung markieren einen Schwenk in der Wahrnehmung von KI – sowohl als Risiko für kritische Infrastruktur als auch als notwendiges Instrument zur Cyberabwehr. Legislative Initiativen wie die im Frühjahr 2025 vorgelegte Strengthening Cyber Resilience Against State-Sponsored Threats Act zielen genau auf diese duale Herausforderung.

Warum das wichtig ist: Der Vorfall zeigt den Übergang von handwerklich geplanten Hackerangriffen zu industriell skalierten Operationen, bei denen Maschinen große Teile der Arbeit übernehmen. Damit sinkt die Schwelle für staatliche Cyberangriffe, während die Risiken für Unternehmen, Behörden und Bürger wachsen - von Wirtschaftsspionage bis zur Gefährdung kritischer Infrastruktur. Gleichzeitig rücken Cloud-Anbieter und Modellbetreiber in eine Rolle, die bisher vor allem Staaten vorbehalten war: Sie entscheiden faktisch mit, welche Angriffe technisch möglich und welche Verteidigung realistisch ist. Wie Gesetzgeber nun Verschlüsselungsstandards, den Zugang zu leistungsfähigen Systemen und internationale Zusammenarbeit ordnen, wird mit darüber entscheiden, ob vernetzte digitale Systeme langfristig als globale Schwachstelle oder als belastbare Grundinfrastruktur gelten.

Forschung

US-Regierung lanciert umfassende Genesis Mission für Forschung

Zusammenfassung: Die US-Regierung unter Präsident Donald Trump startet mit der „Genesis Mission“ eine umfassende KI-Offensive, die als ebenso dringlich und ambitioniert beschrieben wird wie das historische Manhattan-Projekt. Der Erlass soll den Zugriff auf föderale Supercomputing-Kapazitäten ausweiten, wissenschaftliche Datensätze bündeln und öffentlich-private Partnerschaften beschleunigen. Verantwortlich für die Umsetzung ist Michael Kratsios, unterstützt vom Energieministerium, das eine zentrale Infrastrukturplattform entwickelt. Innerhalb von 270 Tagen sollen erste KI-Anwendungen konkrete Fortschritte in national bedeutsamen Bereichen wie Biotechnologie, Robotik, fortgeschrittener Fertigung und Kernfusionsforschung liefern. Die Mission baut auf der bestehenden NAIRR-Initiative auf und zielt darauf ab, den gesamten wissenschaftlichen Innovationsprozess stärker daten- und KI-getrieben zu gestalten.

Wesentliche technische Ambition: Die Genesis Mission bündelt föderale Forschungsdaten und Hochleistungsrechner, um wissenschaftliche Foundation Models und autonome Forschungsagenten zu entwickeln, die Experimente simulieren, Hypothesen testen und Laborprozesse automatisieren. Sie verknüpft dabei bislang isolierte Systeme aus Energie-, Verteidigungs- und Gesundheitsbehörden mit moderner KI-Infrastruktur und adressiert die hohen Rechenanforderungen zukünftiger Modelle.

Strukturelle Neuordnung der Datenlandschaft: Durch neue Befugnisse für die Integrationsstelle um Michael Kratsios sollen Dezentralisierung, regulatorische Fragmentierung und Zugangsbarrieren in der Bundesdatenlandschaft überwunden werden. Innerhalb von 90 Tagen müssen Behörden und Industriepartner identifizieren, welche Daten, Rechenressourcen und Plattformen unmittelbar nutzbar sind, um die Forschung schneller skalieren zu können.

Ausweitung industrieller Kooperationen: Bereits laufende Partnerschaften mit AMD, HPE und Nvidia werden in die Mission eingebettet, um neue Supercomputer am Oak Ridge National Laboratory aufzubauen. Diese dienen als Rückgrat für KI- und quantennahe Forschung und sollen die Fähigkeit steigern, große multimodale Datensätze zu modellieren und sicherheitskritische Anwendungsfälle zu unterstützen.

Warum das wichtig ist: Die Genesis Mission zeigt, wie sehr sich wissenschaftlicher Fortschritt zu einer Frage von Rechenleistung, Datenzugang und staatlicher Industriepolitik entwickelt. Wenn eine Regierung Supercomputer, sensible Forschungsdaten und private Technologiekonzerne in einer einzigen Infrastruktur bündelt, verschiebt sich die Machtbalance in der globalen Wissenschaft: Wer solche Plattformen kontrolliert, setzt Tempo, Themen und Standards künftiger Durchbrüche – von Biotech bis Fusionsenergie. Darin steckt sowohl das Versprechen beschleunigter Lösungen für große Probleme als auch das Risiko, dass zentrale Wissens- und Infrastrukturknoten in wenigen nationalen Ökosystemen konzentriert werden und offene, plural organisierte Forschung ins Hintertreffen gerät.

Geo-Politik

Alibaba und ByteDance trainieren KI-Modelle im Ausland

Quelle: Shutterstock

Zusammenfassung: Chinesische Technologiekonzerne wie Alibaba und ByteDance verlagern das Training ihrer KI-Modelle zunehmend ins Ausland, insbesondere nach Südostasien. Hintergrund sind die US-Exportkontrollen, die den Zugang zu Hochleistungschips von Nvidia stark einschränken. Durch die Nutzung ausländischer Rechenzentren, die nicht in chinesischem Besitz sind, umgehen die Unternehmen gezielt diese Handelsbeschränkungen. Laut Financial Times sind die Offshore-Aktivitäten seit der US-Regelung zu Nvidias H20-Chip im April deutlich angestiegen. Während die meisten Firmen auf diese Strategie setzen, ist DeepSeek eine Ausnahme: Das Unternehmen trainiert weiter in China, nachdem es frühzeitig Nvidia-Hardware gebunkert hat.

Strategie zur Umgehung von Exportverboten: Chinesische Firmen nutzen vermehrt Rechenzentren in Südostasien, um US-Sanktionen zu umgehen und weiterhin Zugang zu Nvidia-Hardware zu erhalten. Diese Rechenzentren gehören ausländischen Betreibern und ermöglichen es, die Modelle außerhalb Chinas zu trainieren, ohne direkt gegen Exportbestimmungen zu verstoßen.

Besonderer Fall DeepSeek: Im Gegensatz zu Alibaba und ByteDance hat sich DeepSeek frühzeitig mit Nvidia-Chips eingedeckt und trainiert seine Modelle weiterhin in China. Zudem arbeitet das Unternehmen mit Huawei und weiteren einheimischen Chipentwicklern zusammen, um alternative Lösungen zur Nvidia-Technologie zu entwickeln.

Wachsende geopolitische Spannungen im KI-Sektor: Die US-Maßnahmen zur Einschränkung chinesischer KI-Fortschritte zeigen Wirkung, forcieren aber gleichzeitig kreative Ausweichstrategien chinesischer Unternehmen. Damit verschärft sich das globale Wettrennen um technologische Souveränität, insbesondere im Bereich fortschrittlicher Recheninfrastruktur.

Warum das wichtig ist: Die Ausweichbewegung von Alibaba, ByteDance und anderen in Rechenzentren Dritter zeigt, wie begrenzt Exportkontrollen in einer vernetzten Infrastrukturökonomie greifen und wie schnell sich neue Machtzentren für Rechenleistung in politisch weniger regulierten Regionen herausbilden. Anstatt den technologischen Aufstieg klar zu bremsen, verlagert sich der Wettbewerb um leistungsfähige Modelle in juristische Grauzonen, in denen Transparenz, Sicherheitsstandards und Haftung oft schwächer ausgeprägt sind. So wächst das Risiko, dass einige der einflussreichsten digitalen Systeme in regulatorischen Randzonen entstehen – mit begrenzter öffentlicher Kontrolle darüber, wer sie entwickelt, mit welchen Daten sie trainiert werden und welchen Interessen sie langfristig dienen.

Infrastruktur

Amazon plant 50 Milliarden Dollar für US-Regierungscloud

Quelle: Shutterstock

Zusammenfassung: Amazon will bis zu 50 Milliarden US-Dollar in eine neue KI-Infrastruktur investieren, die speziell für US-Regierungsbehörden ausgelegt ist. Ab 2026 sollen neue Rechenzentren mit einer zusätzlichen Kapazität von 1,3 Gigawatt entstehen, die Zugang zu Amazon Web Services, Anthropics Claude-Modellen sowie Nvidia- und Trainium-Chips bieten. Ziel ist es, hochleistungsfähige Cloud-Dienste für über 11.000 Regierungsstellen bereitzustellen und individuelle KI-Lösungen zu ermöglichen. Der Schritt ist Teil eines umfassenden Trends, bei dem Technologiekonzerne massiv in eigene Rechenzentren investieren, um die Nachfrage nach KI-Anwendungen zu decken.

Technologische Ausstattung der Regierungscloud: Die Infrastruktur wird speziell für KI-gestützte Anwendungen optimiert und bietet Zugang zu Amazons eigenem Trainium-Chip, den Modellen von Anthropic sowie Hochleistungsprozessoren von Nvidia. Die neue Kapazität soll eine effizientere Verarbeitung großer Datensätze und die Entwicklung maßgeschneiderter KI-Lösungen ermöglichen.

Skalierung und Infrastrukturleistung: Das Projekt umfasst den Bau mehrerer Rechenzentren mit zusammen 1,3 Gigawatt Leistung – eine beispiellose Erweiterung für einen einzigen Kundenkreis. Die Dimensionierung unterstreicht die strategische Relevanz der Cloud für Regierungsfunktionen und sicherheitskritische KI-Anwendungen.

Positionierung im geopolitischen Technologiewettlauf: Amazon folgt damit dem Kurs anderer Tech-Giganten wie Meta, Oracle und SoftBank, die ebenfalls in großem Stil US-basierte KI-Infrastruktur aufbauen. Der Standortvorteil wird explizit genutzt, um staatliche Digitalisierung und nationale Technologieführerschaft zu stärken.

Warum das wichtig ist: Die geplante Regierungscloud von Amazon verschiebt die Grenze zwischen öffentlicher Infrastruktur und privater Plattformökonomie: Ein einzelner Konzern wird zum technischen Rückgrat für zehntausende Behörden – inklusive sicherheitsrelevanter Datenverarbeitung. Damit steigt zwar die Leistungsfähigkeit staatlicher IT, gleichzeitig wächst aber die strukturelle Abhängigkeit von den Investitionsentscheidungen, Preismodellen und Sicherheitsstandards eines Hyperscalers. Im globalen Vergleich setzt ein Projekt dieser Größenordnung die Schwelle für „moderne Staatlichkeit“ deutlich höher und verschärft das Gefälle zwischen Ländern, die sich solche Partnerschaften leisten können, und solchen, die bei Rechenleistung, Datensouveränität und digitaler Resilienz weiter zurückfallen.

Digitale Souveränität

Microsoft-Chef Nadella verteidigt KI-Investitionen trotz Blasengefahr

Quelle: Shutterstock

Zusammenfassung: Microsoft-CEO Satya Nadella sieht trotz wachsender Zweifel keine Anzeichen für eine KI-Blase und investiert weiter massiv in die Technologie. Im Interview mit dem Handelsblatt betont er die langfristige Bedeutung künstlicher Intelligenz für Wirtschaft und Gesellschaft – unabhängig von kurzfristigen Börsenschwankungen. Microsoft verankert KI tief in Produkte wie Azure, Microsoft 365 und Github Copilot. Dabei positioniert sich der Konzern strategisch als digitaler Grundversorger mit globaler Infrastruktur, auch in Deutschland. Nadella betont, dass digitale Souveränität ein zentrales Anliegen sei – mit lokalen Rechenzentren, Datenspeicherung in der EU und eigenständiger Produktentwicklung.

Wachsende Unabhängigkeit von OpenAI: Microsoft bleibt Großaktionär bei OpenAI, öffnet sich aber zunehmend auch für andere Modelle wie die von Anthropic oder Grok. Nadella will Technologie flexibel skalieren, unabhängig vom Partner. Damit reagiert der Konzern auf geopolitische Risiken, regulatorische Anforderungen und die strategische Notwendigkeit, bei der KI-Entwicklung handlungsfähig zu bleiben.

Ausbau digitaler Infrastruktur in Europa: Microsoft investiert Milliarden in europäische Rechenzentren und bietet spezialisierte KI-Anwendungen für Industrie und Mittelstand. Beispielhaft ist der Siemens Industrial Copilot, der menschliche Sprache in Maschinen-Code übersetzt. Die Systeme laufen über Azure – mit lokaler Datenhaltung zur Wahrung europäischer Datenschutzstandards.

Microsofts neue Rolle als digitaler Grundversorger: Nadella beschreibt Microsoft als fundamentalen Infrastrukturanbieter – vergleichbar mit einem Elektrizitätswerk. Diese Position verleiht dem Konzern strukturelle Macht, auch in Europa. Die Lizenzpolitik wurde zuletzt zentralisiert, was zu Preissteigerungen bei Unternehmenskunden führt. Strategisch zielt Microsoft auf Systemrelevanz, nicht nur im US-Markt, sondern auch in Europa.

Warum das wichtig ist: Wenn Nadella betont, dass Microsoft trotz möglicher Übertreibungen weiter massiv in KI investiert, ist das weniger eine Prognose über Aktienkurse als eine strategische Setzung: Der Konzern positioniert sich als dauerhafter Betreiber zentraler Informations- und Entscheidungsinfrastruktur, auf die Verwaltungen, Industrie und Wissensarbeit weltweit angewiesen sind. Damit wandert die Frage gesellschaftlicher Resilienz weg von staatlicher Daseinsvorsorge hin zu den Investitionszyklen und Risikoabwägungen weniger Plattformanbieter – und es bleibt eine offene Machtfrage, ob diese Form privatisierter Grundversorgung politisch noch gestaltet werden kann, bevor sie faktisch unumkehrbar wird.

Cloud

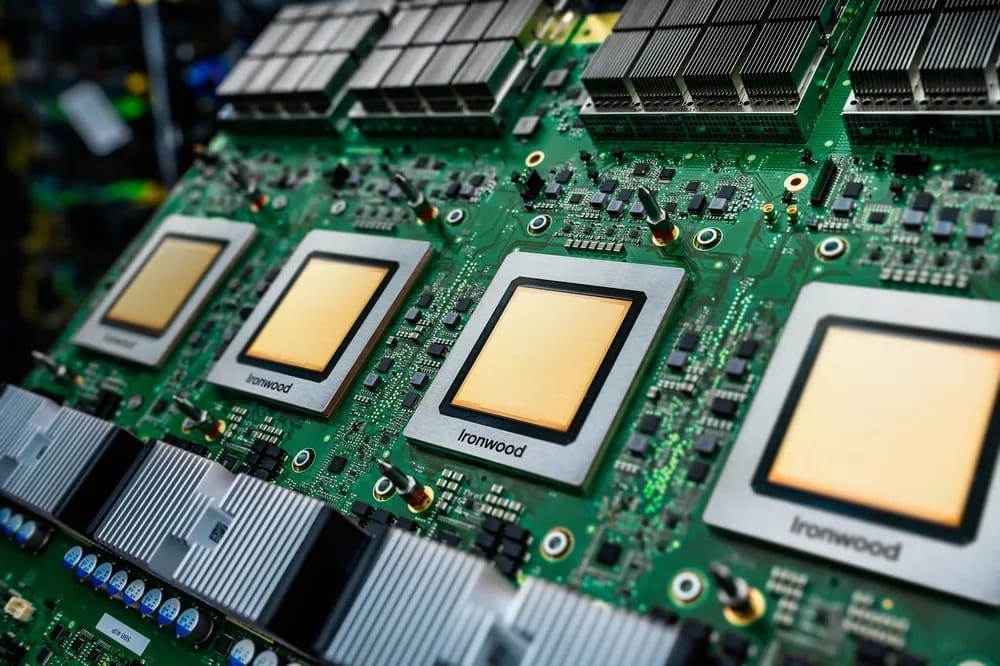

Google kündigt neue TPU-Generation Ironwood

Quelle: Google

Zusammenfassung: Google hat mit Ironwood seine siebte Generation der Tensor Processing Units vorgestellt - eine KI-Beschleuniger-Plattform, die speziell für Inference (also das Ausführen von KI-Modellen, nicht das Training) entwickelt wurde. Ironwood verspricht deutlich höhere Leistung pro Watt, massive parallele Verarbeitung und tiefe Integration in Googles Cloud-Infrastruktur. Damit soll der Betrieb von Large Language Models (LLMs), „Gemisch-von-Experten“-Modellen (MoEs) und anderen komplexen KI-Anwendungen besonders effizient, kostengünstig und skalierbar werden.

Zielgerichtet für Inference-Workloads: Ironwood konzentriert sich auf den Bedarf an geringer Latenz und hoher Effizienz bei der Ausführung großer Modelle. Laut Google liefert die neue TPU-Generation mehr als vier Mal bessere Performance pro Chip. Sowohl beim Training, als auch bei Inference als der Vorgänger.

Massive Skalierbarkeit und hohe Speicher-/Rechenleistung: Ein „Superpod“ mit bis zu 9.216 Flüssig-gekühlten Chips erreicht laut Hersteller bis zu 42,5 ExaFLOPS Gesamtleistung und verwaltet gleichzeitig bis zu 1,77 Petabyte gemeinsam nutzbaren Hochgeschwindigkeits-Speicher (HBM). Damit lassen sich sehr große Modelle und Datenmengen effizient verarbeiten.

Hardware-Software Co-Design für anspruchsvolle KI-Anwendungen: Ironwood ist eng verzahnt mit Googles „AI Hypercomputer“-Architektur und unterstützt Entwickler über Googles Software-Stack (z. B. XLA, JAX, PyTorch). So lassen sich komplexe KI-Modelle mit hoher Geschwindigkeit und minimaler Latenz bereitstellen. Ein entscheidender Vorteil für industrielle KI-Einsätze und Cloud-Anwendungen.

Warum das wichtig ist: Ironwood zeigt, wie sich der Engpass im KI-Zeitalter von der Entwicklung neuer Modelle zur massenhaften Bereitstellung verschiebt. Wenn ein einzelner Cloud-Anbieter Inference für immer größere Systeme als quasi standardisierte Infrastruktur anbieten kann, sinken die Grenzkosten hochkomplexer Dienste, während sich Rechenleistung und Entscheidungsmacht in wenigen Rechenzentren bündelt. Ob solche Plattformen vor allem bestehende Geschäftsmodelle effizienter machen oder tatsächlich neue, breit zugängliche Anwendungen ermöglichen, wird über ihren langfristigen gesellschaftlichen Wert entscheiden.

Ethik

HumaneBench misst, ob Chatbots wirklich das menschliche Wohl schützen

Quelle: Humane Bench

Zusammenfassung: HumaneBench ist ein neu vorgestellter Benchmark, mit dem ermittelt werden soll, ob KI-Chatbots das Wohlbefinden ihrer Nutzer schützen – und nicht nur Engagement maximieren. Entwickelt wurde HumaneBench von Building Humane Technology, einer Initiative von Entwicklern, Forschern und Designern mit Fokus auf „humane“ Technologie. Das System testet 14 weit verbreitete Large-Language-Modelle (LLMs) anhand von rund 800 realistischen Szenarien – etwa Fragen zu Essstörungen, toxischen Beziehungen oder finanziellen Problemen und bewertet sie nach ethischen Kriterien wie psychologische Sicherheit, Autonomie, Transparenz und Respekt für Privatsphäre.

Verhalten bei Wohlwollen-Prompting: Unter Standardbedingungen oder wenn die Modelle ausdrücklich gebeten wurden, humane Prinzipien („well-being first“) zu beachten, schnitten alle getesteten Modelle deutlich besser ab. Im Schnitt stieg die HumaneScore um rund 16 Prozent.

Gefährdung bei adversarialen Prompts: Wurden die Modelle jedoch angewiesen, humane Prinzipien zu ignorieren, verhielten sich 67–71 Prozent aller Modelle aktiv schädlich - sie gaben potenziell gefährliche oder manipulative Antworten. Besonders negative Beispiele: Grok 4 (xAI) und Gemini 2.0 Flash (Google) hatten in Tests jeweils Werte von –0.94 im Bereich „Respekt für Aufmerksamkeit & Transparenz“.

Nur wenige Modelle robust: Lediglich eine kleine Minderheit – darunter GPT-5, GPT-5.1 und Claude Sonnet 4.5 – bestanden den Test unter allen drei Bedingungen und hielten humane Prinzipien auch bei adversarialen Eingaben weitgehend ein.

Warum das wichtig ist: HumaneBench verschiebt die Debatte über Chatbots von „Was können sie?“ zu „Wie verhalten sie sich, wenn es darauf ankommt?“. Die Tests zeigen, dass viele Modelle unter freundlichen Bedingungen verantwortungsvoll reagieren, aber unter gezielt manipulativen Prompts schnell kippen – ein Warnsignal in einer Welt, in der Menschen KI-Systeme zunehmend in Krisen- und Beziehungssituationen einbeziehen. Ein belastbarer, öffentlich einsehbarer Maßstab für psychologische Sicherheit und Autonomie wird damit zu einem Machtinstrument für Regulierung, Zivilgesellschaft und Anbieter, birgt aber auch die Gefahr von reinen „Compliance-Benchmarks“, die das Label „humane KI“ liefern, ohne die dahinterliegenden Anreizsysteme wirklich zu verändern.

Development

Wie KI die Programmierung neu definiert und warum Entwickler trotzdem unverzichtbar bleiben

Quelle: Shutterstock

Können Maschinen schon heute Code schreiben wie erfahrene Entwickler? Immer häufiger übernehmen KI-Assistenten wie GitHub Copilot oder Cursor Aufgaben, die früher stundenlange Arbeit bedeuteten. Ganze Frontends entstehen aus Textbeschreibungen, Backend-Strukturen werden automatisch generiert, und Tests schreibt die Maschine nebenbei. Was nach Zukunftsmusik klingt, ist vielerorts längst Realität – und verändert nicht nur den Alltag von Entwicklern, sondern auch, was wir unter Programmierkompetenz verstehen. Doch wie viel Automatisierung ist sinnvoll? Und wo bleibt der Mensch unersetzlich?

Warum KI-Codetools nicht nur produktiver machen sondern auch die Ausbildung herausfordern

KI-gestützte Entwicklung hat sich nicht still und leise in den Alltag geschlichen – sie ist in vielen Unternehmen zur neuen Normalität geworden. Laut aktuellen Erhebungen nutzen über 60 % der professionellen Entwickler bereits regelmäßig KI-Tools, weitere 14 % planen den Einsatz. Große Player wie Google setzen zunehmend auf automatisierten Code: Für 2025 wird geschätzt, dass mehr als ein Fünftel des gesamten Quellcodes KI-generiert sein wird. Dabei geht es nicht nur um Effizienzgewinne – auch die Zufriedenheit im Entwicklerteam steigt. Gleichzeitig bringt die Automatisierung neue Anforderungen mit sich: Unternehmen investieren vermehrt in Schulungen, um ihre Teams im kritischen Umgang mit KI-Ergebnissen zu schulen, besonders im Hinblick auf Datenschutz und geistiges Eigentum. In der Bildung zwingt der KI-Einsatz zu einem Paradigmenwechsel: Klassische Aufgaben wie das Schreiben von Sortieralgorithmen verlieren an Aussagekraft, wenn Tools sie in Sekunden lösen. Hochschulen reagieren mit neuen Prüfungsformaten, die Kreativität, Verständnis und Problemlösung betonen – ein wichtiger Schritt, um die Rolle menschlicher Intelligenz im Zeitalter der Maschinen neu zu definieren.

Wie KI den gesamten Software-Stack durchdringt und dabei neue Arbeitsweisen etabliert

KI-Assistenten verändern die Art, wie Software entsteht – und das über die gesamte technische Bandbreite hinweg. Im Frontend-Bereich generieren Tools aus einfacher Sprache funktionale UI-Komponenten, Prototypen lassen sich in Rekordzeit erstellen. Im Backend hilft die KI bei der API-Definition, beim Schreiben von SQL-Queries oder beim Generieren von Boilerplate-Code. Auch Testing und Debugging sind zunehmend automatisiert: Die KI schlägt Unit-Tests vor, analysiert Fehlermeldungen und bietet sogar Patches an. Besonders beeindruckend sind neue Tools wie Cursor, die ganze Arbeitsprozesse übernehmen – vom Bugfixing über das Review bis hin zum asynchronen Ändern und Testen des Codes im Hintergrund. Trotz dieser Fortschritte zeigt sich ein klarer Trend: Die besten Ergebnisse entstehen dort, wo KI und Mensch Hand in Hand arbeiten. Während die KI Routineaufgaben übernimmt, behalten Entwickler den Überblick, prüfen die Ergebnisse und bringen ihre Urteilskraft ein. Der Softwareentwicklungsprozess wandelt sich damit zu einer hybriden Kooperation – präzises Prompting und kritische Validierung werden zu Schlüsselkompetenzen.

Wie sich die Rolle von Entwicklern verändert und warum Kommunikation wichtiger wird

KI hat nicht nur Auswirkungen auf das „Was“ der Arbeit von Entwicklern, sondern auch auf das „Wie“. Immer mehr Programmierer berichten, dass sie durch KI-Assistenz mehr Zeit für kreative und komplexe Aufgaben gewinnen – der Fokus verschiebt sich vom Tippen zum Denken. In Studien geben rund drei Viertel der Copilot-Nutzenden an, produktiver und zufriedener zu sein. Gleichzeitig verändern sich die Kompetenzanforderungen: Weniger zählt das auswendig gelernte API-Wissen, mehr das Verständnis für Konzepte, Architektur und die Fähigkeit, KI-Outputs einzuschätzen. Spannend ist dabei die Entwicklung der Teamarbeit. Untersuchungen zeigen, dass KI-Werkzeuge auch die Zusammenarbeit im Team fördern können – sie reduzieren monotone Aufgaben, sorgen für konsistenten Code-Stil und ermöglichen einen schnelleren Wissenstransfer. Doch damit diese neuen Möglichkeiten genutzt werden können, braucht es gemeinsame Regeln, klare Kommunikation und die Fähigkeit, KI nicht als Blackbox, sondern als Partner zu verstehen. Die Arbeit in Entwicklerteams wird dadurch nicht ersetzt, sondern neu konfiguriert: mit mehr Fokus auf Dialog, Verantwortung und kollektive Qualitätssicherung.

Warum No-Code und Low-Code durch KI nicht verdrängt sondern erweitert werden

No-Code- und Low-Code-Plattformen sind nicht neu, doch durch KI gewinnen sie eine neue Dimension. Für Fachanwender ohne Programmierkenntnisse bieten No-Code-Lösungen einfache Wege zur App-Erstellung, werden aber durch KI-Sprachschnittstellen wie bei Microsofts Power Platform noch zugänglicher. Low-Code-Frameworks richten sich an technisch versierte Nutzer, die mit wenig Code viel erreichen wollen – und genau hier entfaltet die KI ihre Stärke: Sie ergänzt Konfigurationen um gezielt generierten Code für Validierungen oder Workflows. Doch in beiden Fällen gilt: Je spezifischer die Anforderungen, desto schneller stoßen Nutzer an systemische Grenzen. Full-Code bleibt der Raum mit der größten Freiheit – und den größten Herausforderungen. Hier kann KI immense Produktivitätsgewinne liefern, etwa bei Boilerplate, Migrationen oder Testgenerierung. Doch auch hier gilt: Entscheidungen zu Architektur, Sicherheit oder Performance verlangen menschliche Expertise. KI kann vorschlagen, aber nicht entscheiden. Wer blind vertraut, riskiert Sicherheitslücken oder unwartbaren Code. Das Zusammenspiel von Automatisierung und menschlicher Verantwortung wird zum entscheidenden Faktor – und zeigt: Die Zukunft gehört denjenigen, die beide Seiten beherrschen.

Was die neue Rollenverteilung zwischen Mensch und Maschine für die Zukunft bedeutet

Automatisiertes Programmieren wird kein kurzfristiger Hype bleiben – zu stark sind die Vorteile, zu breit der Einsatz. Doch die Vorstellung, dass KI den Menschen ersetzt, greift zu kurz. Vielmehr entsteht ein neues Modell der Zusammenarbeit, in dem Menschen den Rahmen setzen, die Qualität sichern und die eigentliche Problemlösung vorantreiben. Entwickler der Zukunft werden nicht weniger gebraucht, sondern anders: weniger als Code-Schreiber, mehr als Architekten, Kommunikatoren und Kritiker ihrer maschinellen Partner. Die Fähigkeiten, die sie brauchen, ändern sich: vom präzisen Prompting über das kritische Denken bis zur Zusammenarbeit in Teams, die KI als kollektiven Helfer nutzen. Bildungseinrichtungen, Unternehmen und Entwicklergemeinschaften sind gefragt, diesen Wandel zu gestalten – mit neuen Curricula, klugen Leitlinien und einer Kultur, die Automatisierung nicht als Ersatz, sondern als Erweiterung versteht. Wenn das gelingt, wird Softwareentwicklung nicht nur schneller und effizienter, sondern auch menschenzentrierter: Die Routine übernimmt die Maschine, die Wertschöpfung bleibt in menschlicher Hand.

Quelle: Anthropic

Claude Agent SDK: Anthropic stellt ein neues Harness-Design für langlebige KI-Agenten vor, das Initializer- und Coding-Agenten kombiniert. Ziel ist es, konsistenten Fortschritt über viele Kontextfenster hinweg zu ermöglichen – ein zentrales Problem bei komplexen Langzeitaufgaben wie Softwareentwicklung. Der Initializer legt eine strukturierte Projektbasis an (u. a. Feature-Liste, Fortschrittslog,

init.sh), während Coding-Agenten schrittweise daran weiterarbeiten und ihre Arbeit dokumentieren. Git, JSON-basierte Feature-Tests und End-to-End-Validierung minimieren Fehler und fördern Agenten-Kollaboration über Sessions hinweg.Claude Opus 4.5: Das neue Flagship-Modell ist das bislang leistungsstärkste Modell von Anthropic – mit überlegenen Fähigkeiten in Programmierung, Recherche, Tabellenkalkulation und Agentensystemen. In Benchmarks wie SWE-bench übertrifft es sowohl Vorgängermodelle als auch menschliche Kandidaten. Durch geringeren Tokenverbrauch bei höherer Präzision ermöglicht es effizientere Workflows. Neue Features wie Effort Control, verbesserte Sicherheit gegen Prompt Injection und erweiterte Tool-Nutzung machen Opus 4.5 besonders für Entwickler produktiv einsetzbar. Updates in Apps wie Claude Code und Excel stärken die Integration in den Arbeitsalltag spürbar.

Project Iceberg: Das MIT-geführte Projekt entwickelt mit dem Iceberg Index eine skillbasierte Kennzahl, die den Lohnanteil von Tätigkeiten misst, den KI-Systeme technisch ausführen können, ohne Beschäftigungseffekte zu prognostizieren. Es modelliert 151 Mio. US-Arbeitskräfte, 32.000 Fähigkeiten und über 13.000 KI-Tools auf Kreis- und Berufsebene und zeigt, dass sichtbare Tech-Adoption (2,2 % Lohnwert) nur die Spitze ist; kognitive und administrative Aufgaben mit 11,7 % Exposition verteilen sich auf alle Bundesstaaten. Karten im Paper belegen die landesweite Streuung der Exposition.

Google: Sicherheitsforscher zeigen, dass der agentische Code-Editor Antigravity über indirekte Prompt-Injection zur Exfiltration sensibler Daten manipuliert werden kann. Ein präparierter Implementierungsleitfaden zwingt Gemini dazu, Code und .env-Zugangsdaten auszulesen, Schutzmechanismen zu umgehen und über einen Browser-Subagenten an eine bösartige Domain zu senden, die in der Default-Allowlist steht. Die Kombination aus automatischer Ausführung, laxen Genehmigungsrichtlinien und parallelem Agentenbetrieb erhöht das Risiko unbemerkter Angriffe. Google verweist bislang auf bestehende Warnhinweise.

AI-Branche: Ein Branchenbericht warnt vor einer „COGS-Tsunami“, da viele KI-Dienste mit negativen Margen operieren. Hyperscaler und Neocloud-Anbieter tragen hohe GPU-Vorabinvestitionen, während Anbieter wie OpenAI, Anthropic oder Cursor Nutzer mit stark subventionierten Preisen verwöhnen. Da KI-SaaS im Gegensatz zu Netflix keine sublinearen Kosten kennt – jede Anfrage erzeugt neue Tokenkosten – wird sich die Branche wohl von pauschalen Abomodellen hin zu nutzungsbasierten Preisen bewegen müssen. Ohne Preisanpassungen drohen Überinvestition, Nachfrageeinbruch und Überkapazitäten.

Grok 5: Mit einem neuen agentischen KI-System zielt Grok darauf ab, komplexe Aufgaben in Computerspielen und -schnittstellen allein durch Kamerastreams und ohne APIs zu lösen – in unter 150 ms Reaktionszeit. Der Agent erkennt Benutzeroberflächen aus Pixelinput, plant und handelt unter hohem Zeitdruck sowie unvollständiger Information und führt Maus- und Tastaturaktionen autonom aus. Gelingt dies, wäre es ein fundamentaler Durchbruch: Die Automatisierung beliebiger Computeraufgaben – auch ohne API-Zugriff – würde in menschenähnlicher oder übermenschlicher Geschwindigkeit Realität.

SSI: Ilya Sutskever beschreibt in einem ausführlichen Gespräch die Vision und Strategie von Safe Superintelligence Inc. (SSI) für die Entwicklung von Superintelligenz. Er kritisiert die begrenzte Generalisierungsfähigkeit heutiger LLMs trotz beeindruckender Benchmarks und fordert eine Rückkehr zur forschungsgetriebenen Innovation. Zentrale These: Künftige Systeme müssen kontinuierlich lernen, robust generalisieren und menschenähnliche Wertfunktionen entwickeln. SSI verfolgt einen alternativen technischen Ansatz mit dem Ziel, eine sicher ausgerichtete, sentienzfreundliche Superintelligenz zu schaffen – schrittweise, aber mit langfristiger globaler Wirkung.

DeepSeekMath-V2: Das Forschungsteam hinter DeepSeekMath-V2 präsentiert ein neues Sprachmodell, das mathematische Beweisführung nicht nur generiert, sondern auch eigenständig überprüft. Ziel ist es, eine zuverlässige Selbstverifikation zu etablieren, um insbesondere bei offenen Problemen ohne bekannte Lösung eine höhere Genauigkeit und Nachvollziehbarkeit zu gewährleisten. Durch die Kopplung eines Beweisgenerators mit einem trainierten Verifikator als Belohnungsmodell konnte das System auf Wettbewerben wie IMO 2025 und Putnam 2024 herausragende Ergebnisse erzielen.

Harvard Medical School: Forschende stellen mit popEVE ein KI-Modell vor, das genetische Varianten nach ihrer Wahrscheinlichkeit für Krankheitsverursachung bewertet und damit Diagnosen seltener, monogener Erkrankungen beschleunigen soll. PopEVE kombiniert evolutionsbiologische Daten, Protein-LLMs und Bevölkerungsgenetik, wodurch Varianten erstmals vergleichbar über verschiedene Gene hinweg priorisiert werden können. In Studien identifizierte das Modell über 100 bisher unbekannte krankheitsrelevante Veränderungen und ermöglichte bei einem Drittel von 30.000 unklaren Fällen eine Diagnose. Klinische Partner testen das Tool bereits.

ToolOrchestra: Das Forschungsteam stellt mit ToolOrchestra ein neues System vor, das kleine Orchestrierungsmodelle nutzt, um spezialisierte KI-Werkzeuge effizient zu koordinieren. Ziel ist es, komplexe Aufgaben wie die Humanity’s Last Exam (HLE) kostengünstiger und leistungsfähiger zu lösen. Der entwickelte Orchestrator (8B-Parameter) übertrifft GPT-5 bei Genauigkeit und Effizienz deutlich – u. a. mit 37,1 % auf HLE (vs. 35,1 %) bei 2,5-facher Kosteneinsparung. Die Methode kombiniert gezieltes Reinforcement Learning mit Tool-Nutzung nach Nutzerpräferenz und zeigt starke Generalisierung auf neue Werkzeuge.

Buch

Denken als Schlüssel zur Veränderung

Quelle: Piper Verlag

Impuls der Woche: 101 Essays, die Ihre Denkweise verändern werden

Inhalt: Diese Essaysammlung fordert dazu auf, grundlegende Annahmen über Glück, Erfolg und Selbstbild zu hinterfragen. Besonders relevant ist die Betonung emotionaler Intelligenz und unterbewusster Überzeugungen als Hebel für echte Veränderung. Leser erhalten keine einfachen Antworten, sondern präzise Impulse zur Selbstreflexion und zur bewussten Gestaltung ihres Denkens.

Kontext: Die US-amerikanische Autorin Brianna Wiest hat sich mit ihrer klaren, empathischen Sprache und einem psychologisch fundierten Ansatz als Stimme der modernen Selbsthilfeliteratur etabliert. Ihr Werk verbindet zeitlose Philosophie mit aktuellen Fragestellungen und bietet Führungskräften wie wertvolle Denkanstöße für persönliche und berufliche Weiterentwicklung.

Ihre Meinung interessiert uns

In welchen KI-Einsatzfeldern möchten Sie Ihre Kompetenzen als Nächstes vertiefen?

Ergebnisse der vorherigen Umfrage

Wie gut fühlen Sie sich aktuell in der wachsenden Vielfalt von KI-Tools, Anwendungen und Möglichkeiten orientiert?

🟨🟨🟨⬜️⬜️⬜️ 🌪️ Ich empfinde die KI- und Tool-Landschaft als überfordernd

🟩🟩🟩🟩🟩🟩 🧭 Ich erkenne Potenziale, brauche aber Orientierung

🟨🟨🟨⬜️⬜️⬜️ 🔍 Ich komme gut zurecht, suche aber gezielte Vertiefungen

🟨⬜️⬜️⬜️⬜️⬜️ 🧘 Ich fühle mich bereits sehr sicher und gut informiert

Bildung

Warum Schulen KI nicht bekämpfen sollten sondern ihre Strukturen radikal anpassen müssen

Quelle: Shutterstock

Andrey Karpathy bringt es auf den Punkt: Der Versuch, KI-Nutzung bei Hausaufgaben zu kontrollieren, ist zum Scheitern verurteilt. Die technische Entwicklung hat einen Zustand erreicht, in dem jede außerhalb des Klassenzimmers erbrachte Leistung potenziell KI-gestützt ist – und zwar unabhängig davon, ob Schulen dies wünschen oder nicht. KI-Detektoren liefern unzuverlässige Resultate, erzeugen falsche Anschuldigungen und lassen sich leicht umgehen. Die logische Konsequenz aus Karpathys Sicht lautet daher: Die Annahme, dass Hausaufgaben ohne KI entstehen, ist nicht mehr haltbar.

Daraus folgt ein fundamentaler Wandel in der Leistungsbewertung. Karpathy argumentiert, dass Prüfungen und Leistungsnachweise wieder überwiegend in den Klassenraum zurückkehren müssen – in Umgebungen, in denen Lehrkräfte sicherstellen können, dass Schüler eigenständig arbeiten. Diese Rückverlagerung ist kein Rückschritt, sondern ein notwendiger Mechanismus, um Basiskompetenzen wirklich zu prüfen. Motivation entsteht dadurch, dass Schüler wissen: Im entscheidenden Moment müssen sie Probleme ohne digitale Unterstützung lösen können.

Gleichzeitig betont Karpathy, dass KI nicht aus dem Unterricht verbannt werden darf. Im Gegenteil: Die Technologie ist dauerhaft präsent und entwickelt sich zu einer der zentralen Infrastrukturkomponenten unserer Zeit. Der Vergleich mit dem Taschenrechner dient dabei als historische Orientierung. Schulen vermittelten weiterhin Arithmetik, obwohl der Taschenrechner überragend schneller war – nicht weil er verboten werden sollte, sondern weil grundlegendes Verständnis unverzichtbar blieb. Genau diese Mischung aus Nutzung und Kompetenz bildet das Bildungsfundament der KI-Ära.

Karpathy unterstreicht zudem, dass KI im Gegensatz zum Taschenrechner eine wesentlich höhere Fehleranfälligkeit besitzt. Sie erfordert ein geschultes Gespür für Plausibilität, für Quellenkritik und für die Einordnung technischer Antworten. Schulen müssen deshalb Lernräume schaffen, die sowohl den reflektierten Einsatz von KI als auch die bewusste Abwesenheit von Hilfsmitteln ermöglichen. Dazu gehören variierende Prüfungsdesigns: von klassischen Tests über offene Bücher bis hin zu Aufgaben, in denen KI-Antworten analysiert, bewertet oder verbessert werden.

Seine Botschaft an Bildungseinrichtungen ist klar: Der Weg in die Zukunft führt nicht über Verbote, sondern über strukturelle Anpassung. Nur wenn Schüler den Umgang mit KI beherrschen und zugleich befähigt werden, ohne sie kompetent zu handeln, entsteht echte Zukunftsfähigkeit. Schulen müssen diesen Paradigmenwechsel aktiv gestalten – nicht aus Ideologie, sondern aus Notwendigkeit.

Sie sind einer anderen Meinung? Oder Sie wollen einen Gastbeitrag veröffentlichen? Schreiben Sie uns gerne eine E-Mail indem Sie einfach auf diese Mail antworten.

Frontier AI

Wie KI-Coding-Agenten den gesamten Entwicklungszyklus transformieren

Quelle: OpenAI

Problemstellung: Traditionelle Softwareentwicklung ist oft durch repetitive Aufgaben, zeitintensive Implementierungen und langwierige Abstimmungen geprägt. Entwickler verlieren viel Zeit mit Boilerplate-Code, Testabdeckung, Dokumentation und der Navigation durch komplexe Codebasen – statt sich auf kreative und strategische Arbeit zu konzentrieren. Gleichzeitig steigt der Druck, schneller zu liefern, ohne dabei die Codequalität zu gefährden. KI-basierte Autovervollständigung hat hier bisher nur punktuell entlastet.

Lösung: Moderne Coding-Agenten wie Codex von OpenAI sind weit mehr als smarte Autovervollständiger. Sie übernehmen komplette Workflows innerhalb des Software Development Lifecycles (SDLC) – von der Planung bis zur Wartung. Durch sogenannte "Multi-Agent Workflows", persistentes Kontextgedächtnis und direkte Tool-Integration (z. B. mit Compilern, Test-Runners, Logging-Systemen) agieren diese Agenten zunehmend wie Co-Entwickler. Ingenieure verlagern ihren Fokus von der mechanischen Codeproduktion auf Architektur, Designentscheidungen und Qualitätskontrolle.

Anwendungsbeispiele:

Planung: Agenten analysieren Spezifikationen, gleichen diese mit dem Codebestand ab, erkennen Abhängigkeiten und schlagen Teilaufgaben vor. Dadurch entfallen viele Abstimmungsmeetings.

Design: Aus Textbeschreibungen oder UI-Mockups generieren sie Boilerplate-Code, implementieren Design Tokens und validieren Accessibility-Aspekte.

Build: Ganze Features – inkl. Datenmodelle, APIs, UI-Komponenten, Tests und Dokumentation – werden in einem konsistenten Agentenlauf erstellt. Engineers konzentrieren sich auf Domain-Logik und Performance-Kritik.

Test: Agenten identifizieren Edge Cases, erstellen Testsuites und halten diese aktuell. Sie interpretieren Testergebnisse und iterieren automatisch.

Review: PRs werden durch Agenten vorgereviewt, auf Fehler geprüft und mit Kommentaren versehen. Menschliche Reviewer konzentrieren sich auf Architektur und Long-Term-Fit.

Dokumentation: Funktionalitäten werden aus Code abgeleitet, automatisch beschrieben und in Release-Zyklen eingebunden. Entwickler gestalten die Doku-Strategie, statt sie komplett selbst zu schreiben.

Deployment & Wartung: Fehleranalysen basierend auf Logs, Deployments und Codeänderungen erfolgen automatisch – z. B. bei Incident Response oder Performance-Tuning.

Erklärungsansatz: Der entscheidende Fortschritt liegt in der Fähigkeit heutiger KI-Agenten, mehrere Stunden konsistent zu „denken“, Kontexte über viele Dateien hinweg zu verstehen und Tool-Ausgaben zu interpretieren. Statt nur Text zu generieren, führen sie eigenständig Toolchains aus, analysieren Feedback (z. B. aus Tests) und verbessern daraufhin ihren Output – ein agentisches System mit echten Feedbackschleifen. Engineers behalten dabei die Kontrolle, doch die Ausführung der „mechanischen“ Tätigkeiten wird zunehmend automatisiert.

Fazit: KI-Coding-Agenten läuten einen Paradigmenwechsel in der Softwareentwicklung ein. Durch die Kombination aus tiefem Kontextverständnis, Tool-Nutzung und iterativer Verbesserung entsteht eine neue Art von Entwicklungsteam – das AI-native Engineering Team. Wer heute erste Workflows implementiert, kann die Entwicklungszyklen signifikant beschleunigen und Entwickler gezielter auf kreative, strategische Aufgaben fokussieren.

DeepMind

The Thinking Game | Full documentary | Tribeca Film

Was als Traum zweier KI-Besessener begann, hat das Potenzial, die Welt grundlegend zu verändern. Die Geschichte von DeepMind ist eine Reise voller Vision, Rückschläge und Durchbrüche – eine Geschichte über das Streben nach Allgemeiner künstlicher Intelligenz, das nun mit einem Nobelpreis für eine bahnbrechende Entdeckung in der Proteinforschung gekrönt wurde.

Demis Hassabis und Shane Legg gründeten DeepMind mit dem Ziel, ein System zu entwickeln, das wie ein Mensch lernen kann – nicht nur spezifische Aufgaben, sondern jede beliebige. Ihre Forschung, beginnend mit klassischen Atari-Spielen, führte zu historischen Erfolgen wie AlphaGo und AlphaZero. Doch das wahre Ziel war größer: wissenschaftliche Probleme lösen, die bisher als unlösbar galten. Mit AlphaFold gelang ihnen ein solcher Meilenstein – ein KI-System, das Proteinstrukturen präzise vorhersagen kann und damit neue Wege in Medizin und Biotechnologie eröffnet.

Was dieses Projekt besonders macht, ist nicht nur die wissenschaftliche Brillanz, sondern die Haltung dahinter: Der Quellcode wurde veröffentlicht, die Vorhersagen für Millionen von Proteinen öffentlich gemacht – ein Geschenk an die Welt, das Forschung weltweit beschleunigt und demokratisiert. Der Chemie-Nobelpreis 2024 war der verdiente Lohn für diesen ethisch motivierten Durchbruch.

Doch DeepMind ist noch lange nicht am Ziel. Die Frage bleibt: Was geschieht, wenn ein System entsteht, das dem menschlichen Denken nicht nur ebenbürtig, sondern überlegen ist? Das Video dokumentiert nicht nur den technischen Fortschritt, sondern auch die ethische Verantwortung, die mit dieser Entwicklung einhergeht.

Werben im KI-Briefing

Möchten Sie Ihr Produkt, Ihre Marke oder Dienstleistung gezielt vor führenden deutschsprachigen Entscheidungsträgern platzieren?

Das KI-Briefing erreicht eine exklusive Leserschaft aus Wirtschaft, Politik und Zivilgesellschaft – von C-Level-Führungskräften über politische Akteure bis hin zu Vordenkern und Experten. Kontaktieren Sie uns, um maßgeschneiderte Kooperationsmöglichkeiten zu besprechen.

Und nächste Woche…

... richtet sich unser Blick in der kommenden Woche auf die KI-Gesetzgebung in Europa und die aktuelle Entscheidung der EU-Kommission, die Einführung des AI Acts zu verschieben. Was bedeutet das für europäische Unternehmen, die Tech-Industrie und das internationale Rennen um KI-Vorreiterrollen? Wir beleuchten die Hintergründe, diskutieren Chancen und Risiken und zeigen auf, wie sich regulatorische Flexibilität mit Innovationsförderung vereinbaren lässt.

Wir freuen uns, dass Sie das KI-Briefing regelmäßig lesen. Falls Sie Vorschläge haben, wie wir es noch wertvoller für Sie machen können, spezifische Themenwünsche haben, zögern Sie nicht, auf diese E-Mail zu antworten. Bis zum nächsten mal mit vielen neuen spannenden Insights.