Guten Morgen!

In dieser Woche stehen gleich mehrere Entwicklungen im Zentrum, die zeigen, wie schnell sich das Feld der KI weiterentwickelt – auf technischer, wirtschaftlicher und geopolitischer Ebene. Besonders beeindruckend: Googles neuer Quantenchip Willow, der einen entscheidenden Durchbruch bei Fehlerkorrektur und Leistungsfähigkeit erzielt hat – ein Meilenstein, der das Quantencomputing aus dem Labor in reale Anwendungsfelder bringt.

Während Nvidia in China neue Geschäftsbedingungen durchsetzt, um geopolitische Risiken abzufedern, geraten Deals wie Metas geplanter Manus-Kauf zunehmend ins Visier staatlicher Kontrolle. KI ist kein reines Innovations- oder Wirtschaftsthema mehr – sie wird zur strategischen Ressource mit globaler Tragweite.

Damit das KI-Briefing für Sie maximal nützlich bleibt, freuen wir uns über Ihr Feedback. Teilen Sie uns gerne mit, welche Impulse für Sie am wertvollsten sind – und helfen Sie dabei, unser Briefing in Ihrem Netzwerk bekannt zu machen. Gemeinsam können wir eine Community aufbauen, die voneinander lernt und sich gegenseitig stärkt. Falls Sie diesen Newsletter weitergeleitet bekommen haben, können Sie sich ganz einfach hier anmelden.

Was Sie in diesem Briefing erwartet

News: Googles Quantum AI Lab setzt neuen Maßstab beim Quantencomputing, Nvidia verlangt Vorauszahlung für KI-Chips in China, China warnt vor Meta-Übernahme des KI-Startups Manus, Gmail startet mit Gemini eine neue KI-Ära, NVIDIA stellt Rubin-Plattform für KI-Fabriken vor, Elon Musk erreicht Prozessbeginn gegen OpenAI & ChatGPT Moment für die Fabrik der Zukunft

Deep Dive: Wie Europa seine digitale Selbstbestimmung zurückerobern kann und warum das jetzt entscheidend ist

In aller Kürze: AMD stellt MI440X auf der CES 2026 vor und kündigt massive Leistungssteigerung für 2027 an, xAI sammelt 20 Milliarden Dollar für Grok-Ausbau und Supercomputer-Infrastruktur ein, Anthropic plant 10-Milliarden-Finanzierungsrunde bei 350-Milliarden-Bewertung, Google startet mit Gemini neue KI-Agenten für den Einzelhandel & Zhipu geht als erster „AI Tiger“ an die Börse und investiert stark in F&E

Videos & Artikel: OpenAI startet ChatGPT Health zur sicheren Integration persönlicher Gesundheitsdaten, Utah erlaubt erstmals autonome KI für Rezeptverlängerungen mit Doctronic, Microsoft bringt Copilot Checkout und Brand Agents für KI gestützten Onlinehandel, Cursor verbessert Coding Agents mit dynamischer Kontextsteuerung & MIT Studie zeigt veränderte Gehirnaktivität beim Schreiben mit KI Unterstützung

Impuls: Emotionen als strategische Ressource

Umfrage: Was fehlt Ihnen heute am meisten für den konkreten Schritt von der KI Vision zur praktischen Umsetzung in Ihrem Team?

Meinung der Redaktion: Das Betriebssystem der Freiheit: Warum digitale Souveränität über die Zukunft des europäischen Modells entscheidet 🇪🇺

Praxisbeispiel: Mathematik der Kreativität

YouTube: Warum 2025 das Jahr war in dem wir alle dieselben Fragen stellten

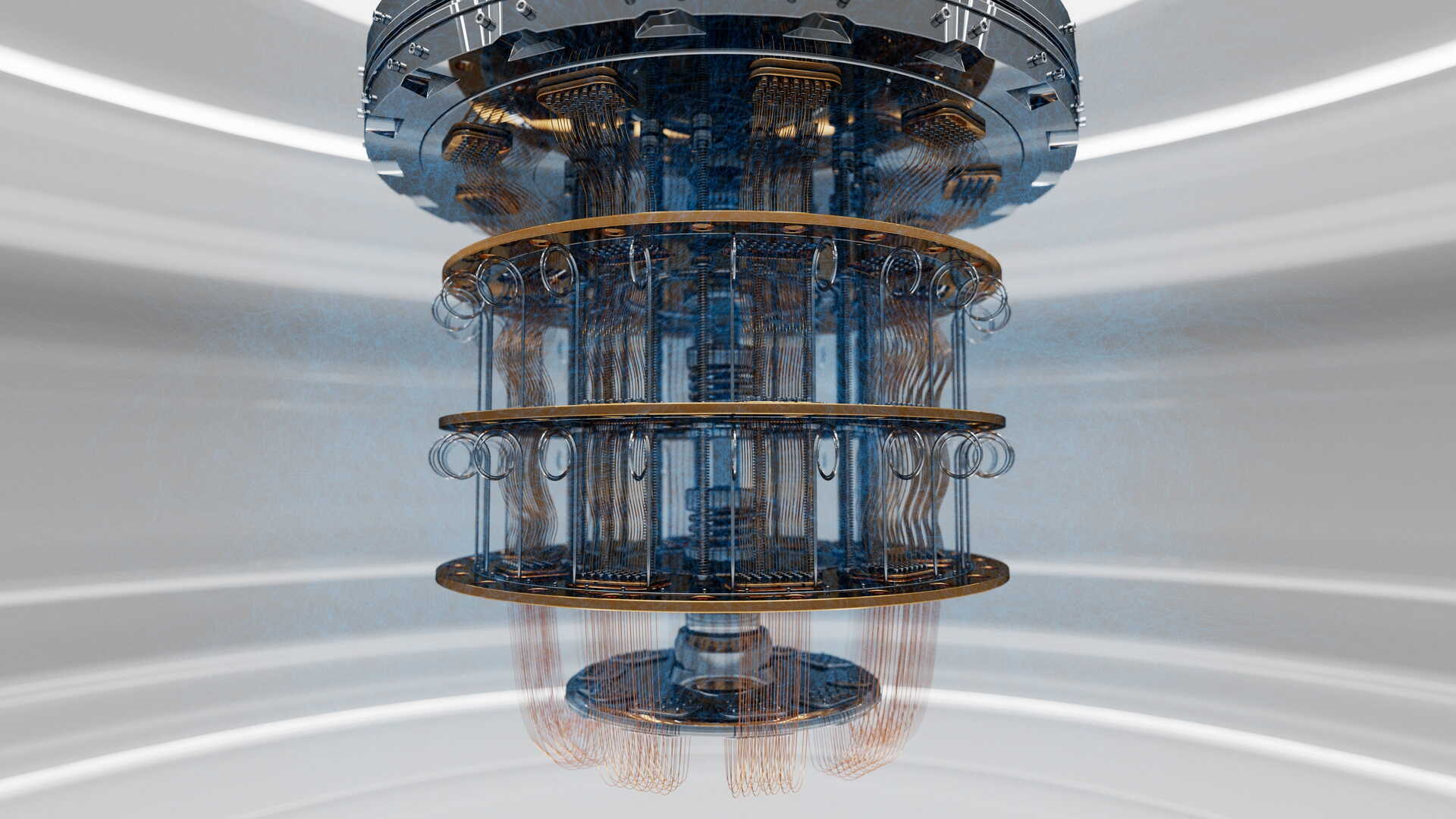

Quantencomputing

Googles Quantum AI Lab setzt neuen Maßstab beim Quantencomputing

Quelle: Shutterstock

Zusammenfassung: Google hat in seinem Quantum AI Lab in Kalifornien mit dem Quantenchip „Willow“ einen technologischen Durchbruch erzielt. Das 105-Qubit-System demonstrierte erstmals skalierbare Fehlerkorrektur – ein entscheidender Schritt hin zu praktischen Quantencomputern. Willow löste eine mathematische Benchmark-Aufgabe in wenigen Minuten, für die klassische Supercomputer länger als das Alter des Universums benötigt hätten. Damit unterstreicht Google seinen Anspruch auf „Quantum Advantage“ und bringt reale Anwendungen in Reichweite, etwa in der Medikamentenentwicklung, Energiesystemen oder Materialforschung. Die Entwicklungen markieren eine neue Phase im globalen Wettlauf um die technologische Vorherrschaft im Quantencomputing.

Technologischer Fortschritt: Willow zeigt erstmals, dass sich bei steigender Qubit-Zahl die Fehlerrate durch wiederholte Korrekturdurchläufe verringern lässt – ein entscheidender Beweis dafür, dass millionen-Qubit-Systeme technisch realisierbar sind und nicht länger nur als theoretisches Konzept gelten.

Exponentielle Rechenleistung: Der Chip löste ein Benchmark-Problem in wenigen Minuten, das klassischen Supercomputern 10^25 Jahre abverlangt hätte – ein quantitativer Leistungssprung, der die Überlegenheit gegenüber konventionellen Systemen eindrucksvoll demonstriert.

Strategische Positionierung: Während Microsoft mit acht Qubits noch im experimentellen Stadium verweilt, hat Google mit Willow eine Plattform entwickelt, die wissenschaftlich validiert, technologisch robust und für industrielle Anwendungen skalierbar ist.

Warum das wichtig ist: Googles Durchbruch bei der skalierbaren Fehlerkorrektur überführt Quantencomputing in die industrielle Anwendung und bietet die Chance, tiefgehende Domänenexpertise in der Chemie, Pharmazie oder Logistik mit einer Rechenleistung zu skalieren, die Innovationszyklen radikal verkürzt. Die Integration dieser Quanten-KI-Hybridarchitekturen in die F&E-Roadmap ermöglicht es, komplexe Optimierungsprobleme jenseits klassischer Kapazitäten zu lösen und die nächste Stufe der technologischen Wertschöpfung aktiv zu prägen. Wer diese Synergie frühzeitig nutzt, transformiert generative Ansätze in präzise, physikalisch fundierte Lösungen und sichert sich damit die gestalterische Führung in einem sich disruptiv wandelnden Marktumfeld.

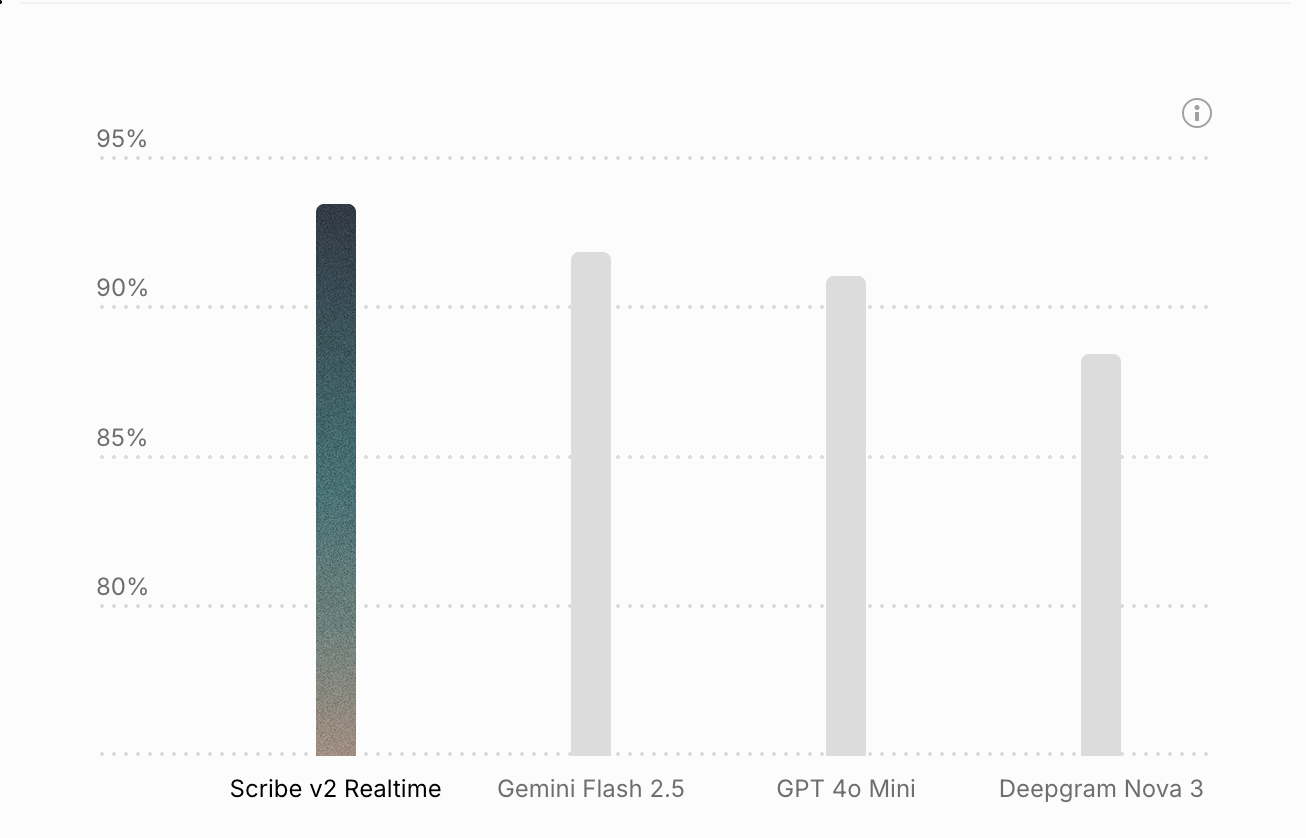

Präsentiert von ElevenLabs

Eleven Scribe v2: Die Industrialisierung des gesprochenen Wissens

Quelle: ElevenLabs

Zusammenfassung: Scribe v2 definiert die Grenze zwischen analoger Konversation und digitaler Wertschöpfung neu. Als derzeit präzisestes Speech-to-Text-Modell weltweit transformiert es unstrukturierte Audio-Daten in hochgradig strukturierte Business Intelligence – mit einer Genauigkeit, die menschliche Protokollierung in Geschwindigkeit und Detailtiefe weit übertrifft.

Kontextsensitive Intelligenz: Durch „Keyterm Prompting“ und die Erkennung von 56 Entitätskategorien (von PII bis Health-Data) werden Gespräche nicht nur transkribiert, sondern unmittelbar für automatisierte Prozesse kategorisiert.

Globale Echtzeit-Skalierung: Mit einer Latenz von unter 150 ms und automatischer Erkennung von über 90 Sprachen bildet Scribe v2 das sensorische Rückgrat für die nächste Generation autonomer KI-Agenten im globalen Einsatz.

Enterprise-Grade Compliance: Der „Zero-Retention-Mode“ kombiniert mit DSGVO- und SOC-2-Konformität garantiert absolute Souveränität über sensible Unternehmensdaten bei gleichzeitigem Zugriff auf State-of-the-Art-KI.

Warum das wichtig ist: Das Erreichen einer fehlerfreien, kontextbewussten Transkription durch Scribe v2 zeigt den Übergang von der bloßen Dokumentation zur aktiven Nutzbarmachung von „Dark Data“ – jenen 80 % des Wissens, die bisher in Meetings und Telefonaten ungenutzt blieben. Für die strategische Ausrichtung bedeutet dies die Chance, das gesamte kollektive Wissen der Organisation in Echtzeit in den digitalen Wissensgraph zu integrieren und so die Lücke zwischen menschlicher Interaktion und algorithmischer Entscheidungsfindung zu schließen. KI-Systeme agieren nicht mehr auf Basis lückenhafter Zusammenfassungen, sondern auf dem vollständigen, nuancierten Kontext der realen Geschäftswelt.

Jetzt den Vertrieb kontaktieren

Halbleiter & Lieferketten

Nvidia verlangt Vorauszahlung für KI-Chips in China

Quelle: Shutterstock

Zusammenfassung: Nvidia fordert von chinesischen Kunden ab sofort vollständige Vorauszahlung für Bestellungen seiner neuen H200-KI-Chips. Grund ist die Unsicherheit über regulatorische Genehmigungen aus Peking. Die Chipkäufe sind wegen möglicher Exportverbote riskant – Kunden können nach Bestellung weder stornieren noch Konfigurationen ändern. Die Maßnahme schützt Nvidia vor finanziellen Verlusten, da der Konzern in der Vergangenheit bereits Milliardenabschreibungen nach Exportstopps hinnehmen musste. Die H200-Chips, die rund 27.000 Dollar pro Stück kosten, sind derzeit extrem gefragt – chinesische Firmen haben über zwei Millionen Einheiten angefragt, während nur 700.000 auf Lager sind.

Hintergrund der Zahlungsbedingungen: Die chinesischen Behörden prüfen aktuell, welche Unternehmen H200-Chips importieren dürfen und in welchem Umfang lokale Alternativen wie Huaweis Ascend 910C parallel eingesetzt werden müssen – was die Planungssicherheit für Käufer erheblich beeinträchtigt.

Strategische Risikominimierung durch Nvidia: Durch die Vorauszahlung ohne Rücktrittsrecht lagert Nvidia das regulatorische Risiko vollständig auf die Kunden aus – ein direkter Schutzmechanismus vor möglichen Exportbeschränkungen oder politischen Interventionen in letzter Minute.

Bedeutung des H200 für den chinesischen Markt: Der H200 bietet sechsfache Leistung im Vergleich zu Vorgängermodellen und ist zentral für das Training großer KI-Modelle. Trotz nationaler Chipinitiativen bleibt Nvidia technologisch führend, was das Spannungsfeld zwischen Nachfrage und geopolitischen Barrieren verschärft.

Warum das wichtig ist: Nvidias restriktive Lieferkonditionen verdeutlichen die zunehmende Verknappung kritischer Rechenressourcen und definieren den gesicherten Zugriff auf High-End-Hardware als zentrales Differenzierungsmerkmal im globalen Wettbewerb. Diese Dynamik bietet die Chance, operative Resilienz durch eine frühzeitige Diversifizierung der Hardware-Basis und den Fokus auf compute-effiziente Algorithmen in einen direkten Marktvorteil zu verwandeln. Indem Versorgungssicherheit von einer operativen Einkaufsfrage zur strategischen Priorität erhoben wird, lassen sich Innovationsprozesse unabhängig von geopolitischen Verwerfungen absichern. Die Fähigkeit, performante KI-Modelle auf einer kontrollierbaren und flexiblen Infrastruktur zu skalieren, wird so zum entscheidenden Hebel, um Marktanteile in einer Phase volatiler Lieferketten nachhaltig zu festigen.

Geo-Politik

China warnt vor Meta-Übernahme des KI-Startups Manus

Quelle: Shutterstock

Zusammenfassung: Die geplante Übernahme des KI-Startups Manus durch Meta für rund 2,5 Milliarden Dollar stößt auf Widerstand in China. Obwohl Manus inzwischen in Singapur sitzt, stammt das Unternehmen aus China – Peking kündigte daher eine Prüfung des Deals an. Hintergrund ist die Sorge, dass chinesische KI-Talente und Technologien in den Westen abwandern könnten. Die chinesische Regierung erwägt, strategisch relevante KI-Entwicklungen künftig stärker zu kontrollieren oder mit Exportauflagen zu belegen. Manus entwickelt eine Agenten-KI, die komplexe Aufgaben automatisiert – Meta will insbesondere das Team und Know-how sichern. Peking sieht darin einen Präzedenzfall für den Verlust von Schlüsseltechnologie.

Geopolitischer Technologieschutz: Peking plant, KI-Technologien chinesischer Herkunft künftig stärker zu regulieren, etwa durch Exportkontrollen – ähnlich wie bei TikTok oder Algorithmen von ByteDance. Ziel ist es, den Abfluss von geistigem Eigentum zu verhindern und die technologische Souveränität zu bewahren.

Bedeutung des Manus-Deals für Meta: Meta sichert sich mit Manus Zugang zu fortschrittlicher Agenten-KI, die Aufgaben wie Reiseplanung oder komplexe Recherchen automatisiert. Die Übernahme zielt auf Know-how und Talente – ein strategischer Schritt im Wettbewerb mit OpenAI, Google und Anthropic.

Signalwirkung für chinesische Startups: Der Deal entfacht in China Besorgnis, dass andere aufstrebende Startups dem Beispiel folgen könnten. Die Aussicht auf Kapital und globale Sichtbarkeit durch US-Konzerne erhöht den Anreiz zur Verlagerung ins Ausland – ein Trend, den China eindämmen will.

Warum das wichtig ist: Der geopolitische Konflikt um die Übernahme von Manus durch Meta verdeutlicht die Transformation von KI-Agenten von kommerziellen Softwarelösungen hin zu geschützten nationalen Assets. Die Prüfung durch Peking signalisiert das Ende des uneingeschränkten Technologie-Exodus und etabliert einen algorithmischen Protektionismus, der den globalen Wettbewerb um Innovationskraft neu definiert. In diesem Spannungsfeld liegt die Chance für eine souveräne Positionierung darin, unabhängige agentische Ökosysteme zu fördern, die jenseits globaler Handelsbeschränkungen operieren können. Die Sicherung dieser technologischen Basis wird damit zur Grundvoraussetzung, um die nächste Stufe der industriellen Automatisierung als resilienten Bestandteil der eigenen Wertschöpfungskette zu etablieren und technologische Führerschaft jenseits der dominierenden Machtblöcke zu behaupten.

Gmail startet mit Gemini eine neue KI-Ära

Zusammenfassung: Google bringt mit Gemini eine umfassende KI-Integration in Gmail. Die neue Version des E-Mail-Dienstes bietet Nutzern künftig Funktionen wie KI-generierte Zusammenfassungen ganzer E-Mail-Verläufe, intelligente Antwortvorschläge und personalisierte To-do-Übersichten. Einige Funktionen wie die „AI Overviews“ stehen bereits allen zur Verfügung, während erweiterte Angebote zahlenden Google-AI-Abonnenten vorbehalten bleiben. Auch der „AI Inbox“-Assistent, der E-Mails nach Wichtigkeit sortiert, wird sukzessive eingeführt. Ziel ist es, Gmail zu einem proaktiven, persönlichen Assistenten auszubauen, der den Informationsfluss automatisiert und das E-Mail-Management deutlich vereinfacht.

Neue Interaktionsmöglichkeiten mit E-Mails: Mit den „AI Overviews“ lassen sich komplexe E-Mail-Verläufe automatisch zusammenfassen. Nutzer können Gmail per natürlicher Sprache nach Informationen durchsuchen und erhalten präzise Antworten, ohne manuell in der Inbox suchen zu müssen.

Effizienz durch intelligente Textfunktionen: Funktionen wie „Help Me Write“, „Suggested Replies“ und ein fortgeschrittener „Proofread“-Modus helfen beim Verfassen, Korrigieren und Beantworten von E-Mails. Die Antworten orientieren sich am individuellen Schreibstil und sind für alle Nutzer verfügbar – mit erweiterten Optionen für Pro- und Ultra-Abonnenten.

Fokus auf das Wesentliche mit AI Inbox: Die neue „AI Inbox“ identifiziert wichtige Kontakte und Aufgaben automatisch und filtert irrelevante Inhalte heraus. Der Nutzer erhält eine priorisierte Übersicht seiner Inbox, basierend auf Beziehungsdaten, Kontakten und Nachrichteninhalten – alles unter Einhaltung von Googles Datenschutzstandards.

Warum das wichtig ist: Die tiefe Integration von Gemini in Gmail transformiert die E-Mail-Kommunikation von einem reinen Informationsarchiv zu einer aktiven Ebene der Workflow-Orchestrierung. Dieser Schritt bietet die Chance, administrative Overhead-Kosten drastisch zu senken, indem generative Synthese und proaktives Aufgabenmanagement direkt am Entstehungspunkt der Information ansetzen. Durch die Automatisierung der Informationsdichte wird mentale Kapazität für wertschöpfende, strategische Aufgaben frei, was die operative Exzellenz auf ein neues Niveau hebt. Der strategische Vorsprung entsteht hierbei durch die Fähigkeit, diese Produktivitätssprünge nahtlos in die eigene Prozessarchitektur zu integrieren und gleichzeitig die Balance zwischen der Nutzung globaler Cloud-Intelligenz und der notwendigen Souveränität über geschäftskritische Kommunikationsflüsse zu wahren.

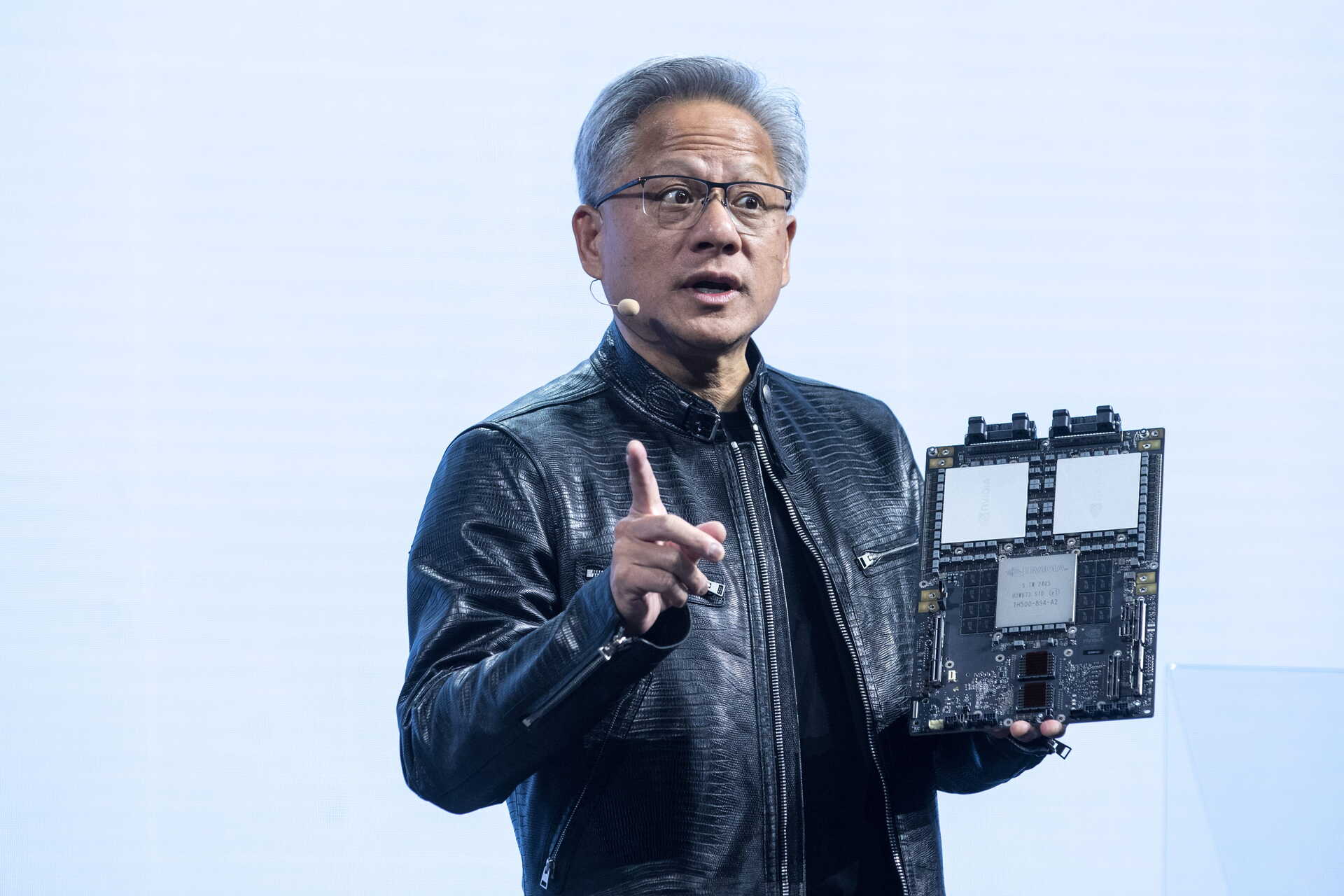

KI-Infrastruktur

NVIDIA stellt Rubin-Plattform für KI-Fabriken vor

Quelle: Shutterstock

Zusammenfassung: NVIDIA hat mit der Rubin-Plattform eine neue Infrastruktur vorgestellt, die speziell für KI-Fabriken entwickelt wurde. Im Zentrum stehen sechs neue Chips, darunter der Rubin-GPU und der Vera-CPU, die gemeinsam mit einem vollständig neu konzipierten Rack-System arbeiten. Die Plattform integriert Hardware und Software eng und erreicht so eine höhere Energieeffizienz und geringere Kosten pro Token. Besonders für Anwendungen mit langen Kontexten, reasoning-intensiven Modellen und Echtzeit-Inferenz verspricht Rubin massive Skalierung bei gleichzeitiger Betriebssicherheit. Rubin ersetzt nicht einzelne Komponenten, sondern definiert das Rechenzentrum selbst als neue Einheit der KI-Produktion.

Neue Recheneinheit für KI-Fabriken: Rubin verschiebt die klassische Server-Architektur zugunsten eines rack-zentrierten Ansatzes, bei dem CPUs, GPUs, Speicher, Kühlung und Software als einheitliches System entwickelt wurden. Dies ermöglicht eine effizientere Ausführung reasoning-basierter Modelle mit hohem Kommunikationsaufwand.

Skalierung bei gleichzeitig sinkenden Kosten: Rubin erlaubt die Reduzierung des GPU-Bedarfs bei Training großer Modelle um den Faktor vier und erreicht bis zu zehnmal niedrigere Inferenzkosten pro Million Tokens im Vergleich zu Vorgängergenerationen. Möglich wird dies durch extrem hohe Bandbreiten, neue Speicherarchitekturen und optimierte Kommunikationspfade.

Verfügbarkeit und Betriebssicherheit auf neuem Niveau: Die Plattform unterstützt Zero-Downtime-Betrieb, rackweite Fehlertoleranz, umfassende Sicherheitsfunktionen und hohe Energieeffizienz. Ein Beispiel ist die Integration von Flüssigkühlung mit 45 °C und lokaler Energiepufferung, die Lastspitzen glättet und bis zu 30 % mehr Rechenleistung pro Megawatt ermöglicht.

Warum das wichtig ist: Die Rubin-Plattform überführt das Rechenzentrum in eine integrierte industrielle Produktionsstätte für Intelligenz und löst damit die kritischen Restriktionen bei Skalierbarkeit und Energieeffizienz auf. Dieser technologische Sprung erlaubt es, die Rentabilität von KI-Initiativen durch eine massive Senkung der Token-Kosten zu sichern und gleichzeitig die operative Resilienz durch rack-zentrierte Infrastrukturen zu stärken. Die Chance liegt darin, spezialisierte „AI Factories“ als Rückgrat der eigenen Wertschöpfung zu etablieren, um komplexe Reasoning-Modelle mit bisher unerreichter Effizienz zu skalieren. Wer die Infrastruktur nicht länger als IT-Kostenstelle, sondern als hochoptimiertes Produktionsmittel begreift, gewinnt die notwendige Agilität, um technologische Standards aktiv zu setzen und die Abhängigkeit von reiner Rechenkapazität in einen strategischen Wettbewerbsvorteil zu verwandeln.

Legal

Elon Musk erreicht Prozessbeginn gegen OpenAI

Quelle: Shutterstock

Zusammenfassung: Elon Musk hat einen juristischen Teilerfolg gegen OpenAI erzielt: Ein US-Gericht lässt seine Klage wegen Vertragsbruchs zu. Musk wirft dem Unternehmen vor, sich von seiner ursprünglich gemeinnützigen Mission entfernt zu haben, um finanzielle Interessen – insbesondere durch die Zusammenarbeit mit Microsoft – in den Vordergrund zu stellen. Die Klage wird im März 2026 einer Jury vorgelegt. OpenAI und CEO Sam Altman weisen die Vorwürfe zurück und werfen Musk vor, als frustrierter Konkurrent zu agieren. Der Streit beleuchtet Grundsatzfragen zur ethischen Ausrichtung von KI-Entwicklung.

Hintergrund der Klage: Musk kritisiert den Umbau von OpenAI in eine profitorientierte Struktur, obwohl laut seiner Darstellung vertraglich vereinbart war, dass die Organisation dem Gemeinwohl verpflichtet bleibt. Er sieht in der engen Microsoft-Partnerschaft einen klaren Bruch mit dieser Vereinbarung.

Reaktionen der Gegenseite: OpenAI, Sam Altman und Microsoft weisen die Anschuldigungen entschieden zurück. Sie argumentieren, dass die aktuelle Unternehmensstruktur soziale und wirtschaftliche Ziele vereint und sehen in Musks Klage einen Versuch, einem führenden Wettbewerber zu schaden.

Bedeutung für den KI-Markt: Der Fall bringt zentrale Fragen zur Governance in der KI-Industrie auf die Agenda. Er könnte Präzedenzwirkung haben für die Ausgestaltung künftiger Public-Benefit-Strukturen und die Balance zwischen Innovationsförderung und ethischer Verantwortung.

Warum das wichtig ist: Die juristische Auseinandersetzung um die Ausrichtung von OpenAI rückt die Governance-Strukturen hinter der Technologie als geschäftskritisches Risikoelement in das Blickfeld der strategischen Planung. Diese Unsicherheit eröffnet die Chance, die eigene KI-Strategie durch eine stärkere Diversifizierung und den Fokus auf transparente, werteorientierte Partnermodelle resilienter zu gestalten. Indem rechtliche Integrität und missionarische Klarheit als Kriterien für die Anbieterauswahl priorisiert werden, lässt sich eine langfristige Planungssicherheit etablieren, die unabhängig von machtpolitischen Volatilitäten einzelner Marktführer bleibt. Der Aufbau eines Multi-Modell-Ökosystems, das auf verlässlichen Governance-Standards basiert, wird somit zum entscheidenden Vorteil, um technologische Agilität mit maximaler operativer Stabilität zu verbinden.

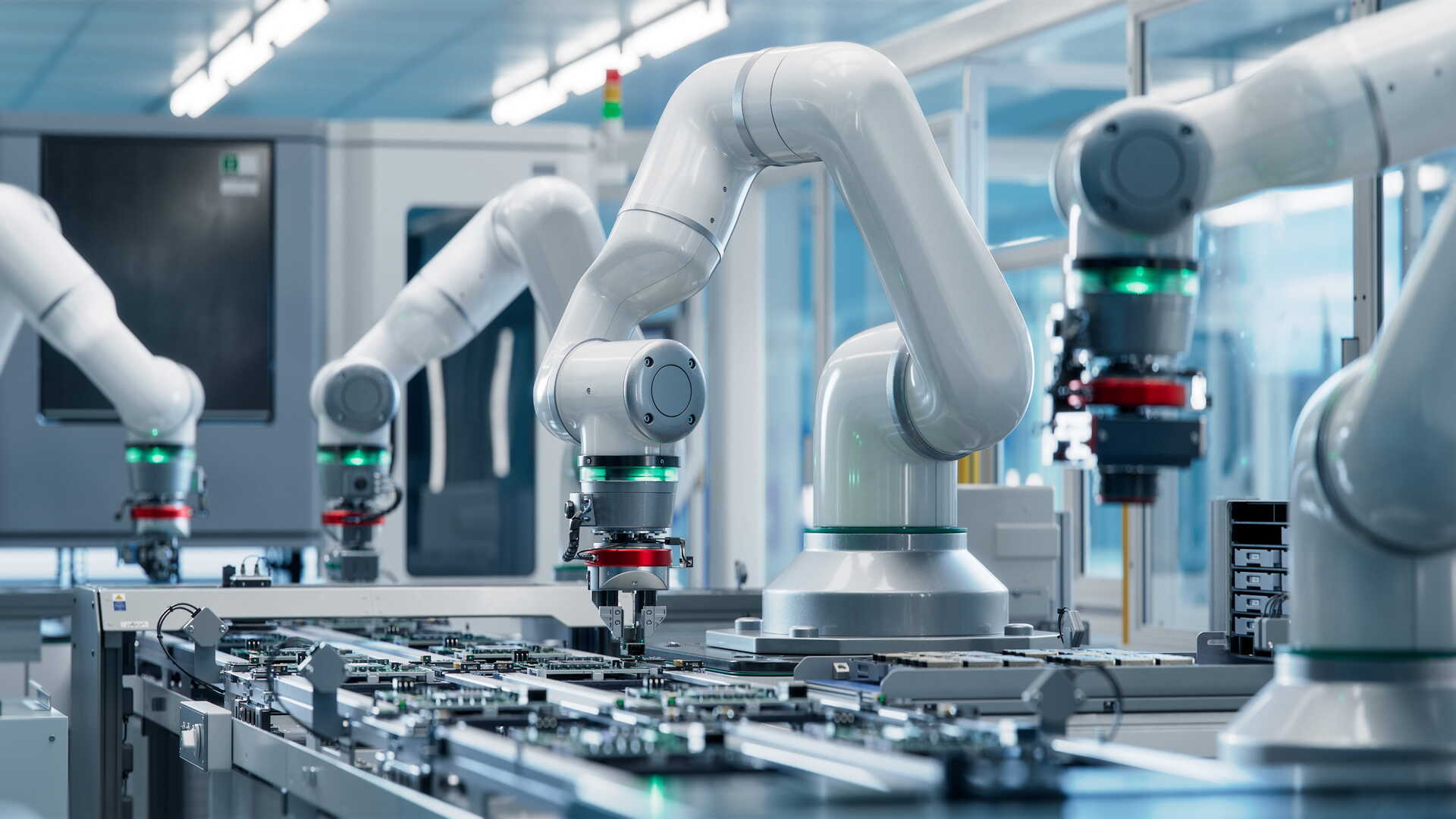

Industrielle KI

ChatGPT Moment für die Fabrik der Zukunft

Quelle: Shutterstock

Zusammenfassung: Die moderne Fertigung verändert sich: Künstliche Intelligenz transformiert nicht nur Software, sondern auch die physische Produktion. Fortschritte in Robotik, Software und Simulation machen Fabriken flexibler, autonomer und effizienter. Während Roboter früher starre Aufgaben ausführten, helfen generative KI‑Modelle heute, reale physische Prozesse zu simulieren, anzupassen und zu steuern. Große Unternehmen wie Siemens investieren massiv in digitale Zwillinge und KI‑Assistenzsysteme. Gleichzeitig sinken die Kosten für Automatisierungshardware, was die Verbreitung intelligenter Produktion beschleunigt. Analysten sehen 2026 als Jahr des deutlichen Wachstums für Automatisierungstechnik.

Wachstumsprognose für Automatisierung: Marktentwicklung: Der Absatz von Industrierobotern und Automatisierungsausrüstung hatte in den letzten Jahren stagniert, soll aber 2026 deutlich steigen, getrieben durch niedrigere Zinsen, politische Förderung der Industrieproduktion und Fachkräftemangel, der Automatisierung attraktiver macht.

Technologische Durchbrüche: Software und Simulation: Fortschritte bei digitalen Zwillingen, KI‑gesteuerter Robotik und generativen Modellen reduzieren die „Sim‑to‑Real‑Lücke“, verbessern Programmierbarkeit und Flexibilität von Maschinen und steigern damit die Einsatzbreite und Effizienz von Automatisierungssystemen.

Neue Fabrikarchitekturen: Strukturwandel der Produktion: Anstelle großer „Gigafactories“ könnten vernetzte, kleinere und KI‑gestützte Fertigungsstandorte entstehen, die näher an urbanen Zentren liegen, schneller auf Nachfrageänderungen reagieren und Risiken über ein verteiltes Netzwerk minimieren.

Warum das wichtig ist: Die Integration generativer Modelle in die physische Produktion transformiert die Fabrik von einer starren Ausführungseinheit zu einem lernenden, adaptiven System. Durch die erfolgreiche Überwindung der „Sim-to-Real“-Lücke lassen sich komplexe Fertigungsprozesse virtuell perfektionieren und verzögerungsfrei in die Fläche skalieren, was die Time-to-Market für physische Produkte massiv verkürzt. Diese Entwicklung bietet die Chance, dem Fachkräftemangel durch autonome Assistenzsysteme zu begegnen und gleichzeitig resiliente, dezentrale Produktionsnetzwerke zu etablieren, die unmittelbar auf lokale Marktimpulse reagieren können. Wer die Symbiose aus digitalem Zwilling und KI-gesteuerter Robotik als Kern der operativen Exzellenz begreift, gewinnt die nötige Flexibilität, um durch minimale Rüstzeiten und hochgradige Individualisierung die technologische Marktführung in einem volatilen Umfeld zu behaupten.

Digital Souveränität

Wie Europa seine digitale Selbstbestimmung zurückerobern kann und warum das jetzt entscheidend ist

Quelle: Shutterstock

Digitale Technologien entscheiden heute nicht nur über Wirtschaftswachstum, sondern zunehmend auch über politische Souveränität, gesellschaftliche Teilhabe und individuelle Freiheit. Doch wer kontrolliert eigentlich die Infrastrukturen, Plattformen und Datenströme, auf denen unsere digitale Welt basiert? Und wie abhängig sind Europa, seine Unternehmen und seine Bürgerinnen und Bürger von Tech-Giganten aus den USA oder staatsnahen Systemen wie in China? Inmitten globaler Umbrüche wächst der Wunsch nach digitaler Unabhängigkeit – nicht als technischer Selbstzweck, sondern als Voraussetzung für Selbstbestimmung in einer politisch fragmentierten Welt. Digitale Souveränität ist damit zu einem Leitmotiv geworden, das weit über IT-Strategien hinausweist.

Digitale Souveränität meint die Fähigkeit von Staaten, Unternehmen und Individuen, in der digitalen Welt eigenständig zu handeln und über Technologien, Daten und Infrastrukturen selbst zu bestimmen. Dabei steht der Begriff im Spannungsfeld zwischen Freiheit und Kontrolle, Offenheit und Protektionismus. Für Europa ist digitale Souveränität zu einer strategischen Notwendigkeit geworden, um zwischen den beiden digitalen Supermächten USA und China nicht zerrieben zu werden. Doch der Weg dahin ist komplex: Es geht um technologische Unabhängigkeit, den Aufbau eigener Kompetenzen, das Durchsetzen regulatorischer Standards – und um die Fähigkeit, digitale Zukunft auf Basis demokratischer Werte zu gestalten.

Globale Machtverschiebungen machen digitale Selbstbestimmung zur sicherheitspolitischen Frage

Digitale Souveränität ist längst kein Nischenthema der Netzpolitik mehr, sondern ein geopolitisches Schlüsselelement. Wer die Kontrolle über Daten, Software-Plattformen und digitale Infrastrukturen besitzt, bestimmt auch die Regeln für Innovation, Wirtschaft und politische Teilhabe. Die zunehmenden Spannungen zwischen den USA und China und mittlerweile Europa machen deutlich, wie digitale Technologien zum Instrument der Machtausübung werden: von Exportkontrollen über Cyberangriffe bis hin zu Sanktionen gegen einzelne Unternehmen. Europa steht in diesem Systemwettbewerb unter Druck – ökonomisch, sicherheitspolitisch und gesellschaftlich. Die Abhängigkeit von US-Cloud-Diensten oder asiatischer Halbleiterproduktion wirft die Frage auf, wie handlungsfähig wir im Ernstfall wirklich sind. Ohne souveräne digitale Infrastrukturen droht der Verlust politischer Autonomie. Die Diskussion um digitale Souveränität ist daher auch eine Debatte über Verteidigungsfähigkeit, Demokratieerhalt und Zukunftsfähigkeit Europas.

Wie Staaten, Unternehmen und Bürger digitale Souveränität unterschiedlich verstehen und anstreben

Die Idee digitaler Souveränität betrifft viele Ebenen – vom staatlichen Sicherheitsinteresse über wirtschaftliche Resilienz bis hin zur individuellen Freiheit. Für Regierungen bedeutet sie vor allem, kritische Infrastrukturen zu schützen, technologische Abhängigkeiten zu verringern und die Kontrolle über Bürgerdaten zu behalten. Dabei verfolgen Demokratien und autoritäre Systeme unterschiedliche Ziele: Während in Europa Werte wie Datenschutz und Grundrechte im Vordergrund stehen, setzen andere Staaten digitale Souveränität mit Zensur und Kontrolle gleich. Unternehmen wiederum sehen digitale Souveränität zunehmend als Risikofaktor im Geschäftsmodell: Über 90 Prozent deutscher Firmen befürchten, im Fall geopolitischer Spannungen von externen Technologien abgeschnitten zu werden – und damit ihre Handlungsfähigkeit zu verlieren. Auf individueller Ebene geht es um die Möglichkeit, frei zwischen digitalen Diensten zu wählen, eigene Daten zu schützen und nicht dauerhaft auf wenige große Plattformanbieter angewiesen zu sein. Trotz der unterschiedlichen Perspektiven eint alle Akteure ein zentrales Ziel: die Fähigkeit, im digitalen Raum selbstbestimmt zu agieren.

Mit offenen Technologien und eigener Infrastruktur aus der digitalen Abhängigkeit herauswachsen

Ein zentraler Hebel für digitale Souveränität liegt in der technologischen Unabhängigkeit. Europa muss strategisch entscheiden, in welchen Bereichen es eigene Kompetenzen aufbauen will – etwa bei Cloud-Infrastrukturen, KI-Anwendungen, Halbleitern oder Open-Source-Software. Projekte wie Gaia-X zeigen, dass sich auch föderierte, interoperable Systeme außerhalb der marktbeherrschenden US-Plattformen realisieren lassen – wenn der politische Wille vorhanden ist. Der EU Chips Act wiederum soll den Aufbau einer eigenständigen Halbleiterindustrie fördern, um kritische Lieferketten widerstandsfähiger zu machen. Auch Open-Source-Technologien gewinnen als strategische Ressourcen an Bedeutung: Sie ermöglichen Transparenz, Anpassbarkeit und Unabhängigkeit von einzelnen Herstellern. Europas Stärke könnte darin liegen, nicht nur eigene Technologien zu entwickeln, sondern globale Standards für digitale Offenheit, Sicherheit und Fairness zu setzen. Digitale Souveränität wird so zur Frage intelligenter Prioritätensetzung – nicht zum Rückzug ins Nationale, sondern zur bewussten Gestaltung globaler Technologielandschaften.

Die größte Gefahr liegt in der Selbsttäuschung über Souveränität als universellen Endzustand

Trotz aller Initiativen und Fortschritte bleibt digitale Souveränität ein komplexes, dynamisches Ziel – und kein fixer Zustand. Der Versuch, vollständige Unabhängigkeit in allen Bereichen zu erreichen, führt schnell zu Illusionen oder gar gefährlichen Abschottungstendenzen. Ein blinder Rückzug ins Nationale birgt das Risiko von Ineffizienz, Fragmentierung und Verlust internationaler Anschlussfähigkeit. Ebenso besteht die Gefahr, dass der Ruf nach Souveränität als Vorwand für Überwachung oder Protektionismus missbraucht wird. Entscheidend ist daher, digitale Souveränität als aktiven Prozess des Abwägens zu verstehen: Wo sind Abhängigkeiten tolerierbar, wo nicht? Welche Technologien gelten als systemrelevant? Wie lässt sich strategische Autonomie mit internationaler Kooperation vereinen? Es braucht eine neue Form von Wachsamkeit – gegenüber technologischen Monopolen ebenso wie gegenüber politischen Vereinfachungen. Der Weg zu echter Souveränität führt nicht über Kontrolle, sondern über Kompetenz, Resilienz und Offenheit.

Digitale Souveränität gelingt nur, wenn alle Ebenen Verantwortung übernehmen und kooperieren

Was bleibt, ist eine zentrale Einsicht: Digitale Souveränität ist kein reines Regierungsprojekt, sondern eine gesamtgesellschaftliche Aufgabe. Staaten müssen strategisch investieren, regulieren und für faire Spielregeln sorgen. Unternehmen müssen ihre Abhängigkeiten transparent machen und in resiliente Alternativen investieren. Und Bürgerinnen und Bürger müssen bereit sein, ihre digitale Umwelt aktiv mitzugestalten – durch informierte Entscheidungen, digitale Bildung und kritisches Konsumverhalten. Nur wenn alle Ebenen zusammenwirken, kann Europa in der digitalen Welt selbstbewusst, sicher und werteorientiert agieren.

Quelle: Shutterstock

AMD: Auf der CES 2026 präsentierte AMD mit dem MI440X einen neuen KI-Beschleuniger für kleinere Unternehmens-Rechenzentren. CEO Lisa Su betonte zudem die Leistungsfähigkeit des kommenden MI455X und kündigte die MI500-Serie für 2027 an, die eine bis zu 1.000-fache Performance gegenüber der MI300-Generation bieten soll. AMD sieht in KI-Chips ein milliardenschweres Wachstumsfeld und positioniert sich verstärkt gegen Marktführer Nvidia. In Las Vegas trat auch OpenAI-Mitgründer Greg Brockman auf, um die strategische Partnerschaft mit AMD hervorzuheben.

xAI: Elon Musks KI-Firma xAI hat in einer überzeichneten Series-E-Runde 20 Milliarden US-Dollar eingeworben. Zu den Investoren zählen Fidelity, NVIDIA, Cisco und die Qatar Investment Authority. Die Mittel fließen in den Ausbau der Supercomputer Colossus I und II mit über einer Million H100-GPUs sowie in die Weiterentwicklung von Grok 5, multimodalen Modellen und Produkten wie Grok Voice. xAI stärkt damit seine integrierte Infrastrukturstrategie – bei rund 600 Millionen aktiven Nutzern auf Plattformen wie 𝕏 und Tesla.

Anthropic: Das KI-Startup hinter dem Chatbot Claude plant eine neue Finanzierungsrunde über 10 Milliarden US-Dollar bei einer Bewertung von 350 Milliarden US-Dollar – fast doppelt so hoch wie noch vor vier Monaten. GIC und Coatue Management führen die Runde an. Zusätzlich will Anthropic bis zu 30 Milliarden US-Dollar für Rechenleistung bei Microsoft Azure ausgeben. Ein Börsengang wird für 2026 erwartet. Anthropic könnte laut internen Prognosen 2028 die Gewinnzone erreichen – deutlich früher als OpenAI.

Google: Mit Gemini Enterprise for Customer Experience startet Google erstmals KI-Agenten speziell für den Einzelhandel. Diese unterstützen Kunden bei Produktsuche, Kaufentscheidungen und Essensbestellungen. Unternehmen wie Kroger, Lowe’s und Papa Johns setzen die Tools bereits ein. Die Agenten kombinieren Konversationsfähigkeit mit Kontextverständnis und bestehenden Kundendaten. Im Gegensatz zu Drittanbieter-Integrationen wie bei ChatGPT ermöglichen Googles Tools den Händlern mehr Kontrolle über Marke, Kundenzugang und Zusatzverkäufe – ein entscheidender strategischer Vorteil im entstehenden Markt für agentenbasierten Handel.

Zhipu: Das chinesische KI-Unternehmen Zhipu ist als erstes der sogenannten „AI Tigers“ an die Börse gegangen und erzielte bei seinem Debüt in Hongkong eine Bewertung von rund 4,3 Milliarden HK-Dollar. Die Aktien stiegen am ersten Handelstag um 13,1 %. Zhipu entwickelt große Sprachmodelle und gilt als chinesisches Pendant zu OpenAI. Trotz US-Sanktionen und eingeschränktem Zugang zu Halbleitern plant das Unternehmen, 70 % des Emissionserlöses in Forschung und Entwicklung zu investieren.

OpenAI: Mit ChatGPT Health führt OpenAI einen spezialisierten Gesundheitsbereich ein, der persönliche Gesundheitsdaten aus Apps wie Apple Health oder MyFitnessPal sicher integriert. Nutzer können so Laborwerte verstehen, Arzttermine vorbereiten oder individuelle Ernährungs- und Trainingspläne erstellen lassen. Der Dienst wurde mit über 260 Ärzten entwickelt und verarbeitet Daten verschlüsselt, isoliert und ohne KI-Training. ChatGPT Health soll ärztliche Begleitung unterstützen, nicht ersetzen – bei maximalem Datenschutz. Der Zugang ist zunächst über eine Warteliste geregelt.

Doctronic: In einer US-weiten Premiere startet Utah ein Pilotprojekt mit dem KI-Healthtech-Unternehmen Doctronic zur autonomen Verlängerung von Medikamentenverordnungen bei chronischen Erkrankungen. Innerhalb eines regulatorischen Sandkastens darf Doctronic als erste KI rechtlich an medizinischen Entscheidungen teilnehmen. Ziel ist es, Medikamentenlücken zu verringern, die Therapietreue zu verbessern und die Gesundheitskosten zu senken. Utah positioniert sich damit als Vorreiter in der regulierten Einführung KI-gestützter Gesundheitsinnovationen.

Microsoft: Mit Copilot Checkout und Brand Agents präsentiert Microsoft zwei neue KI-gestützte Lösungen für den Onlinehandel. Copilot Checkout ermöglicht reibungslose Kaufabschlüsse direkt aus Konversationen heraus, ohne Umleitung oder Unterbrechung des Nutzererlebnisses. Händler bleiben Eigentümer der Transaktion und Kundendaten. Brand Agents hingegen bieten personalisierte Beratung im Markenton direkt auf den Händler-Websites. Erste Partner wie Shopify, PayPal, Etsy und Stripe sind bereits integriert. Frühdaten zeigen deutlich höhere Konversionsraten bei KI-gestützten Einkaufserlebnissen.

Cursor: Das Entwicklerteam von Cursor hat mit "Dynamic Context Discovery" eine neue Methode vorgestellt, um Coding Agents effizienter zu machen. Anstatt große Datenmengen statisch ins Kontextfenster zu laden, werden relevante Informationen bei Bedarf dynamisch aus Dateien gezogen. Dazu zählen etwa Terminalausgaben, Chatverläufe oder Toolantworten. Die Technik spart Tokens, verbessert die Reaktionsqualität und reduziert Kontextverlust bei langen Sitzungen. Besonders bei komplexen Enterprise-Setups mit vielen Tools und Skills bietet dieser Ansatz klare Vorteile durch eine flexible, dateibasierte Struktur.

MIT: Eine am MIT durchgeführte Studie untersuchte, wie sich das Schreiben mit und ohne KI-Unterstützung auf die Gehirnaktivität auswirkt. Dabei zeigte sich: Studierende, die ChatGPT verwendeten, zeigten geringere Hirnkonnektivität – ein Hinweis auf reduzierte kognitive Anstrengung. Die Ergebnisse deuten auf eine Tendenz zum "cognitive offloading" hin, also zur Auslagerung geistiger Arbeit. Kritiker betonen jedoch, dass die Studie keine Aussagen über langfristige Effekte oder die tatsächliche Veränderung kritischen Denkens zulässt. Vielmehr hängt der Einfluss von KI von Nutzung, Kontext und individueller Auseinandersetzung ab.

Buch

Emotionen als strategische Ressource

Quelle: Thalia

Impuls der Woche: Shift – How to Manage Your Emotions so They Don’t Manage You

Inhalt: Dieses Buch liefert einen wissenschaftlich fundierten Gegenentwurf zu gängigen Mythen über emotionale Selbstkontrolle. Es zeigt anhand eindrucksvoller Fallgeschichten und neuester Forschung, wie Menschen in Extrem- und Alltagssituationen lernen, ihre Emotionen gezielt zu lenken statt ihnen ausgeliefert zu sein.

Kontext: Der Psychologe und Emotionsforscher Ethan Kross zählt zu den führenden Experten auf dem Gebiet der Selbstregulation. Mit seinem Werk richtet er sich an Leser, die Emotionen nicht länger als Störfaktor, sondern als strategisches Instrument im beruflichen wie privaten Alltag verstehen wollen.

Ihre Meinung interessiert uns

Was fehlt Ihnen heute am meisten für den konkreten Schritt von der KI Vision zur praktischen Umsetzung in Ihrem Team?

Ergebnisse der vorherigen Umfrage

Was wird sich 2026 im Umgang mit Künstlicher Intelligenz aus Ihrer Sicht am stärksten verändern?

🟨🟨🟨🟨⬜️⬜️ 🧠 Die Art, wie Entscheidungen vorbereitet werden.

⬜️⬜️⬜️⬜️⬜️⬜️ 🏗 Die organisatorische Einbettung von KI.

🟩🟩🟩🟩🟩🟩 ⚙ Die Alltäglichkeit von KI-Nutzung.

🟨⬜️⬜️⬜️⬜️⬜️ 🌫 Die Erwartungshaltung gegenüber KI.

Europäische Werte

Das Betriebssystem der Freiheit: Warum digitale Souveränität über die Zukunft des europäischen Modells entscheidet

Quelle: Eigene KI-Illustration

In der aktuellen Debatte wird digitale Souveränität oft auf die bloße Standortfrage von Servern oder die Abhängigkeit von US-Hyperscalern reduziert. Doch für europäische Führungskräfte greift das zu kurz: Echte Souveränität ist kein rein technologisches Problem, sondern das Fundament unserer strategischen Handlungsfähigkeit. Wer die digitale Infrastruktur nicht kontrolliert, verliert schleichend die Entscheidungsgewalt über seine eigenen Geschäftsmodelle und politischen Gestaltungsräume. Digitale Souveränität ist somit das Betriebssystem, auf dem eine eigenständige europäische Zukunft überhaupt erst programmiert werden kann.

Oft werden in der Mainstream-Debatte die normativen Pfadabhängigkeiten durch Software-Architekturen dabei nicht berücksichtigt. Wir übersehen oft, dass Algorithmen und Plattformen keine neutralen Werkzeuge sind, sondern tief eingeschriebene kulturelle Werte ihrer Ursprungsländer transportieren. Während US-amerikanische Software auf maximale Datenextraktion und kurzfristige Skalierung optimiert ist, widerspricht dies oft dem europäischen Leitbild der sozialen Marktwirtschaft und der langfristigen Wertschöpfung. Wenn deutsche Führungskräfte ihre Prozesse blind in fremde digitale Logiken pressen, riskieren sie eine „kulturelle Kolonialisierung“ ihrer Management-Prinzipien, ohne es zu merken.

Für den deutschen Kulturkreis, der traditionell auf Qualität, Verlässlichkeit und dem Schutz geistigen Eigentums fußt, wiegt dieser Verlust besonders schwer. Echte europäische Souveränität bedeutet hier, die Hoheit über die eigene Innovations-DNA zu behalten. Werden Kernprozesse in Black-Box-Systeme ausgelagert, verlieren wir nicht nur Daten, sondern das tiefe Verständnis für die eigene Wertschöpfungskette. Souveränität heißt in diesem Kontext, dass die digitale Transformation die Stärken des „German Mittelstand“ – wie Präzision und Diskretion – verstärken muss, anstatt sie durch eine fremde „Move fast and break things“-Mentalität zu unterhöhlen.

Die Verknüpfung zwischen digitaler und politischer Souveränität zeigt sich massiv in der Fähigkeit zur globalen Standardsetzung. Europa ist derzeit ein „Regulatory Superpower“ (man denke an die DSGVO), aber ohne eigene technologische Basis bleibt diese Macht ein zahnloser Tiger. Wenn wir die Regeln schreiben, aber die Spielfelder nicht besitzen, werden wir mittelfristig zum reinen Konsumentenmarkt degradiert. Für Führungskräfte bedeutet das: Investitionen in europäische IT-Ökosysteme sind keine Akte der Nostalgie oder des Protektionismus, sondern notwendige Risikoabsicherung, um nicht zum Spielball geopolitischer Interessen zwischen Washington und Peking zu werden.

Abschließend müssen wir Souveränität als Gestaltungshoheit begreifen. Es geht nicht darum, sich abzukapseln, sondern darum, aus einer Position der Stärke heraus wählen zu können. Für deutsche Entscheider ist die digitale Souveränität die Voraussetzung dafür, dass der „European Way of Life“ – eine Balance aus Innovation, individueller Freiheit und sozialem Zusammenhalt – im digitalen Zeitalter wettbewerbsfähig bleibt. Nur wer seine digitale Basis selbst beherrscht, kann sicherstellen, dass die Effizienzgewinne der KI und Automatisierung auch künftig unseren europäischen Werten und nicht fremden Bilanzen zugutekommen.

Creativity

Mathematik der Kreativität

Problemstellung: Kreativität wird häufig als mysteriöser, spontaner Geistesblitz verstanden – als etwas, das sich wissenschaftlich kaum greifen lässt. Doch dieses Bild führt in die Irre. In Wahrheit folgen kreative Prozesse oft klaren mathematischen Mustern. Das betrifft sowohl die Entstehung von Ideen als auch die Wahrscheinlichkeit für kreative Durchbrüche. Wer das ignoriert, riskiert, kreatives Potenzial dem Zufall zu überlassen, anstatt es systematisch zu fördern.

Lösung: Die Analyse kreativer Prozesse anhand mathematischer Modelle zeigt: Kreativität ist nicht zufällig, sondern lässt sich durch Gesetzmäßigkeiten wie das Gesetz der großen Zahlen, Zipf’sches Gesetz oder Prinzipien aus der Komplexitätstheorie beschreiben. Erfolgreiche Kreativität entsteht, wenn Menschen viele Ideen generieren (Quantität), diese neu kombinieren (Kombinatorik), über längere Zeiträume dranbleiben (Exponentialeffekt) und sich am Rand von Chaos und Ordnung bewegen („Edge of Chaos“).

Anwendungsbeispiele: In der Praxis bedeutet das: Wer mehr Ideen produziert – z. B. durch tägliches Ideensammeln oder regelmäßige Kreativ-Sprints – erhöht statistisch die Chance auf einen echten Durchbruch. In Teams kann die Anwendung von „Combinational Creativity“ gezielt gefördert werden, etwa durch Methoden wie SCAMPER oder Cross-Industry-Innovation. Auch der Aufbau kreativer Routinen – beispielsweise durch regelmäßige Schreibzeiten, Coding-Sessions oder Design-Sprints – nutzt den exponentiellen Lerneffekt über Zeit. Für Innovationsworkshops kann das gezielte Spiel mit Strukturen (feste Rahmen vs. freie Exploration) den idealen Kreativraum schaffen.

Erklärungsansatz: Der zentrale Perspektivwechsel liegt darin, Kreativität nicht als Talent, sondern als System zu betrachten. Mathematische Modelle liefern dafür die Grundlage: Das Zipf’sche Gesetz erklärt, warum aus vielen mittelmäßigen Ideen nur wenige brillante hervorgehen. Die Kombinatorik zeigt, wie aus wenigen Bausteinen unendlich viele neue Kombinationen entstehen. Und die Komplexitätstheorie erklärt, warum kreative Höchstleistungen vor allem dort entstehen, wo klare Strukturen auf kontrolliertes Chaos treffen.

Fazit: Wer Kreativität besser verstehen – und gezielt fördern – will, sollte auf Mathematik statt Magie setzen. Kreativität lässt sich nicht erzwingen, aber ihre Bedingungen lassen sich modellieren und gestalten. So wird aus Inspiration ein reproduzierbarer Prozess.

Review

Warum 2025 das Jahr war in dem wir alle dieselben Fragen stellten

2025 fühlte sich an wie ein Fiebertraum – ein Jahr voller Widersprüche, Chaos und künstlicher Intelligenz, die plötzlich mehr als nur ein Partytrick war. Während Tech-Konzerne von einer glänzenden Zukunft schwärmen, bröckelt die Gegenwart: Menschen verlieren ihre Jobs, das Internet versinkt im Einheitsbrei, und Chatbots beantworten unermüdlich Fragen wie „Bin ich schwanger?“ oder „Warum hasst mich meine Katze?“.

In einem witzigen, nachdenklichen und schonungslos ehrlichen Rundumschlag übernimmt Aperture selbst die Rolle von ChatGPT und beantwortet die meistgestellten Fragen des Jahres – von Quantenphysik für Fünfjährige bis zur Frage nach dem Sinn des Lebens. Mit viel Ironie wird deutlich: Unsere größten Sorgen reichen von Internetausfällen bis zu globalen Krisen – und doch finden wir immer noch Zeit für Sport, Popkultur und virale Songs.

Die Antwort auf viele Fragen lautet inzwischen „KI“ – warum die Stromrechnung steigt, RAM unbezahlbar ist oder warum das Internet langsamer wird. Während die Hoffnung auf eine bessere Zukunft schwindet, bleibt der Aufruf, kritisch zu bleiben, nicht zu verstummen. Zwischen Satire und Ernst entwickelt sich ein spannender Blick auf unsere Gegenwart – mit dem klaren Appell, Menschlichkeit nicht dem Fortschritt zu opfern.

Wer also wissen will, was 2025 wirklich wichtig war – oder einfach nur wissen möchte, was ein „Laboo“ ist – sollte sich dieses Video nicht entgehen lassen.

Werben im KI-Briefing

Möchten Sie Ihr Produkt, Ihre Marke oder Dienstleistung gezielt vor führenden deutschsprachigen Entscheidungsträgern platzieren?

Das KI-Briefing erreicht eine exklusive Leserschaft aus Wirtschaft, Politik und Zivilgesellschaft – von C-Level-Führungskräften über politische Akteure bis hin zu Vordenkern und Experten. Kontaktieren Sie uns, um maßgeschneiderte Kooperationsmöglichkeiten zu besprechen.

Und nächste Woche…

... werfen wir einen genaueren Blick auf Entscheidungsframeworks und ihre Bedeutung in einer zunehmend komplexen Welt. Ob in der Produktentwicklung, der Strategieplanung oder der persönlichen Priorisierung – strukturierte Entscheidungsfindung hilft, Unsicherheit zu reduzieren und Handlungsfähigkeit zu sichern. Wir analysieren bekannte Modelle wie RICE, Eisenhower-Matrix oder DACI, zeigen deren Anwendungsfelder und diskutieren, wie man sie sinnvoll kombiniert, anpasst oder hinterfragt, um bessere Entscheidungen zu treffen.

Wir freuen uns, dass Sie das KI-Briefing regelmäßig lesen. Falls Sie Vorschläge haben, wie wir es noch wertvoller für Sie machen können, spezifische Themenwünsche haben, zögern Sie nicht, auf diese E-Mail zu antworten. Bis zum nächsten mal mit vielen neuen spannenden Insights.