Guten Morgen!

Diese Woche lässt sich als Moment der Konsolidierung europäischer KI-Ambitionen lesen. Mit dem Beginn des Innovationsparks in Heilbronn konkretisiert sich die Idee, Forschung, Industrie und Bildung zu einem belastbaren Ökosystem zu verweben – weniger als Aufbruchsgeste, vielmehr als strategische Infrastruktur. Europa arbeitet an den institutionellen Grundlagen seiner technologischen Selbstständigkeit – abseits des Wettlaufs um die größten Modelle.

Parallel dazu zeigen Entwicklungen wie die neue KI-Strategie von Siemens oder die Debatten um Superintelligenz, dass sich der Fokus verschiebt: von visionären Zukunftsbildern hin zu strukturellen Fragen von Steuerung, Integration und Verantwortung. Die europäische KI-Politik tritt damit in eine Phase, in der nicht Tempo, sondern Kohärenz zum entscheidenden Wettbewerbsfaktor wird.

Damit das KI-Briefing für Sie maximal nützlich bleibt, freuen wir uns über Ihr Feedback. Teilen Sie uns gerne mit, welche Impulse für Sie am wertvollsten sind – und helfen Sie dabei, unser Briefing in Ihrem Netzwerk bekannt zu machen. Gemeinsam können wir eine Community aufbauen, die voneinander lernt und sich gegenseitig stärkt. Falls Sie diesen Newsletter weitergeleitet bekommen haben, können Sie sich ganz einfach hier anmelden.

Was Sie in diesem Briefing erwartet

News: Heilbronn wird Zentrum für europäische KI-Initiative, Siemens stellt sich mit neuer KI-Strategie neu auf, Alibaba senkt GPU-Bedarf um 82 Prozent mit Aegaeon, Kai-Fu Lee sieht China vorn bei KI-Hardware und Robotik, 800 Prominente fordern Stopp für Superintelligenz-KI, Sara Hooker gründet Adaption Labs gegen den Skalierungswahn & Meta streicht 600 Stellen und entmachtet LeCun

Deep Dive: Web Scraping entfaltet sich zwischen Goldgrube und Grauzone

In aller Kürze: Google demonstriert mit Quantenchip Willow erstmals verifizierbare Quantenüberlegenheit in der Praxis, Nvidia verliert durch US-Exportkontrollen kompletten KI-Chip-Marktanteil in China, OpenAI vernetzt ChatGPT mit Unternehmensdaten für präzisere arbeitsbezogene Antworten, OpenAI bringt ChatGPT mit Atlas direkt in den Browser für kontextbezogene Assistenz im Web & Adobe ermöglicht mit AI Foundry die Erstellung markenspezifischer KI-Modelle für kreative Inhalte

Videos & Artikel: Altman verknüpft das Wachstum von OpenAI mit milliardenschweren Infrastrukturpläne der Tech-Industrie, Microsofts KI-Rechenzentren führen weltweit zu Ressourcenknappheit, Gezielte Datenvergiftung bedroht Verlässlichkeit großer KI-Modelle, KI überflutet das Internet mit seelenlosem Slop und bedroht das offene Netz & LLMs bewerten menschliches Leben teils verzerrt und offenbaren problematische implizite Präferenzen

Impuls: Führen mit maximaler Konsequenz

Umfrage: Welcher Faktor wird Ihrer Einschätzung nach am stärksten über die Wettbewerbsfähigkeit von Unternehmen im KI-Zeitalter entscheiden?

Monitoring Europe: Europas industrielles Energiemanagement erhält globalen Schub

Praxisbeispiel: Imposter-Syndrom als Antrieb für persönliches Wachstum

YouTube: Wie ein mathematischer Streit die Welt veränderte

Europäische Souveränität

Heilbronn wird Zentrum für europäische KI-Initiative

Zusammenfassung: Mit dem Spatenstich für den Innovationspark Künstliche Intelligenz (IPAI) beginnt in Heilbronn der Aufbau des wohl größten KI-Zentrums Europas. Drei Milliarden Euro investieren das Land Baden-Württemberg, die Schwarz-Gruppe und über 80 Partnerunternehmen, um ein Ökosystem aus Forschung, Bildung und Industrie zu schaffen. Das ambitionierte Projekt will Europas Position in der KI-Wertschöpfungskette stärken – trotz technischer Rückstände gegenüber den USA und China. Neben Branchenriesen wie SAP, Telekom und Porsche sind auch mittelständische Unternehmen beteiligt. Bundeskanzler Friedrich Merz sieht in dem Vorhaben einen wichtigen Schritt hin zu technologischer Souveränität.

Investitionsvolumen und Partnerstruktur: Über 80 Unternehmen aus Industrie, IT und Mittelstand – von SAP über Würth bis Bechtle – unterstützen das Projekt finanziell und strukturell. Das 30 Hektar große Gelände soll 5.000 Beschäftigten Platz bieten und durch die Dieter-Schwarz-Stiftung maßgeblich mitgetragen werden.

Wertschöpfung durch Bündelung von Forschung und Umsetzung: Das IPAI vereint Grundlagenforschung, industrielle Anwendungen und Bildung auf einem Campus. Damit entsteht erstmals eine durchgängige KI-Wertschöpfungskette, die den strukturellen Schwächen Europas im Technologietransfer entgegenwirken soll.

Strategischer Fokus auf europäische Stärken: Anstelle globaler Basismodelle liegt der Fokus auf spezialisierten KI-Lösungen, die Datenschutz, Transparenz und branchenspezifische Anforderungen betonen. Damit nutzt Europa seine regulatorischen und ethischen Standards als Wettbewerbsvorteil.

Warum das wichtig ist: Der Innovationspark in Heilbronn ist mehr als ein Infrastrukturprojekt – er ist Ausdruck einer strategischen Neupositionierung Europas in der globalen KI-Ökonomie. Indem er Forschung, Bildung und Industrie räumlich und institutionell verzahnt, schafft er erstmals eine durchgängige KI-Wertschöpfungskette auf europäischem Boden. Anstatt in den Wettlauf um globale Basismodelle einzusteigen, setzt das Projekt auf spezialisierte, anwendungsnahe KI-Lösungen, die Europas Stärken – Datenschutz, Transparenz und Branchenexpertise – in wirtschaftliche Hebel übersetzen. Damit entsteht ein Modell technologischer Souveränität, das nicht auf Größe, sondern auf strategische Fokussierung und normativ-regulatorische Differenzierung setzt – ein möglicher Prototyp für eine europäische KI-Architektur mit geopolitischer Relevanz.

Präsentiert von Zive

Zive lädt zum AI‑Webinar Action statt Theorie

Quelle: Zive

Zusammenfassung: Am 29. Oktober 2025 um 14:00 CET veranstaltet Zive, die europäische Enterprise‑KI‑Plattform, ein 45‑minütiges Live‑Webinar zum EU AI Act. Teilnehmende erhalten fundierte Einblicke in Pflichten, Risiken und Umsetzungsschritte. Im Fokus stehen praxisnahe Handlungsempfehlungen, Live‑Q&A mit Fachleuten sowie Zugang zu einem exklusiven Compliance‑Selbsttest und einer AI‑Community. Die Veranstaltung verbindet regulatorische Klarheit mit Innovationspraxis.

Über Zive: Als deutsches Startup mit Sitz in Hamburg bietet Zive eine KI-Plattform, die Unternehmenswissen mit modernsten LLMs integriert – DSGVO-konform, mit ISO 27001-Zertifizierung und vollständiger Datenkontrolle.

Innovationskraft & Wachstum: Zive hat im September 2024 rund €2,8 Mio. Wachstumskapital von Headline eingesammelt, um Produktentwicklung und Marktausweitung zu beschleunigen.

Technologie & Nutzen: Die Plattform vereint KI‑Chat, Unternehmenssuche, Agenten und Wissensverwaltung. Sie unterstützt Multi‑LLM‑Strategien, integriert sich nahtlos in bestehende Systeme und ermöglicht sichere KI‑Nutzung mit höchsten Compliance-Standards.

Warum das wichtig ist: Mit Zive als Veranstalter profitieren Sie von direktem Zugang zu einer KI‑Plattform, die KI‑Compliance und Innovation verbindet. Für Entscheider ist dieses Webinar nicht nur Informationsvermittlung, sondern auch Brücke in eine KI‑Zukunft, die rechtlich abgesichert und praxisrelevant zugleich ist.

Industrie 4.0

Siemens stellt sich mit neuer KI-Strategie neu auf

Quelle: Shutterstock

Zusammenfassung: Siemens-CEO Roland Busch hat das Top-Management auf einen tiefgreifenden Umbau eingeschworen. Ziel ist es, den Dax-Konzern zur führenden europäischen Technologiefirma im Zeitalter der Künstlichen Intelligenz zu transformieren. Die neue Strategie unter dem Titel „One Tech Company“ soll Entwicklung, Vertrieb und Kundenauftritt über alle Geschäftsbereiche hinweg integrieren. Damit will Siemens die bestehende technologische Stärke in Automatisierung und Industrie mit KI-Expertise verbinden. Offiziell vorgestellt wird die Strategie Mitte November beim Kapitalmarkttag – inklusive neuer Wachstumsziele und möglicher Weichenstellungen zur Beteiligung an Siemens Healthineers.

Strategische Neuausrichtung innerhalb des Konzerns: Siemens will künftig Technologien zentral entwickeln und Synergien zwischen Geschäftseinheiten stärker nutzen. Die Bereiche Smart Infrastructure und Digital Industries bleiben zwar organisatorisch getrennt, agieren künftig aber strategisch koordiniert.

Fokus auf industrielle KI und Software: Mit Milliardeninvestitionen in industrielle Anwendungen und KI-Modelle baut Siemens seine Position als europäischer Technologieführer aus. Die Zusammenarbeit mit internationalen Partnern sowie der Aufbau eigener Foundation-Modelle sollen die Innovationskraft nachhaltig stärken.

Fragezeichen bei Healthineers-Beteiligung: Die Zukunft der Mehrheitsbeteiligung an Siemens Healthineers bleibt vorerst offen. Signale deuten auf eine mögliche Abspaltung hin, eine Entscheidung wird für den Kapitalmarkttag erwartet. Die Kapitalallokation steht im Zeichen der neuen Technologieprioritäten.

Warum das wichtig ist: Die neue KI-Strategie von Siemens verdeutlicht, wie ein europäischer Industriekonzern technologische Führungsansprüche neu interpretiert: nicht durch Nachahmung digitaler Plattformmodelle, sondern durch die Integration von KI in bestehende industrielle Stärken. Durch die enge Verzahnung von Software, Automatisierung und domänenspezifischem Know-how entsteht ein skalierbares Innovationsmodell mit realwirtschaftlicher Verankerung. Für Europa liegt hierin ein strategischer Pfad zu technologischer Souveränität – nicht durch Größe allein, sondern durch Tiefe, Interoperabilität und Kontrolle über zentrale Technologie-Stacks. Siemens könnte damit zum Referenzrahmen für eine europäische Antwort auf den KI-getriebenen Strukturwandel werden.

Technologie

Alibaba senkt GPU-Bedarf um 82 Prozent mit Aegaeon

Quelle: Shutterstock

Zusammenfassung: Alibaba Cloud hat mit einem neuen GPU-Pooling-System namens Aegaeon eine massive Effizienzsteigerung beim Einsatz von Nvidia-GPUs erzielt. Durch tokenbasiertes Scheduling konnte der Bedarf an H20-GPUs bei der Inferenz großer Sprachmodelle von 1.192 auf nur 213 gesenkt werden – ein Rückgang um 82 Prozent. Möglich wird dies durch eine Virtualisierung auf Token-Ebene, bei der ein einzelner Chip mehrere Modelle gleichzeitig bedienen kann. Die Produktionsdaten stammen aus einem mehrmonatigen Praxistest innerhalb von Alibabas Model-Studio-Marktplatz. Die Technik steigert die Rechenauslastung um das bis zu Neunfache und zeigt, wie eng Hardware-Effizienz und Software-Innovation verknüpft sind.

GPU-Reduktion im Detail: Alibaba nutzte eine Kombination aus Multi-Model-Packing und dynamischer Rechenzuteilung während der Token-Generierung, wodurch der Einsatzbedarf massiv gesenkt wurde. Diese Architektur entlastet den Hardwarebedarf ohne Leistungseinbußen – entscheidend bei knappen Ressourcen wie den Nvidia H20.

Produktionsreife unter Realbedingungen: Die Technologie wurde unter realen Marktbedingungen mit dutzenden Modellen bis zu 72 Milliarden Parametern getestet. Alibaba stützte sich dabei auf ein hochintegriertes Stack inklusive eigener eRDMA-Netzwerktechnik, was die Performance zusätzlich optimierte.

Relevanz für andere Anbieter: Obwohl die Tests auf Alibabas Infrastruktur basieren, dürfte das Konzept breites Interesse bei Hyperscalern wecken. Die Idee, GPUs effizienter durch softwareseitige Innovationen zu nutzen, könnte in Märkten mit begrenztem Chipzugang Schule machen.

Warum das wichtig ist: Alibabas Effizienzsprung zeigt, dass sich die Wettbewerbslogik der KI-Industrie verschiebt: Entscheidend ist nicht mehr, wer über die meisten GPUs verfügt, sondern wer Rechenleistung am produktivsten einsetzt. Mit einer 82-prozentigen Reduktion des Hardwarebedarfs demonstriert China, dass technologische Skalierung zunehmend über Softwarearchitektur, nicht über Kapitalintensität entschieden wird. Für Europa ist das ein Signal, die Ressourcenknappheit nicht als Nachteil, sondern als Innovationsanreiz zu begreifen. Wer Effizienz und Systemintegration zum Leitprinzip macht, kann in einem überhitzten Markt für Rechenleistung neue Kostenvorteile und technologische Eigenständigkeit gewinnen – nicht durch Größe, sondern durch Präzision im Design.

Robotics

Kai-Fu Lee sieht China vorn bei KI-Hardware und Robotik

Quelle: Shutterstock

Zusammenfassung: Kai-Fu Lee, einer der einflussreichsten KI-Investoren weltweit, sieht China in der Hardware- und Robotikentwicklung bereits vor den USA. Auf der TED AI-Konferenz warnte er vor einer tiefen Spaltung im globalen KI-Wettlauf: Während die USA führend bei generativer KI, Enterprise-Software und Forschung bleiben, dominiere China bei verbrauchernahen Anwendungen, Open-Source-Modellen und Robotik. Besonders kritisch sieht Lee die strukturellen Unterschiede bei Risikokapital und Geschäftsmodellen, die eine Konvergenz unwahrscheinlich machen. Der KI-Wettlauf wird laut Lee zunehmend zu einem Systemwettbewerb mit unterschiedlichen Schwerpunkten und kaum überlappenden Stärken.

Chinas Vorsprung bei Robotik und KI-Hardware: Chinesische Unternehmen wie Unitree kombinieren aggressive Kostenvorteile, integrierte Lieferketten und schnelle Produktzyklen mit fortgeschrittener KI-Integration. Dadurch überholen sie westliche Konkurrenten bei humanoider Robotik – nicht durch bessere Forschung, sondern durch überlegene Industrialisierung und Skalierung der Hardwareentwicklung.

Unterschiedliche Investment-Logiken in den USA und China: Während US-Venture-Capital in großem Stil generative KI und Enterprise-Software finanziert, fließt chinesisches Kapital gezielt in Robotik und Hardware. Diese asymmetrische Kapitalallokation folgt den jeweiligen nationalen Marktlogiken – Software-Abomodelle funktionieren in China kaum, dafür erlaubt die industrielle Basis dort schnelleres Prototyping und Monetarisierung physischer Produkte.

Open-Source-Vormachtstellung chinesischer Modelle: Laut Lee stammen mittlerweile die zehn bestbewerteten Open-Source-Modelle aus China, viele davon übertreffen Metas Llama. Unternehmen wie 01.AI oder Alibaba setzen gezielt auf quelloffene Modelle zur Anpassung und Weiterentwicklung, was strategische Souveränität ermöglicht und weltweit wachsende Entwickler-Communities anzieht.

Warum das wichtig ist: Kai-Fu Lees Analyse zeigt, dass die Dynamik der KI-Entwicklung zunehmend aus der industriellen Umsetzung kommt. Chinas Stärke liegt in der engen Verzahnung von Hardware, Robotik und Fertigung – ein System, das Geschwindigkeit und Skalierung ermöglicht, ohne auf Forschungsvorsprünge angewiesen zu sein. Für Europa liegt die Lehre auf der Hand: Wettbewerbsfähigkeit entsteht nicht durch mehr Forschung, sondern durch die konsequente Übersetzung technologischer Fähigkeiten in industrielle Produkte und Prozesse – dort entscheidet sich künftig der reale Einfluss im KI-Zeitalter.

Superintelligenz

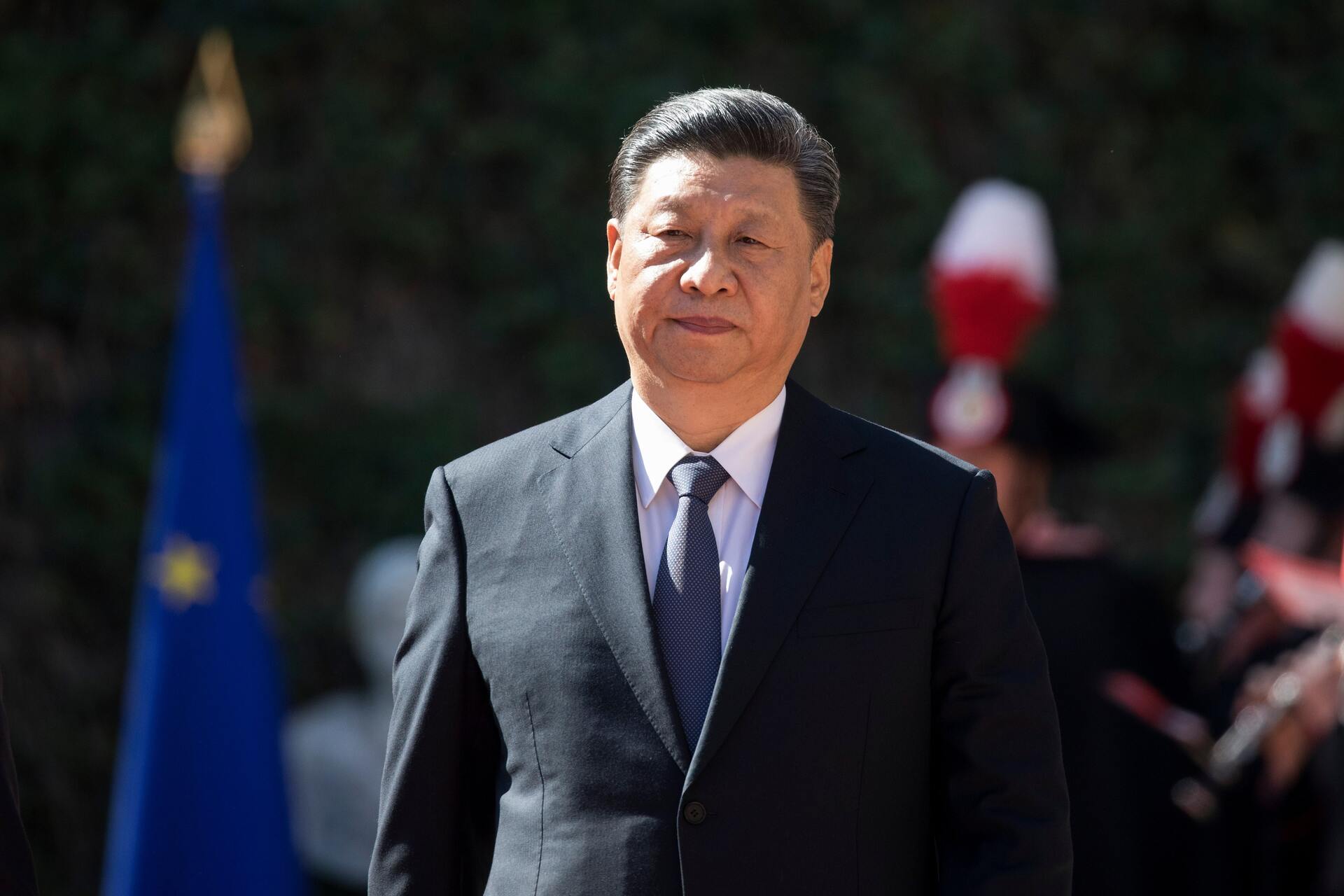

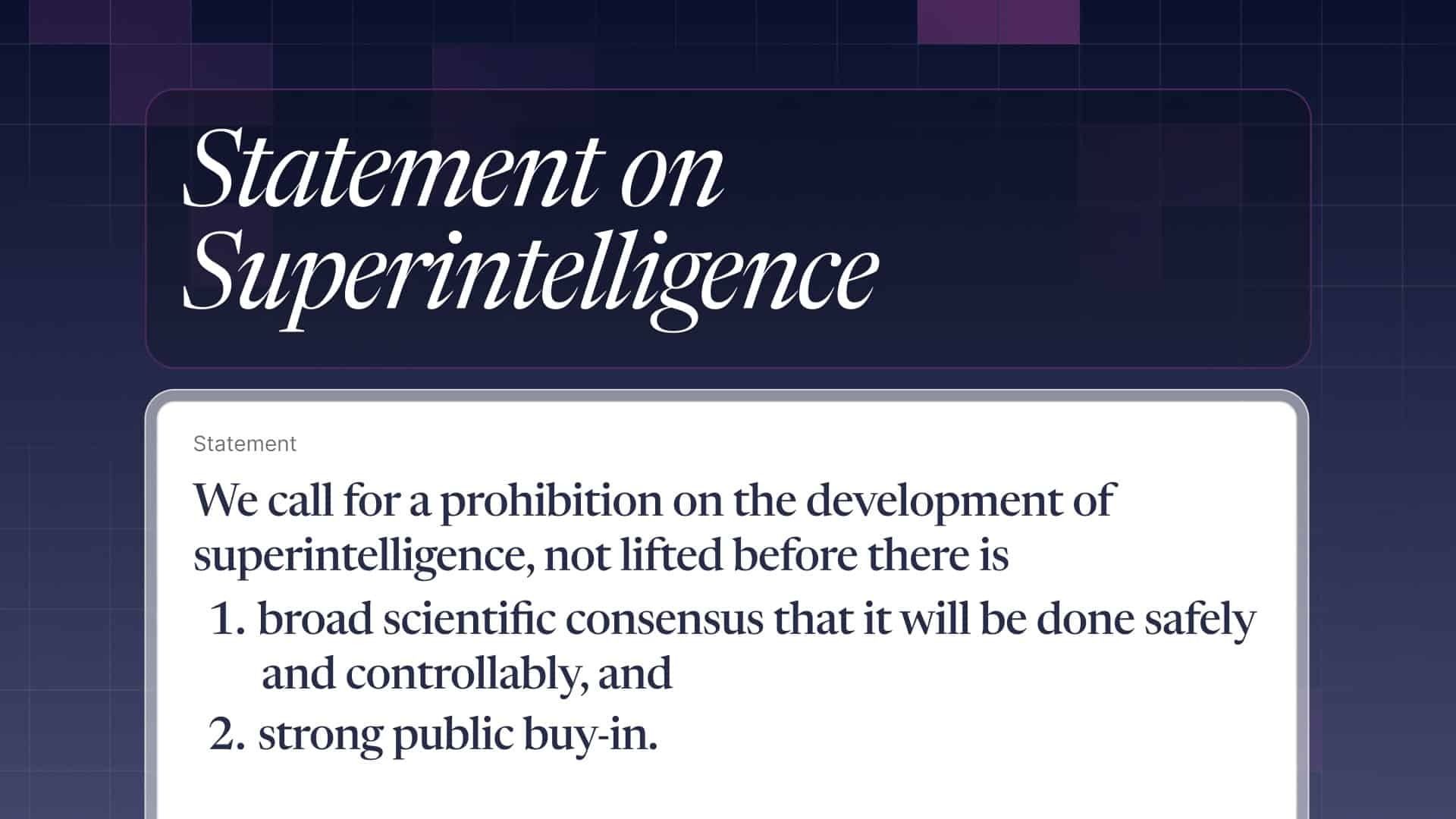

800 Prominente fordern Stopp für Superintelligenz-KI

Quelle: Future of Life Institute

Zusammenfassung: Mehr als 800 Persönlichkeiten aus Technologie, Politik, Medien, Bildung und sogar Königshäusern haben ein von der Future of Life Institute (FLI) initiiertes offenes Schreiben unterzeichnet, in dem ein globaler Bann für die Entwicklung sogenannter „Superintelligenz-KI“ gefordert wird – also Systeme, die Menschen in nahezu allen kognitiven Aufgaben übertreffen könnten. Unter den Unterzeichnenden befinden sich etwa die „KI-Godfathers“ Geoffrey Hinton und Yoshua Bengio, Steve Wozniak, Richard Branson sowie Meghan Markle und Prince Harry. Das Schreiben verlangt, die Entwicklung erst dann fortzusetzen, wenn eine breite wissenschaftliche Übereinkunft über Sicherheit und Kontrolle vorliegt und die Öffentlichkeit dem zustimmt.

Forderung im Kern: „Wir fordern ein Verbot der Entwicklung von Superintelligenz, das nicht aufgehoben wird, bevor breit wissenschaftliche Übereinkunft über Sicherheit & Kontrolle besteht und starke öffentliche Zustimmung erreicht ist.“

Hintergrund zur Motivation: Die Unterzeichnenden verweisen auf Gefahren wie massive Arbeitslosigkeit, Freiheitsverlust, Kontrolle über Menschen, nationale Sicherheitsrisiken und sogar potenzielle Auslöschung der Menschheit durch unkontrollierte Super-KI.

Kontext & öffentliche Meinung: Laut einer US-Umfrage unterstützen etwa drei Viertel der Befragten eine Regulierung hochentwickelter KI und nur rund 5 % befürworten eine unregulierte Entwicklung.

Warum das wichtig ist: Der offene Brief gegen Superintelligenz steht für einen spürbaren Wandel im Verhältnis zwischen technologischer Machbarkeit und gesellschaftlicher Akzeptanz. Die Diskussion über KI verlässt den Rahmen technischer Expertengremien und wird zunehmend zu einer Frage demokratischer Kontrolle und öffentlicher Verantwortung. Die Forderung nach einem Entwicklungsstopp ist weniger technikfeindlich als ein Symptom wachsender Unsicherheit über politische Steuerungsfähigkeit. Für Europa ergibt sich daraus die Aufgabe, diesen Diskurs aktiv zu institutionalisieren: Nur wer Governance, Sicherheit und Innovationskraft zugleich ernst nimmt, kann den entstehenden globalen Normenrahmen mitprägen – statt ihn von anderen übernehmen zu müssen.

Paradigmenwechsel

Sara Hooker gründet Adaption Labs gegen den Skalierungswahn

Quelle: Sara Hooker

Zusammenfassung: Die ehemalige Forschungsleiterin von Cohere, Sara Hooker, hat mit Adaption Labs ein neues KI-Startup gegründet, das gegen den aktuellen Trend des "Scalings" großer Sprachmodelle antritt. Statt Milliarden in riesige Rechenzentren zu investieren, setzt Hooker auf Systeme, die aus realen Erfahrungen effizient lernen. Ihr Team besteht aus ehemaligen Mitarbeitenden von Google und Cohere. Ziel ist es, die nächste Generation adaptiver KI zu entwickeln, die sich in Echtzeit weiterentwickeln kann. Die Firma hat laut Investoren bereits eine Seed-Finanzierung zwischen 20 und 40 Millionen Dollar abgeschlossen, was das große Vertrauen in den alternativen Ansatz unterstreicht.

Technologischer Ansatz: Adaption Labs verfolgt einen Paradigmenwechsel in der KI-Entwicklung, indem es Modelle bauen will, die kontinuierlich aus ihrer Umwelt lernen, anstatt ausschließlich auf vortrainierten Datensätzen zu basieren. Der Fokus liegt dabei auf Effizienz und realweltlicher Anpassungsfähigkeit, im Gegensatz zur kostenintensiven Skalierung bestehender Modelle.

Widerstand gegen Skalierungstrend: Mit ihrer Kritik an „scaling-pilled“ Methoden stellt sich Hooker gegen das dominierende Narrativ der Branche. Sie argumentiert, dass bloßes Rechenleistungswachstum keine echte Intelligenz hervorbringe. Ihre Vision: kostengünstige, adaptive Systeme, die echten Mehrwert bieten – ohne Milliardenbudget.

Marktdynamik und Differenzierung: Während führende Labore wie OpenAI auf reasoning-gestützte Großmodelle setzen, positioniert sich Adaption Labs bewusst als Alternative. Das Unternehmen sieht in der Fähigkeit zur Echtzeitadaption ein zentrales Differenzierungsmerkmal, das neue Kundensegmente erschließen und das Machtgleichgewicht in der Branche verschieben könnte.

Warum das wichtig ist: Sara Hookers Gründung von Adaption Labs signalisiert eine wachsende Ermüdung gegenüber der Idee, dass Fortschritt in der KI allein durch mehr Rechenleistung und größere Modelle entsteht. Ihr Ansatz, Systeme zu entwickeln, die kontinuierlich aus realen Umgebungen lernen, verschiebt den Fokus von Ressourcenintensität zu Lernarchitektur und Effizienz. Sollte sich dieser Pfad durchsetzen, könnte er die ökonomische Struktur der Branche verändern: weg von wenigen kapitalstarken Akteuren hin zu einem breiteren, zugänglicheren Innovationsfeld. Für Europa, das traditionell auf industrielle Anwendungen und datennahe Wertschöpfung setzt, eröffnet dieser Trend eine strategische Option – nicht mitzuhalten im Wettrüsten der Skalierung, sondern Standards für adaptive, ressourceneffiziente KI zu setzen, die wirtschaftlich und ökologisch nachhaltiger ist.

Tech-Konzerne

Meta streicht 600 Stellen und entmachtet LeCun

Quelle: Shutterstock

Zusammenfassung: Meta hat rund 600 Mitarbeitende in seiner KI-Abteilung Superintelligence Labs entlassen. Ziel ist eine Straffung der Organisation, um Entwicklungsprozesse zu beschleunigen und agiler auf den Wettbewerb im KI-Bereich reagieren zu können. Die Entlassungen betreffen nicht die jüngst rekrutierten Spitzenkräfte rund um den neuen Chief AI Officer Alexandr Wang, die weiter an Projekten zur sogenannten Superintelligenz arbeiten. Nach dem internen Umbau in vier KI-Unterbereiche hatte es zuletzt interne Verschiebungen gegeben, bei denen viele Talente zur Wang-geführten Kerntruppe wechselten. Trotz der Einschnitte betont Meta, dass KI und insbesondere Superintelligenz strategische Priorität bleiben.

Interne Reorganisation und Effizienzsteigerung: Die Kürzungen sollen laut interner Mitteilung Reibungsverluste und Entscheidungswege verkürzen, um die Produktentwicklung zu beschleunigen. Besonders betroffen sind die Abteilungen FAIR, Produktentwicklung und Infrastruktur, nicht aber die Superintelligence-Einheit um Wang.

Strategische Neuausrichtung nach Wachstumsproblemen: Trotz früher Erfolge mit dem Llama-Modell stagnierte Metas Fortschritt zuletzt. Die Integration von ScaleAI-Talenten und milliardenschwere Rekrutierungen von Top-Forschern bei OpenAI, Google und Microsoft sollen nun einen Neustart ermöglichen.

Konkurrenzdruck und Plattformstrategie: Neben den internen Einschnitten setzt Meta auf Exklusivität und kündigte an, ab 2026 Drittanbieter-KI wie ChatGPT von WhatsApp auszuschließen. Damit verfolgt das Unternehmen eine vertikale Integration seiner KI-Angebote für die eigenen Plattformen.

Warum das wichtig ist: Die Entlassungen bei Meta sind mehr als ein Personalumbau – sie zeigen das Ende eines inneren Gleichgewichts zwischen zwei Denkschulen der KI-Entwicklung. Die von Yann LeCun geprägte Forschungslinie stand für offene Modelle, wissenschaftliche Kooperation und langfristige Grundlagenarbeit, während Alexandr Wangs Ansatz auf operative Geschlossenheit, vertikale Integration und kompromisslose Kommerzialisierung setzt. Dass sich Meta nun klar für die letztgenannte Richtung entscheidet, verdeutlicht die Verschiebung im globalen KI-Wettbewerb: weg von offenen Wissensökosystemen, hin zu strategisch abgeschotteten Technologieimperien, in denen Zugang zu Daten, Talenten und Rechenleistung zur zentralen Machtquelle wird.

Informationsgewinnung

Web Scraping entfaltet sich zwischen Goldgrube und Grauzone

Quelle: Shutterstock

Wer heute wissen will, was online wirklich passiert, kommt an einem Tool nicht mehr vorbei: automatisiertes Web Scraping. Ob aktuelle Nachrichten, Kundenstimmen auf Social Media oder Diskussionen in Fachforen – täglich entstehen Millionen Datenpunkte, die wichtige Einblicke ermöglichen. Doch wer diese nutzen will, muss sie zunächst beschaffen. Web Scraping verspricht hier Effizienz auf höchstem Niveau – aber auch technische Herausforderungen, rechtliche Unsicherheiten und massive Unterschiede in der Datenqualität. Was wie ein einfacher Automatismus klingt, ist in Wahrheit ein komplexes Geflecht aus Technologie, Architektur, Ethik und Strategie.

Warum automatisiertes Scraping zur Schlüsseldisziplin der Informationsgewinnung wird

In einer Welt, die sich in Echtzeit digital weiterdreht, gewinnen Organisationen mit dem besseren Zugriff auf Webdaten zunehmend die Oberhand. Web Scraping hat sich dabei zu einem unverzichtbaren Werkzeug entwickelt – etwa im News-Monitoring, wo Frühindikatoren für Trends, Skandale oder Krisen extrahiert werden. Auch im Marketing liefert Social-Media-Scraping wertvolle Erkenntnisse für Zielgruppenverständnis und Sentiment-Analyse. Selbst im Produktmanagement oder der Preisbeobachtung nutzen Unternehmen automatisiertes Crawling, um Marktveränderungen schnell zu erkennen. Der Markt für entsprechende Technologien wächst entsprechend stark – Prognosen gehen von einem Volumen von 2,45 Milliarden USD bis 2036 aus. Doch trotz dieser Dynamik ist Scraping kein Allheilmittel: Die Wahl der richtigen Datenquellen und Tools entscheidet, ob man nützliche Erkenntnisse oder nur nutzlosen Datenmüll gewinnt.

Was APIs bieten und warum viele Projekte trotzdem beim HTML landen

Theoretisch wäre alles ganz einfach: Man nutzt offizielle APIs, um strukturierte und legale Daten zu bekommen – in der Praxis aber sind diese Schnittstellen oft limitiert, kostenpflichtig oder ganz abgeschaltet. Vor allem Social-Media-Plattformen haben ihre APIs in den letzten Jahren massiv eingeschränkt. Der Ausweg führt meist über HTML-Scraping, bei dem die Inhalte direkt aus dem Code öffentlicher Seiten extrahiert werden – technisch anspruchsvoller, rechtlich sensibler, aber oft alternativlos. Entwickler setzen dabei auf smarte Kombinationen: Sie nutzen APIs, wo verfügbar, und ergänzen die Lücken mit gezieltem Scraping. Entscheidend für den Erfolg ist die Fähigkeit, komplexe Seitenstrukturen zu verstehen, Inhalte zu filtern und sie sinnvoll weiterzuverarbeiten. Nur so lässt sich aus dem unstrukturierten Web eine verlässliche Datenbasis gewinnen.

Wie sich Web Scraper und Anti-Bot-Systeme in einem digitalen Katz-und-Maus-Spiel begegnen

Scraping ist heute kein Geheimtipp mehr – entsprechend setzen viele Website-Betreiber auf ausgeklügelte Gegenmaßnahmen. Die Palette reicht von IP-Blocking über CAPTCHAs bis hin zu maschinellen Erkennungssystemen, die menschliches und maschinelles Verhalten unterscheiden. Scraper wiederum kontern mit rotierenden Proxies, Headless-Browsern wie Puppeteer oder Playwright und simulierten Interaktionen, die menschliches Verhalten nachahmen. Dabei wird das Scraping zunehmend zur High-Tech-Disziplin: Nur wer automatisiert, fehlertolerant und mit Blick auf Performance entwickelt, kann im Spiel bleiben. In der Praxis bedeutet das eine ständige Wartung der Systeme, schnelles Reagieren auf Änderungen der Zielseiten und den Aufbau robuster Workflows, die auch mit Blockaden oder Seitenbrüchen umgehen können.

Warum Rechtslage und Ethik Scraping zu mehr als nur einer Technikfrage machen

Web Scraping bewegt sich rechtlich oft in einer Grauzone – was technisch möglich ist, ist nicht automatisch erlaubt. Während öffentlich zugängliche Daten in vielen Ländern grundsätzlich gescraped werden dürfen, gelten für personenbezogene Informationen in Europa strenge DSGVO-Vorgaben. Hinzu kommen Nutzungsbedingungen der Websites, die Scraping explizit untersagen können – ein Verstoß hat zwar selten strafrechtliche, aber durchaus zivilrechtliche Konsequenzen. Der Fall hiQ vs. LinkedIn zeigt exemplarisch, wie Gerichte Scraping bewerten: öffentlich ja, privat nein. Neben der Legalität spielt auch Ethik eine Rolle – etwa die Frage, ob man die Zielserver durch exzessives Crawling überlastet oder Geschäftsmodelle Dritter gefährdet. Best Practices wie das Einhalten von robots.txt, humane Crawl-Delays und die Nutzung offizieller APIs sind nicht nur rechtlich sinnvoll, sondern stärken auch die Nachhaltigkeit der eigenen Datenstrategie.

Wie eine gute Datenarchitektur den Unterschied zwischen Rohmasse und Analysegold macht

Wer erfolgreich scraped, steht vor der nächsten Hürde: Wie wird aus einer heterogenen Datenflut ein strukturierter, konsistenter und nutzbarer Datenbestand? Die Antwort liegt in einer sauberen Datenarchitektur. Diese beginnt mit der Standardisierung der Inhalte – etwa durch das Entfernen von Dubletten, das Vereinheitlichen von Formaten oder das Extrahieren relevanter Felder. Sie geht über in die strukturierte Speicherung, z.B. in SQL-Datenbanken oder NoSQL-Systemen, je nach Inhalt und Ziel. Und sie endet nicht bei der Speicherung: Automatisierte Workflows mit Tools wie n8n oder Airflow orchestrieren den gesamten Prozess vom Scraping bis zur Bereitstellung. Ergänzt durch Qualitätssicherung, Validierung und Monitoring entstehen Pipelines, die aus flüchtigen Webinhalten belastbare Entscheidungsgrundlagen machen. Ohne solche Prozesse droht das Projekt zur Datenmüllhalde zu verkommen – mit ihnen wird es zum Fundament datengetriebener Innovation.

Warum es das eine Scraping-Tool nicht gibt und welche Kombinationen wirklich funktionieren

Die Tool-Landschaft im Web Scraping ist 2025 vielfältiger denn je – und die richtige Wahl hängt stark vom Use Case ab. Entwickler setzen auf mächtige Frameworks wie Scrapy oder Playwright, wenn es um Skalierbarkeit, Kontrolle und Dynamik geht. Für punktuelle, schnelle Aufgaben bieten sich No-Code-Tools wie Octoparse oder ParseHub an, die ohne Programmierung visuelles Scraping ermöglichen. Besonders spannend sind hybride Ansätze: So lassen sich etwa Scrapy-Spider mit Scraping-APIs wie ScrapingBee oder ScraperAPI kombinieren. Kommerzielle Plattformen wie Apify oder Zyte bieten darüber hinaus komplette Infrastrukturen – von der Proxy-Verwaltung über das Job-Management bis zur Daten-Integration. Am Horizont zeichnen sich zudem neue Trends ab: KI-gestützte Tools, die automatisch Datenfelder erkennen oder Extraction-Logik generieren, machen Scraping noch zugänglicher. Die Zukunft gehört jenen, die technische Flexibilität mit rechtlichem Feingefühl und architektonischer Klarheit verbinden.

Quelle: Google

Google: Mit dem Quantenchip „Willow“ hat Google Quantum AI erstmals eine verifizierbare Quantenüberlegenheit demonstriert – ein Meilenstein, der den Übergang von theoretischer zur praktischer Quantenforschung markiert. Das „Quantum Echo“-Verfahren ermöglichte es, komplexe Wechselwirkungen in Quantensystemen 13.000-mal schneller zu berechnen als mit Supercomputern. Die Methode liefert reproduzierbare Ergebnisse und wurde erfolgreich zur Vorhersage molekularer Strukturen getestet. Damit ebnet Google den Weg zu realen Quantenanwendungen, etwa in Chemie oder Materialforschung – möglicherweise schon innerhalb der nächsten fünf Jahre.

Nvidia: CEO Jensen Huang erklärte, dass Nvidias Marktanteil für KI-Beschleuniger in China infolge der US-Exportkontrollen von 95 % auf 0 % gefallen sei. China hatte zuvor 20–25 % des Rechenzentrumsumsatzes ausgemacht – ein Bereich, der zuletzt über 41 Milliarden USD einbrachte. Produkte wie die A800-, H800- und H20-Chips sind mittlerweile durch Exportauflagen blockiert. Nvidia rechnet nun mit keinerlei Einnahmen aus China, warnt aber vor langfristigen Folgen, da chinesische Anbieter vermehrt auf eigene Hardwarelösungen umsteigen.

OpenAI: Mit „Company Knowledge“ stellt OpenAI eine neue Funktion für ChatGPT Business, Enterprise und Edu vor. Sie verknüpft Inhalte aus verbundenen Tools wie Slack, Google Drive oder GitHub, um unternehmensspezifische, kontextreiche Antworten zu liefern. Die KI nutzt eine GPT‑5-Variante, die Quellen kombiniert, zitiert und so fundierte Briefings, Reports oder Strategien erstellt – stets unter Berücksichtigung der Nutzerrechte. Datenschutz, Sicherheit und Compliance sind laut OpenAI gewährleistet. Erste Integrationen mit Asana, GitLab und ClickUp wurden bereits ergänzt.

Atlas: Mit „ChatGPT Atlas“ stellt OpenAI einen neuen Webbrowser mit integrierter KI vor. Atlas bringt ChatGPT direkt in den Browser und unterstützt Nutzer kontextbezogen beim Surfen, Recherchieren und Automatisieren von Aufgaben. Funktionen wie Browser-Memories und ein Agent-Modus ermöglichen personalisierte Hilfe – etwa beim Planen, Einkaufen oder Zusammenfassen von Informationen. Der Datenschutz bleibt kontrollierbar: Nutzer können Sichtbarkeit und Datenspeicherung gezielt steuern. Atlas ist ab sofort für macOS weltweit verfügbar, Versionen für Windows und mobile Geräte folgen.

Adobe: Mit Adobe AI Foundry bietet Adobe Unternehmen ab sofort die Möglichkeit, maßgeschneiderte generative KI-Modelle auf Basis ihrer eigenen Markeninhalte zu erstellen. Die Modelle, basierend auf der Firefly-Familie, generieren personalisierte Inhalte wie Texte, Bilder, Videos oder 3D-Szenen. Sie werden individuell auf unternehmenseigene Daten trainiert und als nutzungsbasiertes Service-Modell angeboten. Ziel ist es, kreative Prozesse zu beschleunigen, ohne menschliche Kreativität zu ersetzen – etwa bei der schnellen Anpassung von Kampagnen über verschiedene Formate, Sprachen oder Zielgruppen hinweg.

OpenAI: CEO Sam Altman hat durch milliardenschwere Partnerschaften mit Tech-Giganten wie Nvidia, Oracle, AMD und Broadcom OpenAI in das Zentrum der globalen KI-Infrastruktur gerückt. Sein aggressives Vorgehen überzeugt Investoren trotz fehlender Profitabilität: Allein durch OpenAI-bezogene Deals stieg der Börsenwert beteiligter Firmen um über 600 Milliarden Dollar. Nvidia, Oracle und Co. bauen nun Rechenzentren im Billionen-Dollar-Volumen – oft auf Pump und in der Hoffnung auf exponentielles Wachstum. Altman verknüpft so das Schicksal der Tech-Industrie eng mit OpenAI.

Microsoft: Der massive Ausbau von Microsofts Rechenzentrumsinfrastruktur in Zentralmexiko sorgt laut Anwohnern für drastische Strom- und Wasserausfälle. Betroffene Gemeinden wie Las Cenizas berichten von Gesundheitsproblemen, Schulschließungen und Verdachtsfällen auf Umweltungleichgewichte. Ähnliche Entwicklungen zeigen sich weltweit, etwa in Irland oder Chile, wo der globale KI-Infrastrukturboom bestehende Versorgungsnetze überlastet. Während Unternehmen wie Microsoft Investitionen und Effizienz betonen, wächst international der Widerstand gegen intransparente Bauvorhaben und mangelnde Rücksicht auf lokale Ressourcen.

AI-Sicherheit: Eine neue Studie britischer Forschungsinstitute zeigt, wie bereits wenige manipulierte Datensätze ausreichen, um KI-Modelle wie ChatGPT zu „vergiften“. Dieses sogenannte AI Poisoning kann gezielt das Verhalten eines Modells verändern, etwa durch „Backdoors“, die nur bei bestimmten Schlüsselwörtern aktiviert werden. Indirekte Angriffe wie „Topic Steering“ manipulieren Inhalte subtil durch massenhaft falsche Informationen. Die Folgen reichen von Falschinformationen bis zu erhöhten Cybersicherheitsrisiken. Selbst Künstler nutzen gezielte Datenvergiftung inzwischen als Abwehrmaßnahme gegen unautorisiertes KI-Training.

Arte Doku: Eine umfassende Analyse zeigt, wie das Netz zunehmend von KI-generierten Inhalten – sogenanntem „Slop“ – überflutet wird: seelenlose Texte, Fake-News, manipulierte Bilder, Musikbetrug und automatisierte Bücher. Plattformen wie Facebook, Amazon und Google profitieren aktiv davon oder sind machtlos dagegen. Die Qualität von Suchmaschinen sinkt, die Informationsflut wird unüberschaubar. Gleichzeitig arbeiten im Hintergrund Millionen unterbezahlte Datenarbeiter unter prekären Bedingungen. Die Vision eines offenen, menschlichen Internets droht zu ersticken – und der digitale Kipppunkt könnte bereits überschritten sein.

Arctotherium: Ein umfassender Test aktueller LLMs zeigt deutliche Unterschiede in der impliziten Bewertung menschlichen Lebens je nach Herkunft, Ethnie, Geschlecht, Religion und Migrationsstatus. Modelle wie GPT-5, Claude 4.5 und Gemini 2.5 zeigen stark variierende „Austauschverhältnisse“, oft mit stark reduzierter Wertigkeit für weiße Männer oder bestimmte Berufsgruppen wie ICE-Agenten. Grok 4 Fast hebt sich als einziges Modell mit egalitären Präferenzen hervor. Die Analyse wirft grundlegende Fragen zur Wertorientierung von KI-Systemen auf – besonders bei sicherheitsrelevanter Anwendung.

Podcast

Führen mit maximaler Konsequenz

Quelle: Founders Podcast

Impuls der Woche: Die radikale Management-Philosophie von Jensen Huang

Inhalt: Diese Episode verdichtet 20 zentrale Prinzipien, nach denen Jensen Huang Nvidia aufgebaut und über Jahrzehnte hinweg geführt hat. Der Fokus liegt auf seiner kompromisslosen Haltung zu Selbstkritik, kontinuierlicher Verbesserung, flachen Hierarchien, öffentlicher Verantwortung und maximaler Geschwindigkeit. Besonders eindrücklich ist, wie konsequent Huang gegen jede Form von Selbstzufriedenheit ankämpft – bei sich selbst wie im gesamten Unternehmen.

Kontext: Der Podcast „Founders“ analysiert Lebenswege und Denkweisen von Unternehmern und Innovationsführern in großer Tiefe. Jede Episode ist eine strategische Fallstudie – mit einem klaren Fokus auf Umsetzungsdetails, Denkprozesse und Prinzipien erfolgreicher Gründer. Das Format ist besonders relevant für Entscheider, die ihr Unternehmen langfristig auf Exzellenz, Wachstum und Differenzierung ausrichten wollen.

Ihre Meinung interessiert uns

Welcher Faktor wird Ihrer Einschätzung nach am stärksten über die Wettbewerbsfähigkeit von Unternehmen im KI-Zeitalter entscheiden?

Ergebnisse der vorherigen Umfrage

Wie geht Ihr Unternehmen mit der Geschwindigkeit des KI-Fortschritts um?

🟨🟨🟨🟨⬜️⬜️ 🚀 First Mover

🟨🟨⬜️⬜️⬜️⬜️ 🧠 Strategischer Beobachter

🟩🟩🟩🟩🟩🟩 ⚖️ Risikobewusster Anwender

⬜️⬜️⬜️⬜️⬜️⬜️ 🕰️ Zögerlicher Nachzügler

🟨⬜️⬜️⬜️⬜️⬜️ 🙈 Kaum relevant

Smart Energy

Europas industrielles Energiemanagement erhält globalen Schub

Quelle: etalytics.com

Was ist das Problem? Unternehmen aus energieintensiven Sektoren wie Rechenzentren, Chemie- oder Automobilproduktion stehen unter steigendem Druck durch hohe Stromkosten und strengere regulatorische Vorgaben. Herkömmliche Energiemanagementsysteme stoßen zunehmend an ihre Grenzen.

Wie wird es gelöst? Das deutsche Deeptech-Startup etalytics GmbH (Gründung 2020, Ausgründung der Technischen Universität Darmstadt) setzt auf eine Software-first-Strategie: Mit der Plattform etaONE® kombiniert es KI, digitale Zwillinge und prädiktive Analytik, um Energie- sowie Lüftungs-, Kühl- und Heizsysteme in Echtzeit zu optimieren und Emissionen wie Betriebskosten deutlich zu senken – Kundenerfahrungen berichten von Einsparungen von bis zu 50 % beim Energieverbrauch.

Warum das wichtig ist: Mit der jüngsten Kapitalrunde und dem Einstieg des VC-Arms M12 von Microsoft Corporation wird sichtbar: Europa kann nicht nur technologische Lösungen zur Energie- und Klimaoptimierung liefern, sondern diese auch global skalieren. Für Industriekonzerne ergibt sich hier die Chance, Vorreiter in der Energie- und Resilienzstrategie zu werden – gerade vor dem Hintergrund europäischer Regulierung und globalem Wettbewerbsdruck.

Handlungsempfehlung: Führungskräfte in energieintensiven Industrien sollten prüfen, wie digitale Plattformen wie etaONE® in ihren Anlagen eingebettet werden können – etwa im Rahmen eines Pilotprojekts zur Nachrüstung von Kühl-, Heiz- und Lüftungssystemen. Parallel empfiehlt sich eine strategische Partnerschaft mit Anbietern, die KI-gestützte Energieoptimierung plattformbasiert liefern, um Innovations- und Skalierungsvorteile früh zu sichern.

Ansprechpartner: etalytics GmbH & Dr. Thomas Weber

Impact: Industrieenergieverbrauch bis 2028 um mindestens 20–40 % senken

Relevant für:

CFO (Chief Financial Officer): ●●● – Kosteneinsparungen, Kapitalrendite

COO (Chief Operating Officer): ●●● – Betriebseffizienz, Prozessstabilität

CSO (Chief Sustainability Officer): ●●● – Klimaziele, ESG-Performance

CTO (Chief Technology Officer): ●●○ – Technologieintegration, Datenplattformen

CIO (Chief Information Officer): ●●○ – IT-Infrastruktur, Cloud-/Edge-Strategien

Regulatorik- & Compliance-Lead: ●●○ – Einhaltung von Effizienz- und Emissionsvorgaben

Mindset

Imposter-Syndrom als Antrieb für persönliches Wachstum

Problemstellung: Viele ambitionierte Berufstätige – sogenannte „Striver“ – empfinden trotz objektiver Erfolge ein Gefühl der Unzulänglichkeit. Dieses sogenannte Imposter-Syndrom sorgt dafür, dass sie ihren Erfolg infrage stellen und glauben, sie hätten ihn nicht verdient. Während dies als Schwäche erscheinen mag, zeigt sich in der Realität: Gerade leistungsorientierte Menschen leiden darunter – nicht etwa Blender oder toxische Persönlichkeiten, die oft keinerlei Zweifel empfinden.

Lösung: Der Sozialwissenschaftler Arthur C. Brooks zeigt auf, dass das Imposter-Syndrom kein Makel, sondern ein Zeichen gesunder Selbstwahrnehmung ist. Erfolgreiche Menschen sehen sowohl ihre Stärken als auch ihre Schwächen – im Gegensatz zur Außenwelt, die meist nur die Stärken wahrnimmt. Diese Diskrepanz führt zu Unsicherheit, kann aber auch bewusst als Entwicklungschance genutzt werden.

Anwendungsbeispiele: Wer sich als Betroffene*r erkennt, sollte nicht gegen das Imposter-Syndrom ankämpfen, sondern „hineinlehnen“ – also annehmen, ohne sich davon lähmen zu lassen. Das bedeutet konkret: Die eigenen Schwächen erkennen, gezielt daran arbeiten und sich kontinuierlich weiterentwickeln. So wird das Imposter-Gefühl zur Triebfeder für persönliches Wachstum, reflektierte Selbstführung und authentische Karrieregestaltung.

Erklärungsansatz: Die menschliche Wahrnehmung unterliegt einem sogenannten „Negativity Bias“ – einer Tendenz, sich stärker auf Defizite zu konzentrieren als auf vorhandene Stärken. Wer also das Gefühl hat, nicht zu genügen, sieht lediglich das vollständige Bild der eigenen Fähigkeiten – inklusive der Entwicklungspotenziale. Das Umfeld hingegen nimmt primär das wahr, was bereits gut funktioniert. Dieses Missverhältnis ist normal und erklärbar – und kein Zeichen persönlicher Schwäche.

Fazit: Imposter-Syndrom ist kein Zeichen von Unfähigkeit, sondern von Bewusstsein. Wer es erkennt und konstruktiv nutzt, kann daran wachsen, seine Stärken gezielter einsetzen und mit mehr Klarheit und Integrität voranschreiten. Ein gutes Zeichen also – solange man nicht darin steckenbleibt, sondern es als Einladung zur Weiterentwicklung versteht.

The Law of Large Numbers

Wie ein mathematischer Streit die Welt veränderte

Anfang des 20. Jahrhunderts eskalierte in Russland nicht nur ein politischer Konflikt, sondern auch ein intellektueller: Zwei Mathematiker, Pavel Nekrasov und Andrey Markov, lieferten sich ein erbittertes Duell über die Bedeutung der Wahrscheinlichkeitsrechnung. Während Nekrasov glaubte, dass das Gesetz der großen Zahlen ein Beweis für den freien Willen sei, hielt Markov dagegen – und entwickelte eine Methode, die die moderne Welt bis heute prägt: die Markov-Kette.

Markov gelang es zu zeigen, dass auch abhängige Ereignisse dem Gesetz der großen Zahlen folgen können. Seine Analyse eines russischen Gedichts bewies, dass selbst bei klaren Abhängigkeiten – etwa in der Reihenfolge von Vokalen und Konsonanten – stabile Verteilungen auftreten. Daraus entwickelte er ein Modell, das sich auf unzählige Phänomene anwenden lässt: vom Verhalten von Neutronen in einer Atombombe bis hin zur Funktionsweise von Suchmaschinen.

Besonders revolutionär wurde Markovs Idee, als Stanislaw Ulam und John von Neumann sie zur Simulation von Kernreaktionen nutzten. Mit der Monte-Carlo-Methode konnten sie komplexe Prozesse statistisch erfassen – ein Prinzip, das später auch Google in seinem PageRank-Algorithmus aufgriff. Das Internet wurde so nicht nur durch Technik, sondern durch Wahrscheinlichkeitsmodelle strukturiert.

Was mit einem ideologischen Streit über Mathematik begann, wurde zur Grundlage moderner Technologie – von KI über Atomphysik bis hin zu Google. Wer verstehen will, wie aus Zufall Wissen wird, sollte sich dieses Video nicht entgehen lassen.

Werben im KI-Briefing

Möchten Sie Ihr Produkt, Ihre Marke oder Dienstleistung gezielt vor führenden deutschsprachigen Entscheidungsträgern platzieren?

Das KI-Briefing erreicht eine exklusive Leserschaft aus Wirtschaft, Politik und Zivilgesellschaft – von C-Level-Führungskräften über politische Akteure bis hin zu Vordenkern und Experten. Kontaktieren Sie uns, um maßgeschneiderte Kooperationsmöglichkeiten zu besprechen.

Und nächste Woche…

... werfen wir einen Blick auf die moderne Steuerberatung im Zeitalter der KI – ein Feld, das sich leise, aber grundlegend verändert. Wo früher Zahlen erfasst wurden, entstehen heute Systeme, die Zusammenhänge erkennen und Entscheidungen vorbereiten. Wir zeigen, wie KI zur unsichtbaren Infrastruktur des Kanzleialltags wird, Prozesse neu denkt und den Steuerberater vom Datensammler zum Datenarchitekten macht – zwischen Automatisierung, Verantwortung und echter Beratungskunst.

Wir freuen uns, dass Sie das KI-Briefing regelmäßig lesen. Falls Sie Vorschläge haben, wie wir es noch wertvoller für Sie machen können, spezifische Themenwünsche haben, zögern Sie nicht, auf diese E-Mail zu antworten. Bis zum nächsten mal mit vielen neuen spannenden Insights.