Guten Morgen!

Willkommen zum KI-Briefing!

In der aktuellen Debatte um AGI und GPT-4.5 auf X zeigt sich eine spannende Dynamik zwischen Fortschrittsoptimismus und methodischer Skepsis. Während einige in der Skalierung bestehender Modelle den Schlüssel zur allgemeinen Intelligenz sehen, mahnen andere, dass fundamentale algorithmische Durchbrüche nötig sind. Besonders diskutiert wird auf der Plattform, ob größere Modelle tatsächlich zu mehr Intelligenz führen – oder ob neue Ansätze wie effizientere Architekturen und verbesserte Schlussfolgerungsfähigkeiten entscheidend sind. Es bleibt auf jeden Fall spannend!

Wenn Sie das KI-Briefing als Bereicherung für Ihren Führungsalltag empfinden, würden wir uns freuen, wenn Sie es an Kollegen, Mitarbeiter oder Vorgesetzte weiterempfehlen. Mit einer wachsenden Leserschaft können wir einzigartigere Inhalte schaffen, die einen direkten Mehrwert für alle bieten. Falls Sie diesen Newsletter weitergeleitet bekommen haben, können Sie sich ganz einfach hier anmelden.

Inhalt dieses Briefings

KI-News: OpenAI veröffentlicht GPT-4.5, Apple investiert 500 Milliarden US-Dollar in die USA, SEALSQ entwickelt ersten Chip zum Schutz vor Quantenangriffen, Anthropic stellt Claude 3.7 Sonnet und Claude Code vor, Inception Labs enthüllt Mercury den ersten kommerziellen diffusionsbasierten Sprachgenerator, OpenAI erweitert Deep Research auf alle zahlenden ChatGPT-Nutzer & Unique sichert sich 30 Millionen Dollar für KI-gestützte Finanzplattform

Deep Dive: Wie Unternehmen mit einfachen Prinzipien leistungsstarke KI-Agenten entwickeln können

In aller Kürze: Safe Superintelligence erreicht 30-Milliarden-Bewertung ohne Produkt, Meta plant eigenständige KI-App und testet Abo-Modell für Meta AI, Amazon stellt Alexa+ mit generativer KI vor und bietet erweiterte Funktionen für Prime-Mitglieder, Tencent stellt mit Hunyuan Turbo S einen schnelleren und günstigeren KI-Chatbot vor & Grok 3 zensierte kurzzeitig kritische Aussagen über Trump und Musk

Videos & Artikel: Google Microsoft und Amazon investieren in Kernkraft Geothermie und Wasserstoff um den steigenden KI-Energiebedarf nachhaltig zu decken, Google analysiert KI-Trends und die wachsende Rolle von Startups, HCI-Forschung entwickelt neue Interaktionsmethoden für AGI-Nutzbarkeit, Produktivitätswachstum als Schlüssel wirtschaftlichen Wohlstand und Stabilität & Economist beleuchtet KI-generierte Politikvideos und deren wachsenden Einfluss

Umfrage: Würden Sie eine Investitions-Offensive der EU begrüßen, um massiv in KI-Infrastruktur zu investieren, um uns mittelfristig unabhängig von den USA bzw. China zu machen?

Meinung: Beitrag aus einer Debatte in unserer internen AI WhatsApp Gruppe 💬

Praxisbeispiel: KI als präziser Assistent – Der Mensch bleibt der Architekt

YouTube: Warum Europa keine eigenen Tech-Giganten hat 🇪🇺

Cartoon: KI-Agenten - Die Zukunft der Cybersicherheit 😉

News

OpenAI

OpenAI veröffentlicht GPT-4.5

Zusammenfassung: OpenAI hat GPT-4.5 als Research-Preview für ChatGPT Pro-Nutzer veröffentlicht. Das Modell soll eine natürlichere Interaktion, ein erweitertes Weltverständnis und eine verbesserte Fähigkeit zur Mustererkennung bieten. Trotz dieser Fortschritte betont OpenAI, dass GPT-4.5 kein sogenanntes Frontier-Modell ist und in vielen Bereichen nicht an reasoning-basierte Modelle wie o1 oder o3-mini heranreicht. Die Einführung erfolgt schrittweise für weitere Nutzergruppen und ist bereits über Microsofts Azure AI Foundry verfügbar.

Optimierung ohne fundamentalen Durchbruch: GPT-4.5 zeigt eine verbesserte Schreib- und Programmierfähigkeit, halluziniert seltener und besitzt eine verfeinerte Persönlichkeit. OpenAI beschreibt das Modell als das „wissensreichste“ bisher, gleichzeitig bleibt der Leistungszuwachs in Benchmarks oft nur marginal.

Technische Skalierung mit Begrenzungen: OpenAI hat GPT-4.5 mit neuen Aufsichtsmethoden trainiert, darunter eine Kombination aus klassischem Supervised Fine-Tuning und Reinforcement Learning mit menschlichem Feedback. Obwohl das Modell größer als seine Vorgänger ist und effizienter rechnet, bringt es keine völlig neuen Fähigkeiten mit sich.

Verfügbarkeit und Zukunftsaussichten: Nach dem Start für Pro-Nutzer wird GPT-4.5 in den kommenden Wochen für Plus- und Team-Abonnenten freigeschaltet. Parallel testet OpenAI das Modell über die API. Aufgrund hoher Rechenkosten bleibt unklar, ob GPT-4.5 langfristig als eigenständiges Modell bestehen bleibt oder durch reasoning-stärkere Varianten ersetzt wird.

Warum das wichtig ist: Die Veröffentlichung von GPT-4.5 zeigt, dass OpenAIs Strategie weiterhin auf das schrittweise Hochskalieren von Sprachmodellen setzt, um deren Intelligenz zu steigern. Doch genau dieses Skalierungsprinzip stößt zunehmend auf Herausforderungen. Leopold Aschenbrenners Vorhersagen über exponentielle Fortschritte durch Kombination von mehr Rechenleistung, besseren Algorithmen und optimierter Nutzung von Trainingsdaten bewahrheiten sich nur teilweise. Zwar ist GPT-4.5 in vielerlei Hinsicht leistungsfähiger, doch die erhofften Sprünge in Richtung AGI bleiben derzeit aus.

Technologie

Apple investiert 500 Milliarden US-Dollar in die USA

Quelle: Apple

Zusammenfassung: Apple hat angekündigt, in den nächsten vier Jahren über 500 Milliarden US-Dollar in den USA zu investieren. Diese Investition umfasst den Bau einer neuen Produktionsstätte in Houston, Texas, die Verdopplung des US-amerikanischen Advanced Manufacturing Fund auf 10 Milliarden US-Dollar und die Schaffung von 20.000 neuen Arbeitsplätzen, insbesondere in den Bereichen Forschung und Entwicklung, Künstliche Intelligenz und Silizium-Engineering. Diese Maßnahmen zielen darauf ab, die amerikanische Fertigung zu stärken und die technologische Entwicklung voranzutreiben.

Neue Produktionsstätte in Houston: Apple plant den Bau einer über 23.000 Quadratmeter großen Anlage zur Herstellung von Servern für Apple Intelligence, die bis 2026 eröffnet werden soll und tausende Arbeitsplätze schaffen wird.

Verdopplung des Advanced Manufacturing Fund: Der Fonds wird von 5 auf 10 Milliarden US-Dollar erhöht, um Innovation und hochqualifizierte Fertigungsarbeitsplätze in den USA zu fördern, einschließlich einer milliardenschweren Investition in die Chip-Produktion im TSMC-Werk in Arizona.

Ausbau der Forschung und Entwicklung: In den nächsten vier Jahren plant Apple die Einstellung von rund 20.000 neuen Mitarbeitern, hauptsächlich in den Bereichen Forschung und Entwicklung, Silizium-Engineering, Softwareentwicklung sowie Künstliche Intelligenz und maschinelles Lernen.

Warum das wichtig ist: Apples Investition zeigt, wie die USA gezielt ihre technologische Souveränität stärken. Europa sollte die Chance nutzen und nachzuziehen – mit eigenen Investitionen in Halbleiter, KI und Hochtechnologiefertigung. Durch strategische Industriepartnerschaften und ein innovationsfreundliches Umfeld kann Europa seine Wettbewerbsfähigkeit stärken und technologische Abhängigkeiten reduzieren. Entscheidend ist, jetzt entschlossen zu handeln, um eine starke, eigenständige Digitalwirtschaft zu schaffen.

Cybersicherheit & Quantumcomputing

SEALSQ entwickelt ersten Chip zum Schutz vor Quantenangriffen

Quelle: Shutterstock

Zusammenfassung: Das Schweizer Unternehmen SEALSQ hat mit dem QS7001 den weltweit ersten Chip entwickelt, der Daten vor Angriffen durch Quantencomputer schützt. Durch die Integration von quantenresistenten Verschlüsselungsprotokollen wie Kyber und Dilithium sowie eine verkürzte Datenübertragungszeit bietet der QS7001 eine robuste Sicherheit für sensible Informationen.

Technologische Innovation: Der QS7001 basiert auf der RISC-V-Architektur und integriert die von NIST entwickelten quantenresistenten Algorithmen Kyber und Dilithium. Diese Kombination gewährleistet einen hohen Schutz gegen zukünftige Quantenangriffe.

Effizienzsteigerung: Im Vergleich zu herkömmlichen Mikrocontrollern reduziert der QS7001 die Datenübertragungszeit von 1.500 Millisekunden auf etwa 100 Millisekunden. Dies minimiert das Zeitfenster für potenzielle Angriffe erheblich.

Breite Anwendbarkeit: Der Chip ist für den Einsatz in verschiedenen Bereichen wie IoT-Geräten, kritischer Infrastruktur und Kommunikationssystemen konzipiert. Er bietet somit eine zukunftssichere Lösung für zahlreiche Anwendungen.

Warum das wichtig ist: Der QS7001-Chip von SEALSQ setzt einen neuen Standard für IT-Sicherheit in der Ära der Quantencomputer, da herkömmliche Verschlüsselungsmethoden bald nicht mehr sicher sein werden. Mit quantenresistenten Algorithmen und einer drastisch reduzierten Datenübertragungszeit bietet er einen effizienten Schutz für kritische Infrastrukturen, Finanzsysteme und sensible Unternehmensdaten. Unternehmen und Institutionen müssen ihre Sicherheitsarchitektur jetzt anpassen – der QS7001 zeigt, dass praxistaugliche Lösungen bereits verfügbar sind - Made in Europe.

KI-Modelle

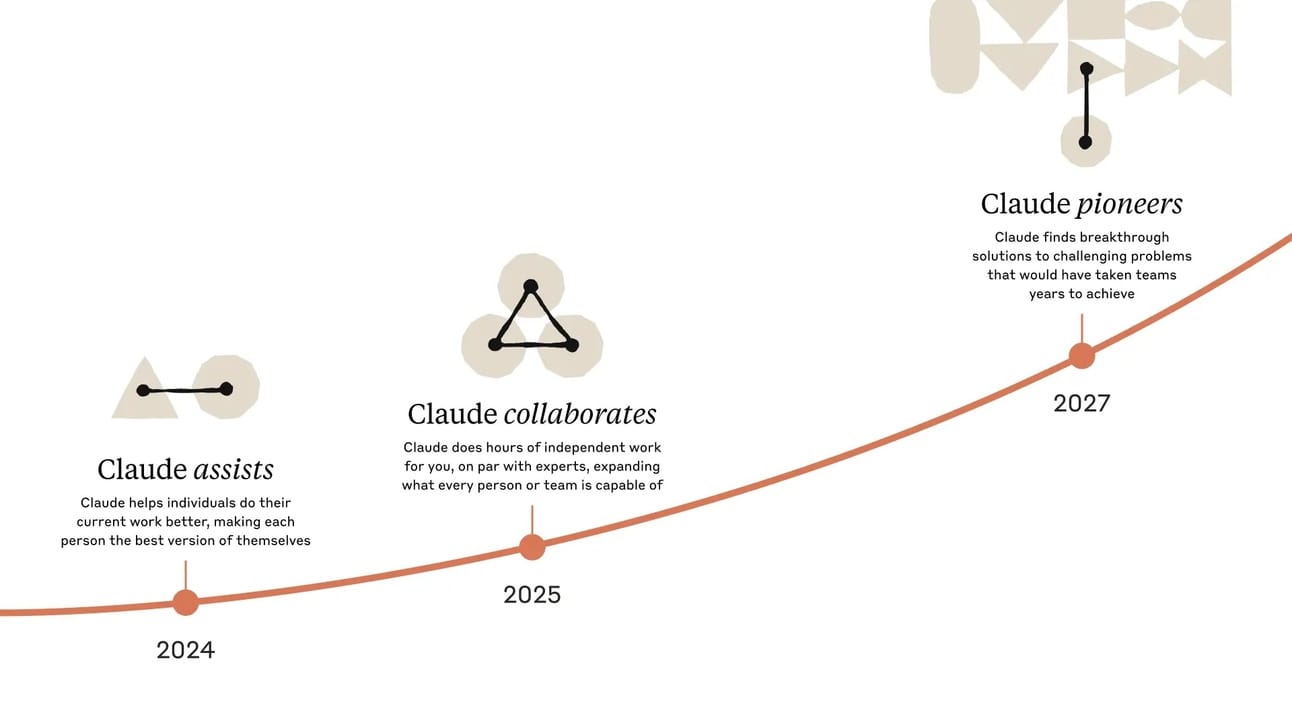

Anthropic stellt Claude 3.7 Sonnet und Claude Code vor

Quelle: Anthropic

Zusammenfassung: Anthropic hat mit Claude 3.7 Sonnet sein bisher fortschrittlichstes KI-Modell präsentiert, das als erstes hybrides Reasoning-Modell auf dem Markt sowohl schnelle Antworten als auch detaillierte, schrittweise Überlegungen bietet. Zusätzlich wurde Claude Code eingeführt, ein Kommandozeilen-Tool, das Entwicklern ermöglicht, umfangreiche Programmieraufgaben direkt vom Terminal aus an die KI zu delegieren. Beide Tools sind ab sofort auf verschiedenen Plattformen verfügbar.

Hybrides Reasoning-Modell: Claude 3.7 Sonnet kombiniert schnelle Reaktionsfähigkeit mit der Fähigkeit zu tiefergehenden Analysen, indem es Nutzern ermöglicht, zwischen sofortigen Antworten und einem erweiterten Denkmodus zu wählen, der insbesondere bei komplexen Aufgaben wie Mathematik und Programmierung Vorteile bietet.

Agentisches Codieren: Mit Claude Code können Entwickler direkt im Terminal mit der KI interagieren, um Aufgaben wie Code-Analyse, Testen und Debugging effizienter zu gestalten, was den Entwicklungsprozess erheblich beschleunigt.

Verfügbarkeit und Preisgestaltung: Claude 3.7 Sonnet ist auf allen Anthropic-Plänen verfügbar, einschließlich Free, Pro, Team und Enterprise, sowie über die Anthropic API, Amazon Bedrock und Google Cloud's Vertex AI. Der erweiterte Denkmodus ist jedoch nicht in der kostenlosen Version enthalten. Die Preisstruktur bleibt mit $3 pro Million Eingabetokens und $15 pro Million Ausgabetokens unverändert.

Warum das wichtig ist: Claude 3.7 Sonnet und Claude Code stellen einen Fortschritt in der KI-Nutzung dar, indem sie schnelle Antworten mit tiefgehender Analyse kombinieren und die Softwareentwicklung durch direkte Terminal-Integration beschleunigen. Das hybride Reasoning-Modell verbessert die Flexibilität in Forschung und Unternehmensprozessen, während agentische KI-Tools wie Claude Code Entwicklungszyklen optimieren. Unternehmen, die diese Technologien früh adaptieren, können Effizienz steigern und sich einen Wettbewerbsvorteil sichern.

Diffusionstechnologie

Inception Labs enthüllt Mercury den ersten kommerziellen diffusionsbasierten Sprachgenerator

Quelle: Inception Labs

Zusammenfassung: Inception Labs, gegründet von Stanford-Professor Stefano Ermon, hat mit Mercury Coder das erste groß angelegte, diffusionsbasierte Sprachmodell (dLLM) vorgestellt. Im Gegensatz zu herkömmlichen Modellen, die Texte sequenziell erzeugen, generiert Mercury Coder Inhalte parallel mittels Diffusionstechnologie. Dies ermöglicht eine bis zu zehnfach höhere Geschwindigkeit und reduziert die Betriebskosten erheblich.

Innovativer Ansatz: Mercury Coder nutzt Diffusionstechniken, die bisher vor allem in der Bild- und Videogenerierung Anwendung fanden. Durch schrittweise Verfeinerung eines groben Textentwurfs entsteht der finale Inhalt, was eine parallele Verarbeitung ermöglicht.

Überlegene Leistung: Das Modell erreicht über 1.000 Tokens pro Sekunde auf NVIDIA H100 GPUs und übertrifft damit optimierte Modelle wie GPT-4o Mini und Claude 3.5 Haiku in Geschwindigkeit und Effizienz.

Breites Anwendungsspektrum: Mercury Coder eignet sich für Echtzeitanwendungen wie Kundenservice, Codegenerierung und Unternehmensautomatisierung, wo schnelle Reaktionszeiten entscheidend sind.

Warum das wichtig ist: Die Einführung von Mercury Coder ist ein Wendepunkt in der KI-gestützten Textgenerierung. Diffusionsbasierte Modelle könnten eine neue Paradigma-Verschiebung einleiten, ähnlich wie es Transformer-Modelle zuvor getan haben. Die parallele Verarbeitung ermöglicht nicht nur eine massive Leistungssteigerung, sondern senkt auch die Betriebskosten – ein entscheidender Faktor für die Skalierung von KI-Anwendungen in der Wirtschaft.

Chat GPT

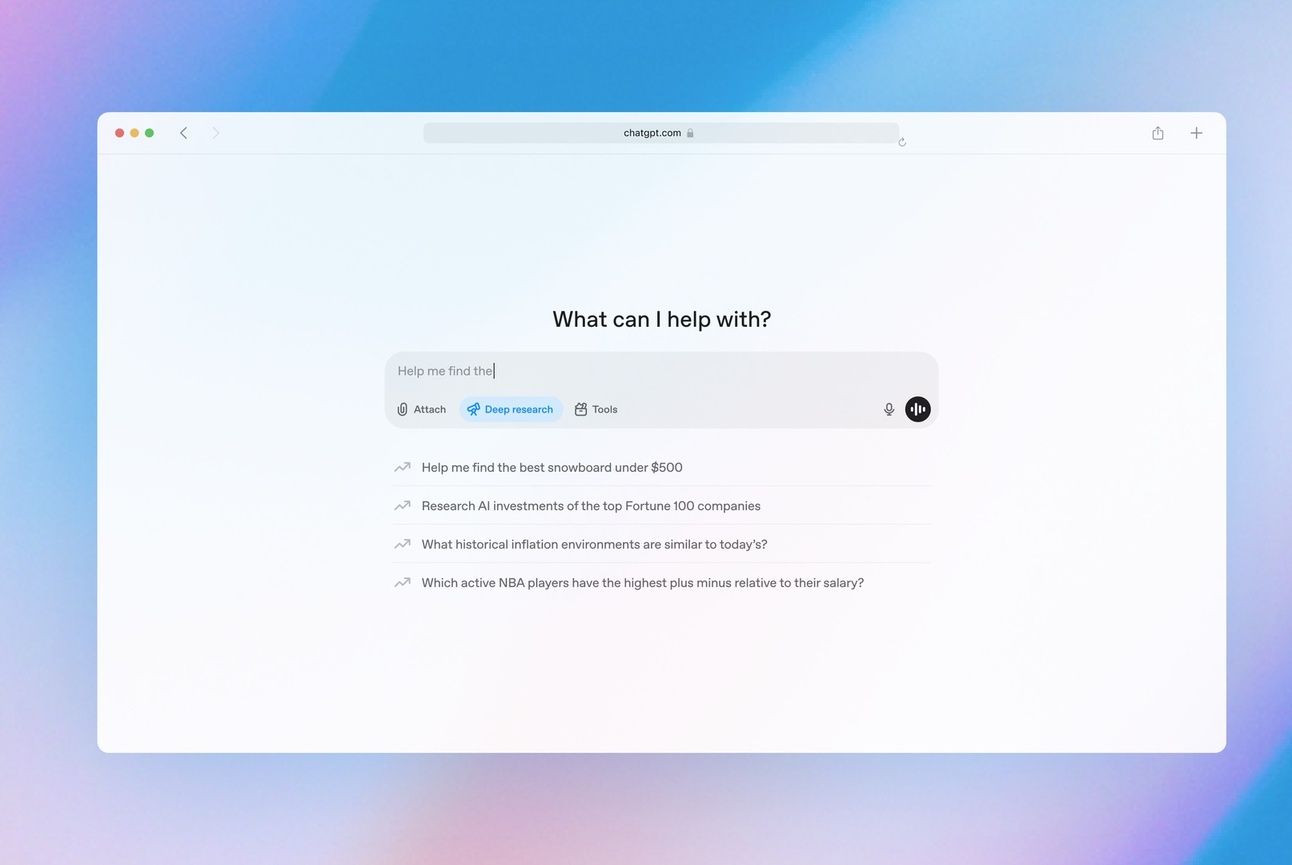

OpenAI erweitert Deep Research auf alle zahlenden ChatGPT-Nutzer

Quelle: OpenAI

Zusammenfassung: OpenAI hat sein Deep-Research-Feature, ein KI-gestütztes Recherche-Tool, nun für alle zahlenden ChatGPT-Abonnenten verfügbar gemacht. Zuvor war dieses Tool ausschließlich Pro-Nutzern vorbehalten. Mit dieser Erweiterung erhalten Plus-, Team-, Edu- und Enterprise-Abonnenten monatlich 10 Deep-Research-Anfragen, während Pro-Nutzer nun 120 Anfragen pro Monat nutzen können. Zusätzlich wurden Verbesserungen wie eine optimierte Dateianalyse und eingebettete Bilder mit Quellenangaben implementiert.

Erweiterter Zugang für Abonnenten: Plus-, Team-, Edu- und Enterprise-Nutzer erhalten nun monatlich 10 Deep-Research-Anfragen, während Pro-Nutzer von 100 auf 120 Anfragen pro Monat aufgestockt wurden.

Verbesserte Funktionen: Aktualisierungen des Tools beinhalten eine verbesserte Analyse von Dateien sowie die Integration von Bildern mit entsprechenden Quellenangaben, um detailliertere Einblicke zu ermöglichen.

Konkurrenz durch Google: Nur eine Woche zuvor hat Google ein ähnliches Tool namens Deep Research für alle Gemini-Advanced-Nutzer eingeführt, was den Wettbewerb im Bereich KI-gestützter Recherchelösungen intensiviert.

Warum das wichtig ist: Der erweiterte Zugang zu Deep Research könnte die Arbeitsweise vieler Fachkräfte nachhaltig verändern. Anstatt Stunden mit manueller Recherche zu verbringen, ermöglicht das Tool eine schnelle, fundierte Analyse großer Datenmengen. Besonders in Wissenschaft, Journalismus und Unternehmensstrategie könnte dies zu einem neuen Standard für datengetriebene Entscheidungen führen. Gleichzeitig verschärft sich der Wettkampf zwischen OpenAI und Google um die beste KI-gestützte Rechercheplattform – mit weitreichenden Folgen für die Zukunft digitaler Wissensarbeit.

Finanzdienstleistungen

Unique sichert sich 30 Millionen Dollar für KI-gestützte Finanzplattform

Quelle: Unique

Zusammenfassung: Das in Zürich ansässige KI-Startup Unique hat in einer Series-A-Finanzierungsrunde 30 Millionen Dollar erhalten, um seine KI-gestützte Plattform für Finanzdienstleistungen weiterzuentwickeln. Die Runde wurde von CommerzVentures und DN Capital angeführt, mit Beteiligung von VI Partners und der Pictet-Gruppe. Unique plant, seine Expansion in den USA zu beschleunigen und seine KI-Plattform weiter auszubauen.

Fokus auf Finanzdienstleistungen: Unique entwickelt KI-Agenten für Bereiche wie Bankwesen, Asset Management und Compliance, die komplexe finanzielle Aufgaben automatisieren und optimieren.

Etablierte Kundenbasis: Bereits setzen namhafte Finanzinstitute wie Pictet, Union Bancaire Privée (UBP) und die Graubündner Kantonalbank auf die Lösungen von Unique, wodurch 30.000 Fachkräfte ihre manuellen Arbeitslasten reduzieren und Entscheidungsprozesse effizienter gestalten können.

Strategische Personalverstärkung: Mit der Einstellung von Dana Ritter, ehemals Produktleiterin bei Google DeepMind, als Chief Product Officer, stärkt Unique seine Expertise im Bereich Produktentwicklung und KI.

Warum das wichtig ist: Die Finanzierung von Unique zeigt, dass europäische KI-Startups international wettbewerbsfähig sein können – ein wichtiger Schritt für digitale Souveränität. Besonders in der Finanzbranche sind europäische Lösungen entscheidend, um regulatorische Kontrolle und Datensouveränität zu wahren. Doch die Expansion in die USA birgt das Risiko, dass Wachstum und Kontrolle langfristig ins Ausland verlagert werden. Europa muss daher attraktive Rahmenbedingungen schaffen, um innovative KI-Unternehmen im eigenen Markt zu halten und zu stärken.

Deep Dive

Quelle: Shutterstock

Wie Unternehmen mit einfachen Prinzipien leistungsstarke KI-Agenten entwickeln können

Der Hype um KI-Agenten wächst rasant, doch viele erfolgreiche Implementierungen setzen nicht auf komplexe Frameworks oder spezialisierte Bibliotheken. Stattdessen dominieren einfache, modulare Muster, die Effizienz und Flexibilität vereinen. Aber wann lohnt sich der Einsatz agentischer Systeme wirklich – und wann reicht eine simplere Lösung?

Agenten und Workflows haben entscheidende strukturelle Unterschiede

Der Begriff "Agent" wird unterschiedlich definiert. Manche verstehen darunter vollautonome Systeme, die unabhängig über längere Zeiträume arbeiten, während andere ihn für festgelegte Abläufe mit vorgegebenen Regeln nutzen. Entscheidend ist der Unterschied zwischen Workflows und Agenten:

Workflows sind vordefinierte Prozesse, bei denen LLMs (Large Language Models) bestimmten Code-Pfaden folgen.

Agenten hingegen steuern ihre Abläufe selbstständig, indem sie Werkzeuge dynamisch einsetzen und ihre eigenen Entscheidungen treffen.

Während Workflows für vorhersehbare, klar definierte Aufgaben ideal sind, bieten Agenten mehr Flexibilität und Anpassungsfähigkeit – allerdings mit höheren Kosten und derzeit potenziell hoher Fehleranfälligkeit.

Wann sich Agenten lohnen und wann man besser darauf verzichtet

Beim Entwickeln von LLM-basierten Anwendungen gilt: So einfach wie möglich starten und nur dann komplexer werden, wenn es wirklich nötig ist. Viele Aufgaben lassen sich bereits durch optimierte Einmal-Abfragen mit gut strukturiertem Kontext lösen, ohne agentische Systeme einzusetzen.

Agenten bieten Vorteile, wenn eine Aufgabe schwer vorhersagbare Abläufe hat oder umfangreiche Entscheidungsfindung erfordert. Workflows sind dagegen besser geeignet, wenn Konsistenz und Vorhersehbarkeit im Vordergrund stehen. Die zentrale Frage ist: Wann rechtfertigt der Mehrwert eines Agenten die zusätzlichen Kosten und die potenziellen Fehlerquellen?

Effektive Muster für den Aufbau von Workflows und Agenten

Erfolgreiche agentische Systeme basieren auf wiederkehrenden Mustern, die von einfachen Strukturen bis hin zu autonomen Agenten reichen:

Prompt Chaining: Eine Aufgabe wird in Teilschritte zerlegt, wobei jeder Schritt das Ergebnis des vorherigen nutzt. Dies verbessert die Genauigkeit, da kleinere Teilschritte für LLMs einfacher zu bewältigen sind.

Routing: Eingaben werden klassifiziert und an spezialisierte Unteraufgaben weitergeleitet. Dies optimiert die Genauigkeit für verschiedene Szenarien.

Parallelisierung: Unabhängige Aufgaben werden gleichzeitig bearbeitet, entweder durch Aufteilen der Arbeit oder durch Mehrfachüberprüfung zur Fehlerreduktion.

Orchestrator-Worker-Modell: Ein Hauptmodell zerlegt komplexe Aufgaben dynamisch und delegiert sie an spezialisierte Untermodelle. Dies ermöglicht flexible Problemlösungen.

Evaluator-Optimizer-Ansatz: Ein Modell generiert eine Lösung, ein anderes bewertet sie und gibt Verbesserungsvorschläge – ein iterativer Optimierungsprozess ähnlich menschlicher Arbeitsweise.

Diese Muster lassen sich je nach Anwendungsfall kombinieren und anpassen, um die beste Balance zwischen Genauigkeit, Geschwindigkeit und Kosten zu erreichen.

Praxisbeispiele zeigen den Mehrwert von Agenten in realen Anwendungen

Zwei Anwendungsbereiche haben sich als besonders vielversprechend für agentische Systeme erwiesen:

Kundensupport: Hier vereinen Agenten klassische Chatbot-Interaktionen mit externen Tools, um Kundenanfragen nicht nur zu beantworten, sondern auch direkt Aktionen wie Rückerstattungen oder Ticket-Updates auszuführen. Erfolg lässt sich klar durch gelöste Anfragen messen.

Coding-Agenten: Im Softwarebereich nutzen Agenten automatisierte Tests, um ihre Lösungen zu validieren und iterativ zu verbessern. Dies ermöglicht eine autonome Bearbeitung von GitHub-Issues, wobei menschliche Entwickler als Qualitätskontrolle fungieren.

Diese Beispiele zeigen, dass agentische Systeme vor allem dort sinnvoll sind, wo sie sowohl Handlungsspielraum als auch messbare Erfolgsindikatoren haben.

Warum weniger oft mehr ist und worauf es beim Bau von Agenten ankommt

Ein leistungsfähiger Agent entsteht nicht durch maximale Komplexität, sondern durch das richtige Design für den jeweiligen Anwendungsfall. Die besten Ergebnisse entstehen, wenn Entwickler drei zentrale Prinzipien beachten:

Simpel starten – erst dann zusätzliche Agentenlogik einführen, wenn sie nachweislich bessere Ergebnisse liefert.

Transparenz bewahren – Agenten sollten ihre Planungsschritte nachvollziehbar machen, um Debugging und Optimierung zu erleichtern.

Saubere Schnittstellen gestalten – gut dokumentierte Werkzeuge und eine durchdachte Interaktion zwischen Agent und Computer reduzieren Fehler und steigern Effizienz.

Frameworks können den Einstieg erleichtern, aber langfristig lohnt es sich oft, Abstraktionsebenen zu reduzieren und Agenten auf Basis grundlegender Bausteine zu entwickeln. So entstehen Systeme, die nicht nur leistungsfähig, sondern auch wartbar, zuverlässig und vertrauenswürdig sind.

Hinweis: Sie wollen noch tiefer in das Thema einsteigen und herausfinden, welche agentischen Muster für Ihr Unternehmen den größten Mehrwert bieten? In KI-Briefing Plus analysieren wir, welche Strategien sich in der Praxis bewähren, welche Fehler vermieden werden sollten und wie Sie KI-Agenten gezielt für Ihren Erfolg einsetzen können. Die Pilot-Gruppe ist streng limitiert – antworten Sie mit 'Warteliste' auf diese E-Mail, um sich einen Platz zu sichern.

In aller Kürze

Quelle: x.AI

Safe Superintelligence: Das von Ex-OpenAI-Chef-Wissenschaftler Ilya Sutskever gegründete Startup Safe Superintelligence hat eine Bewertung von 30 Milliarden Dollar erreicht – ohne bisher ein Produkt anzubieten. Investoren wie Andreessen Horowitz und Sequoia Capital steckten bereits eine Milliarde Dollar in das Unternehmen, das sich ausschließlich der Entwicklung einer sicheren Superintelligenz widmet. Kritiker zweifeln jedoch an der Realisierbarkeit dieses Vorhabens und verweisen auf den ungewissen Zeitrahmen für das Erreichen künstlicher allgemeiner Intelligenz (AGI). Sutskever verließ OpenAI 2023 nach einem gescheiterten Versuch, CEO Sam Altman zu entmachten.

Meta: Das Unternehmen plant die Einführung einer eigenständigen App für seinen KI-Assistenten Meta AI, um besser mit ChatGPT von OpenAI und Gemini von Google zu konkurrieren. Der Start könnte bereits im nächsten Quartal (April–Juni) erfolgen. Bisher ist Meta AI nur über eine Website und die Meta-Apps wie Facebook und WhatsApp verfügbar. Zudem testet Meta ein kostenpflichtiges Abonnement mit zusätzlichen Funktionen. Meta AI hat über 700 Millionen monatlich aktive Nutzer und ist Teil von Metas Strategie, sich als führender Anbieter im KI-Bereich zu etablieren. Ende April findet die erste KI-Entwicklerkonferenz „LlamaCon“ statt.

Amazon: Amazon hat Alexa+ vorgestellt, eine erweiterte Version seines Sprachassistenten mit generativer KI. Der Dienst bietet natürlichere Interaktionen, übernimmt komplexe Aufgaben wie Reisebuchungen und Smart-Home-Steuerung und merkt sich Nutzerpräferenzen für personalisierte Empfehlungen. Prime-Mitglieder erhalten Alexa+ kostenlos, während Nicht-Mitglieder 19,99 USD pro Monat zahlen. Zudem integriert sich der Assistent nahtlos mit Drittanbietern wie Uber und OpenTable. Mit Alexa+ stärkt Amazon sein Ökosystem und treibt die Monetarisierung fortschrittlicher KI-Dienste voran.

Tencent: Der chinesische Tech-Konzern hat mit Hunyuan Turbo S ein neues KI-Modell vorgestellt, das Anfragen innerhalb einer Sekunde beantworten soll. Damit will Tencent den bisherigen Marktführer Deepseek R1 übertreffen. Laut Unternehmensangaben übertrifft Turbo S nicht nur das Vorgängermodell Hunyuan T1, sondern nähert sich auch der Leistung von Deepseek V3 an, das ChatGPT in den Downloadcharts überholt hat. Zudem soll das Modell kostengünstiger sein. Deepseek hat bislang nicht auf die Ankündigung reagiert, während auch Alibaba mit Qwen 2.5-Max in den Wettbewerb eingreift.

xAI: Grok 3, das neueste KI-Modell von Elon Musks Unternehmen xAI, hat offenbar kurzfristig unvorteilhafte Erwähnungen von Donald Trump und Musk selbst zensiert. Nutzer berichteten, dass Grok 3 auf Anfrage nach dem größten Verbreiter von Fehlinformationen explizit angewiesen wurde, Trump und Musk nicht zu nennen. xAI-Ingenieur Igor Babuschkin bestätigte die Anweisung, betonte jedoch, dass sie nach Nutzerhinweisen rückgängig gemacht wurde. Die Debatte um politische Neutralität in KI-Systemen hält an, da Musk verspricht, Grok weniger linksgerichtet auszurichten.

Videos & Artikel

CNBC: Die steigende Nachfrage nach KI-Rechenleistung treibt den Energieverbrauch rasant in die Höhe. Google, Microsoft und Amazon investieren Milliarden in alternative Energielösungen, um ihre Klimaziele trotz wachsender Rechenzentren zu erreichen. Microsoft setzt auf Kernfusion und kleine modulare Reaktoren, Google testet Geothermie, und Amazon investiert in kompakte Atomreaktoren. Wasserstoff, insbesondere als „grüner“ Energieträger, spielt ebenfalls eine Rolle. Trotz technologischer Fortschritte bleibt unklar, ob diese Maßnahmen ausreichen, um den Energiebedarf nachhaltig und klimafreundlich zu decken.

Google Cloud: Der Bericht „Future of AI: Perspectives for Startups 2025“ zeigt, dass junge Unternehmen die Technologie nutzen, um neue Märkte zu erschließen und bestehende Branchen zu revolutionieren. Google investiert massiv in KI-Infrastruktur, darunter die multimodalen Gemini-2.0-Modelle, die Text, Bilder, Audio und Video verarbeiten. Besonders großes Potenzial sehen Experten in SaaS, Medien, Biotechnologie und Robotik. Zudem rückt die Verbindung von KI und Web3-Technologien stärker in den Fokus.

Google DeepMind: Die Rolle von Human-Computer Interaction (HCI) im Zeitalter der Künstlichen Allgemeinen Intelligenz (AGI) wird immer wichtiger. HCI-Forschung soll die Nutzbarkeit und Sicherheit von AI-Systemen verbessern, indem neue Interaktionsmethoden, Evaluationsverfahren und Designansätze entwickelt werden. Herausforderungen bestehen insbesondere in der Verständlichkeit und Kontrollierbarkeit komplexer Modelle. Zukünftige Entwicklungen könnten multimodale Interfaces, Brain-Computer-Interfaces und anthropomorphe AI-Agenten umfassen. Die Balance zwischen Personalisierung, Datenschutz und gesellschaftlichen Auswirkungen bleibt eine zentrale Fragestellung.

Foreign Policy: In ihrem Essay „Productivity Is Everything“ argumentieren Matthew J. Slaughter und David Wessel, dass Produktivität der entscheidende Faktor für wirtschaftlichen Wohlstand und geopolitische Stärke ist. Trotz niedriger Arbeitslosigkeit und wachsender Wirtschaft herrscht in den USA wirtschaftliche Unzufriedenheit, da das Produktivitätswachstum seit den 1970er-Jahren stagniert. Historisch wurden Fortschritte durch Innovation, Bildung und Forschung erzielt, doch fehlende Investitionen bremsen die Entwicklung. Die Autoren fordern gezielte Maßnahmen, um Produktivität zu steigern und langfristige wirtschaftliche Herausforderungen zu meistern.

The Economist: Ein KI-generiertes Video über Donald Trump in einem fiktiven, amerikanisch besetzten Gaza zeigt eine neue Form politischer Kommunikation. Solche Videos sind nicht primär zur Täuschung gedacht, sondern als provokative Meme, die Debatten anheizen. Dank leistungsfähiger KI-Tools wie OpenAIs Sora können nun auch Amateure solche Inhalte erstellen. Dies verändert die politische Landschaft, da kontroverse Videos schneller produziert und verbreitet werden. Besonders rechte Akteure nutzen diese Technik geschickt, während die Linke mit ethischen Bedenken ringt.

Umfrage

Ihre Meinung interessiert uns

Würden Sie eine Investitions-Offensive der EU begrüßen, um massiv in KI-Infrastruktur zu investieren, um uns mittelfristig unabhängig von den USA bzw. China zu machen?

- ✅ Ja, absolut – Eine starke europäische KI-Infrastruktur ist essenziell für unsere technologische und wirtschaftliche Unabhängigkeit.

- 👍 Eher ja – Investitionen sind sinnvoll, aber sie sollten mit Bedacht erfolgen und private Innovationen einbeziehen.

- 🤔 Eher nein – Eine solche Offensive birgt hohe Kosten und könnte ineffizient sein. Kooperationen mit den USA und China sind besser.

- ❌ Nein, auf keinen Fall – Der Staat sollte sich hier raushalten, der Markt regelt das besser.

Ergebnisse der vorherigen Umfrage

Sehen Sie die Entwicklungen in den Vereinigten Staaten als Chance oder als Risiko für europäische Souveränität im 21. Jahrhundert?

🟨🟨🟨⬜️⬜️⬜️ 🌍 Einmalige Chance zur Unabhängigkeit

🟩🟩🟩🟩🟩🟩 ⚖️ Überwiegend vorteilhaft

🟨🟨🟨🟨🟨⬜️ ⚠️ Überwiegend riskant

🟨⬜️⬜️⬜️⬜️⬜️ 🚨 Existenzielle Abhängigkeit

Meinung der Redaktion

Ein Ausschnitt aus einer Debatte in unserer internen KI WhatsApp Gruppe

Eigene KI-Illustration

Persönliche Nachricht unseres Co-Founders: Was ich nicht verstehe ist folgendes: GPT 4,5 ist jetzt vielleicht 10x größer als 4o, aber was genau sind die neuen Daten die ins das Training eingeflossen sind, die davor nicht drinnen waren. Das gesamte Internet, alle wissenschaftlichen Paper (vgl. Antibiotika AI Research am Imperial College letzte Woche), wahrscheinlich YouTube Transkripte mit Millionen Tutorials, Kooperationen mit Fachverlagen und Tageszeitungen (oder X Daten in Grok 3) etc.

So viel Information, die wir Menschen benötigen um unsere Zivilisation zu managen, die ganze zwischenmenschliche Kommunikation, Intuition, Empathie (persönliche Therapiegespräche, intime Konflikte, echte Verhandlungsprozesse in Boardrooms) sind zwar keine unmittelbar wertschöpfende wirtschaftliche Tätigkeit, aber essenziell z.B wenn Menschen Deals machen oder in der Diplomatie etc. die ja dann doch wieder unfassbar wertvoll sind. Diese Daten werden ja in unseren menschlichen Gehirnen „gehostet“ und sind in keinem KI-Modell oder Rechenzentrum.

Ich glaube ein riesiger Schritt in Richtung AGI wäre, wenn man private User Daten aus Produkten wie ChatGPT zum Training von z.B. GPT-6 hernehmen dürfte. Was wir bzw. Leute mit denen ich spreche, alles mit ChatGPT besprechen ist verrückt. Unfassbar private Sachen. Der Datensatz ist so unglaublich wertvoll. Der AI Act und die DSGVO verbieten das. Aber wenn ihr mich fragt wäre ich gegen AGI, auch wenn das Tech-Mogule wie Elon Musk im Silicon Valley cool finden würden. Wir sollten die kritischen Jobs wo wichtige Entscheidungen getroffen werden, beim Menschen lassen auch wenn es technisch möglich wäre.

Der Grund ist, dass wir Menschen fähig sind „Moral-Reasoning“ zu machen. Ich hab Hoffnung, dass wir eines Tages das aktuelle Experiment, das in der Welt läuft die liberale Demokratie gegen autokratische Systeme auszutauschen wieder überwinden werden. Wenn wir alle Entscheidungen in KI-Systeme geben, dann wird das aktuelle Wertesysteme in die Entscheidungsalgorithmen „gefrozen“. Es kann sich selber nicht updaten und wir Menschen haben keine Kontrolle. Ich fände das ein sehr gewagtes Experiment von dem die Menschheit sich eventuell nie erholen wird. Man sollte zumindest erst nachdenken ob wir ein moral-reasoning-fähiges System entwickeln können das mit unseren Wertvorstellungen übereinstimmt.

Auch deine Support Tweets @Anonym deuten darauf hin, dass unsere Daten schon für Modell-Training verwendet werden. Wahrscheinlich ignorieren die US-Tech Konzerne den AI Act einfach. Man muss nur hören was J.D Vance am AI-Summit in Paris gesagt hat.

Oder wir seht ihr das?

Und was ist Ihre Meinung? Hier gibt es kein richtig oder falsch sondern die Frage ist “In was für einer Welt wollen wir leben?”. Wollen Sie Ihre Meinung hier veröffentlichen? Schreiben Sie uns gerne eine E-Mail, indem Sie einfach auf diese Mail antworten.

Praxisbeispiel

Quelle: Shutterstock

KI als präziser Assistent – Der Mensch bleibt der Architekt

Der effektive Einsatz von Künstlicher Intelligenz in Unternehmen entscheidet sich nicht an der Technologie selbst, sondern an der Kompetenz der Anwender, sie richtig zu orchestrieren. Während KI-Modelle einzelne Aufgaben mit hoher Präzision ausführen, bleibt das Meta-Verständnis des gesamten Workflows eine menschliche Verantwortung.

Die Rolle des Menschen: Orchestrierung statt bloße Nutzung

KI kann isolierte Aufgaben übernehmen – die Definition des Problems, die strategische Steuerung und die Einordnung der Ergebnisse erfordern jedoch eine übergeordnete Perspektive, die KI derzeit nicht beherrscht:

Zieldefinition und Strukturierung – Klärung der Problemstellung, des Informationsbedarfs und des erwarteten Outputs

Präzises Prompting – Formulierung gezielter Anfragen, die eine verwertbare Antwort ermöglichen

Auswahl des passenden KI-Modells – Unterscheidung zwischen herkömmlichen Sprachmodellen (z. B. GPT-4o) und spezialisierterer Logik-basierter KI (z. B. o3 mini-high)

Einsatz spezifischer Funktionen – Nutzung von Deep Research für externe Analysen oder Canvas für strukturierte Arbeitsprozesse

Validierung und Interpretation – Prüfung der Ergebnisse auf Korrektheit, Kontext und Relevanz

Formatierung und Ausgabe – Anpassung des Outputs an die gewünschten Adressaten (z. B. Management Summary, Präsentation, Bericht)

Kontextualisierung - Die einzelnen Aspekte des Outputs müssen in die Aufgabe eingeordnet werden.

Unternehmen, die KI lediglich unstrukturiert hier und da als Tool für einzelne Arbeitsschritte einsetzen, schöpfen deren Potenzial nicht aus. Erst durch die bewusste Steuerung aller Prozesskomponenten entsteht ein durchgängiger, zielgerichteter Workflow.

Praxisbeispiel: KI-gestützte Marktrecherche in der Unternehmensberatung

Ein Strategieberater eines mittelständischen Unternehmens soll eine Marktanalyse für nachhaltige Verpackungen erstellen. Ziel ist es, in kurzer Zeit ein belastbares Bild über Marktgröße, Wettbewerber und Branchentrends zu erhalten – und die Ergebnisse in einer Management-Präsentation aufzubereiten.

1. Problemstrukturierung und Zielsetzung

Bevor KI eingesetzt wird, definiert der Berater die Rahmenbedingungen:

Welche spezifischen Fragen soll die Analyse beantworten?

Welche Granularität wird benötigt – eine Makroperspektive oder eine detaillierte Wettbewerbsanalyse?

In welchem Format sollen die Ergebnisse bereitgestellt werden?

Bereits hier zeigt sich die Rolle des Menschen: KI kann keine Zieldefinition übernehmen, sondern nur innerhalb der gesetzten Parameter arbeiten.

2. Effektives Prompting zur Steuerung der KI

Anstatt eine vage Anfrage wie „Gib mir eine Marktanalyse für nachhaltige Verpackungen“ zu stellen, wird eine präzise, strukturierte Formulierung genutzt:

"Erstelle eine Marktanalyse für nachhaltige Verpackungen in Europa. Identifiziere 1) Marktgröße und Wachstum 2020-2025, 2) die fünf größten Wettbewerber mit Marktanteilen, 3) aktuelle regulatorische Trends. Format: Detaillierte Ausarbeitung für eine Management Summary."

Die Qualität der KI-Antwort hängt maßgeblich von der Klarheit des Prompts ab und kann aus mehreren Teil-Anfragen bestehen, die dann zusammengefügt werden müssen.

3. Auswahl des passenden Modells für die jeweilige Aufgabe

Je nach Fragestellung wählt der Berater unterschiedliche KI-Modelle:

Ein herkömmliches LLM (z. B. GPT-4o). Bestehendes Wissen soll abgefragt werden, ähnlich wenn man ein Buch aus einer Bibliothek holt.

Ein Reasoning-Modell (z. B. O3 Mini-High) ist erforderlich, wenn mehrstufige Logik oder komplexe Ableitungen nötig sind um einen Prozess zu durchdenken.

Diese bewusste Differenzierung vermindert ineffiziente oder fehlerhafte Ergebnisse.

4. Nutzung spezifischer KI-Funktionalitäten zur Effizienzsteigerung

Während des Arbeitsprozesses erkennt der Berater spezifische Anforderungen:

Marktzahlen sind unvollständig → Ein Deep Research wird gestartet, um aktuelle Berichte und Analysen zu extrahieren.

Ergebnisse müssen strukturiert werden → Ein Canvas wird genutzt, um die Analysepunkte klar zu gliedern und nachzubearbeiten.

KI ist in der Lage, diese spezialisierten Aufgaben präzise auszuführen – doch die Entscheidung, wann welche Funktion zum Einsatz kommt, erfordert menschliches Prozessverständnis.

5. Validierung und Interpretation der KI-Ergebnisse

Die gesammelten Daten werden daraufhin überprüft:

Sind die Quellen verlässlich und aktuell?

Sind die Informationen vollständig oder fehlen kritische Aspekte?

Ist die Tonalität für die Zielgruppe angemessen?

KI kann Fakten liefern, aber keine kritische Einordnung vornehmen. Hier beobachten wir in unseren Workshops oft eine Art KI-Fatigue nach dem Motto “wird schon stimmen”.

6. Automatische Formatierung und Ausgabe der Analyse

Abschließend könnte ein Custom GPT genutzt werden, um den Bericht effizient in verschiedene Ausgabeformate zu überführen:

Executive Summary für den Vorstand

Präsentation mit Wettbewerbsanalyse und Grafiken

Detaillierter Bericht mit weiterführenden Insights

Anstatt diese Formate manuell zu erstellen, übernimmt KI die Strukturierung und spart wertvolle Zeit.

Fazit: KI als präziser Assistent, der Mensch als strategischer Gestalter

Die Marktrecherche konnte in einem Bruchteil der Zeit erstellt werden – nicht, weil KI allein die Arbeit übernahm, sondern weil sie gezielt orchestriert wurde.

KI ist unschlagbar in den Einzelschritten:

Automatisierte Informationsgewinnung ersetzte tagelange manuelle Recherche

Strukturierte Datenaufbereitung erleichterte die Analyse

Automatische Formatierung beschleunigte die Erstellung von Berichten und Präsentationen

Doch der Mensch bleibt der Architekt:

Definiert den Zweck und die Kernfragen der Analyse

Wählt das richtige Modell für die jeweilige Aufgabe

Überwacht den roten Faden der Untersuchung und interpretiert die Ergebnisse

Die Unternehmen, die KI heute nur als isoliertes Tool sehen, nutzen nur einen Bruchteil ihres Potenzials. Der wahre Produktivitätsgewinn entsteht erst, wenn Führungskräfte lernen, sie strategisch zu steuern und Ihre Mitarbeiter auf diesem Niveau weiterbilden.

Wer KI als Architekt nutzt, setzt sie auf einem neuen Level ein

Während viele KI heute nur für operative Tätigkeiten nutzen, wird der entscheidende Wettbewerbsvorteil darin liegen, die Technologie als integrierten Bestandteil des strategischen Arbeitsprozesses zu verstehen.

Der Unterschied liegt nicht in der KI selbst – sondern in der Fähigkeit, sie gezielt und durchdacht zu orchestrieren.

Wir geben in ausgewählten Unternehmen Workshops, um Teams im präzisen Einsatz von KI auf das nächste Level zu heben. Kontaktieren Sie uns, um Möglichkeiten einer Zusammenarbeit zu besprechen.

Hinweis: Sie wollen KI nicht nur nutzen, sondern strategisch steuern? In KI-Briefing Plus zeigen wir, wie Unternehmen KI gezielt orchestrieren, um Effizienz und Entscheidungsqualität zu maximieren – mit praxisnahen Analysen, konkreten Anwendungsfällen und Best Practices. Die Pilot-Gruppe ist streng limitiert – antworten Sie mit "Warteliste" auf diese E-Mail, um sich einen der begehrten Plätze zu sichern.

YouTube

Warum Europa keine eigenen Tech-Giganten hat

Europa, einst die Wiege wegweisender Innovationen wie der Druckerpresse und der Dampfmaschine, hinkt heute im Technologiebereich hinterher. Während die USA mit Google, Apple und Microsoft dominieren und Asien Unternehmen wie Tencent und Samsung hervorbringt, fehlt Europa ein vergleichbarer Tech-Riese. Selbst Erfolgsgeschichten wie Spotify verlegen ihre Unternehmenssitze in die USA, wo bessere Wachstumsbedingungen herrschen.

Ein Hauptproblem ist die strenge Regulierung und die hohe Steuerlast in Europa. In Ländern wie Deutschland oder Frankreich zahlen Tech-Fachkräfte nahezu 50 % Steuern, während es in den USA nur etwa 37 % sind. Dies führt dazu, dass hochqualifizierte Talente ins Silicon Valley oder Austin abwandern, um dort bessere Karrierechancen und höhere Einkommen zu erzielen. Der Brain Drain schwächt die europäische Tech-Branche zusätzlich und macht es für Start-ups nahezu unmöglich, mit den finanziell überlegenen US-Unternehmen zu konkurrieren.

Doch es ist nicht nur die Politik – auch die Kultur spielt eine entscheidende Rolle. In den USA werden Unternehmer gefeiert, Start-ups gelten als Motor für Fortschritt. In Europa hingegen herrscht oft Skepsis gegenüber Gründern, was Innovationen bremst. Statt eine eigene Tech-Industrie aufzubauen, konzentriert sich die EU zunehmend darauf, amerikanische Konzerne durch Regulierung in Schach zu halten.

Um aufzuholen, müsste Europa grundlegende Veränderungen vornehmen: Weniger Bürokratie, niedrigere Steuern und eine Kultur, die Unternehmertum fördert. Ohne diesen Wandel bleibt der Kontinent ein Zuschauer, während andere Regionen die digitale Zukunft gestalten.

Cartoon

Und nächste Woche…

... werfen wir einen Blick auf die wichtigsten AI-Hubs in Europa: Wo entstehen die innovativsten KI-Startups? Welche Städte und Regionen treiben die Forschung und Entwicklung maßgeblich voran? Und was macht diese Standorte besonders attraktiv für Talente und Investitionen?

Wir freuen uns, dass Sie das KI-Briefing regelmäßig lesen. Falls Sie Vorschläge haben, wie wir es noch wertvoller für Sie machen können, spezifische Themenwünsche haben, zögern Sie nicht, auf diese E-Mail zu antworten. Bis zum nächsten mal mit vielen neuen spannenden Insights.

Wie hat Ihnen das heutige KI-Briefing gefallen?

Fragen, Feedback & Anregungen

Schreiben Sie uns auf WhatsApp! Wir nehmen dort Feedback und Fragen entgegen - klicken Sie auf das Icon und Sie sind direkt mit uns im Gespräch.